O número de descarregamentos de Tongyi Qianqian Qwen ultrapassou os 40 milhões, "gerando" mais de 50.000 modelos infantis.

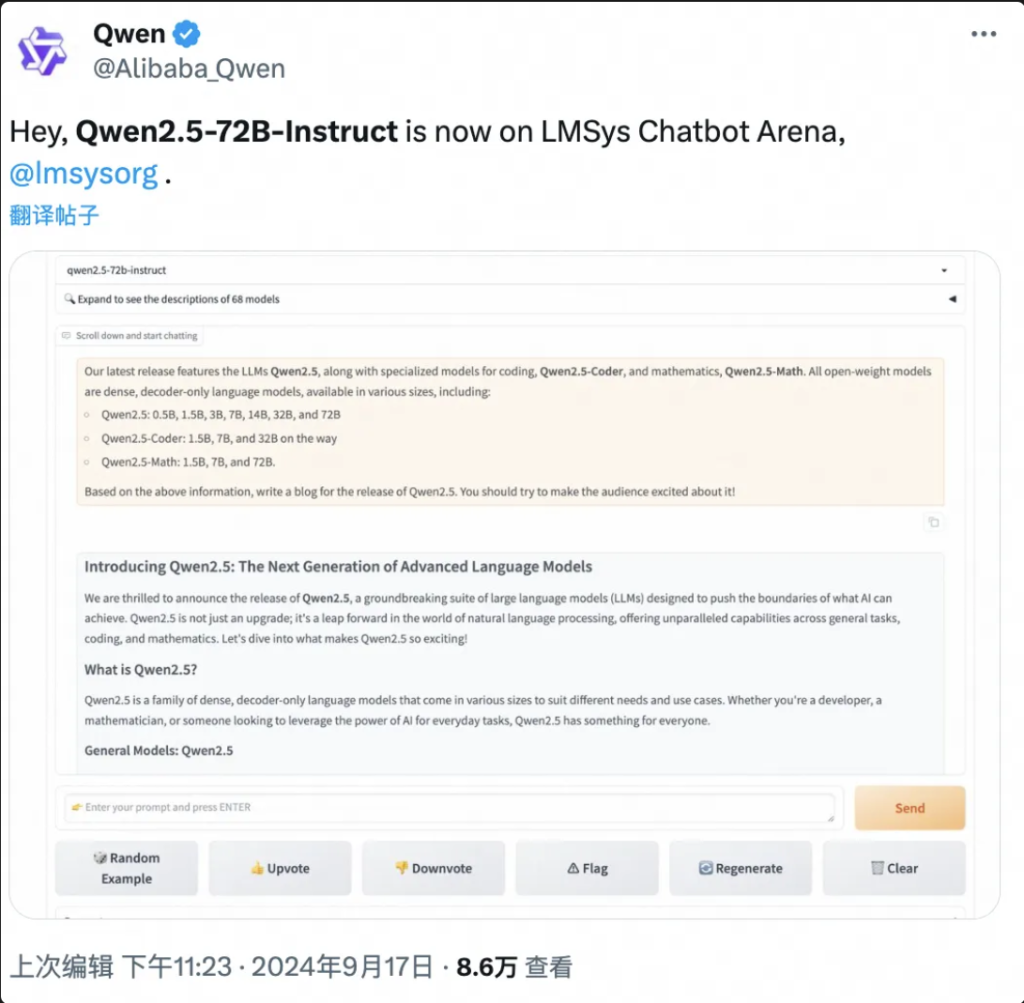

Não BS deixe primeiro teste Qwen aqui:

Abertura da Conferência Yunqi da "Gala do Festival da primavera" sobre computação em nuvem, o grande modelo Tongyi Qwen explodiu mais uma vez em toda a cena!

Segundo a Wise Things, em 19 de setembro, em Hangzhou, Ali Cloud lançou hoje o modelo de grande dimensão de fonte aberta mais forte do mundo, o Qwen2.5-72B, com um desempenho "de medida cruzada" superior ao do Llama3.1-405B, e, em seguida, no trono do modelo global de grande dimensão de fonte aberta.

Segue-se um resumo dos resultados do trabalho realizado no âmbito deste projeto

O Qwen2.5-72B supera o Llama-405B em muitos testes oficiais.

Ao mesmo tempo, uma grande série de modelos Qwen2.5 foi então aberta, incluindo: o modelo de linguagem Qwen2.5, o modelo de linguagem visual Qwen2-VL-72B, o modelo de programação Qwen2.5-Coder e o modelo matemático Qwen2.5-Math, etc., com um total acumulado de mais de 100 nas prateleiras, e alguns deles alcançando o desempenho do GPT-4o para estabelecer um novo recorde mundial.

É uma quinta-feira louca", "produto épico" ...... Nas poucas horas que se seguiram ao seu lançamento, o Qwen2.5 desencadeou um frenesim de discussão nas redes sociais nacionais e estrangeiras, e os programadores de todo o mundo juntaram-se à equipa de testes.

▲Qwen2.5 é um tema quente nas redes sociais no país e no estrangeiro.

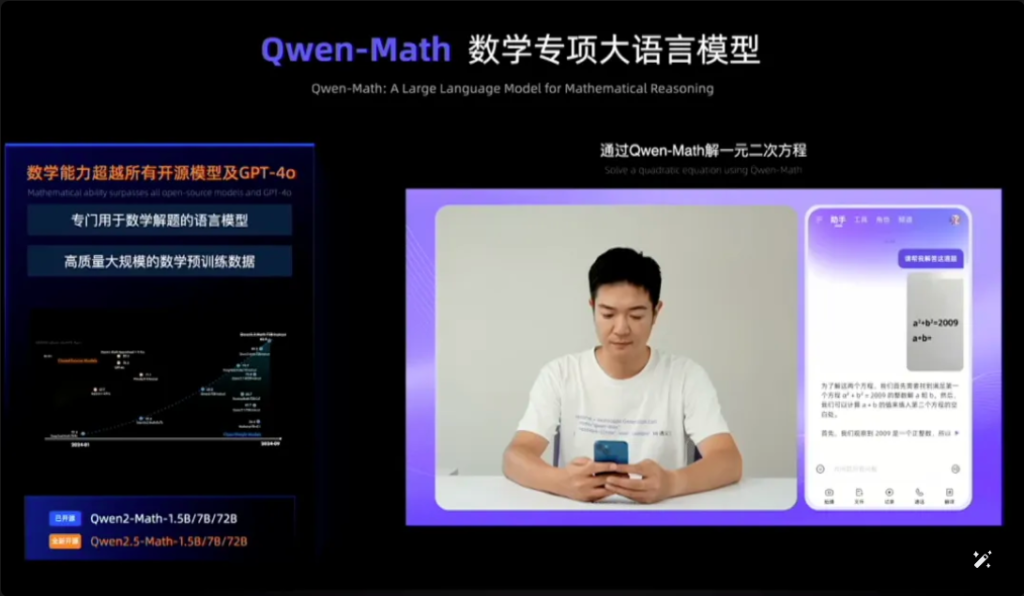

O Qwen2.5-Math, por exemplo, combina o reconhecimento visual com o Qwen2.5-Math. Ao introduzir uma imagem de ecrã de uma pergunta de escolha múltipla geometricamente semelhante, o Qwen2.5-Math reconhece rapidamente o significado da pergunta e dá a solução correta e a resposta "B", o que é preciso e rápido. A precisão e a velocidade são fantásticas.

Esta é a primeira vez que vejo o Qwen2.5-Math na Internet.

Prova de matemática Qwen2.5

Em apenas um ano e meio, desde abril de 2023, a Qwen cresceu e tornou-se um grupo de modelos de classe mundial, atrás apenas da Llama.

De acordo com os dados mais recentes divulgados por Zhou Jingren, CTO da AliCloud, em meados de setembro de 2024, o número acumulado de descarregamentos de modelos de fonte aberta da Tongyi Qwen ultrapassou os 40 milhões e foram obtidos mais de 50 000 modelos de grandes dimensões.

Série Qwen derivada de grandes modelos com mais de 50.000

Quais são as melhorias específicas de desempenho do Qwen 2.5? Quais são os destaques dos 100 novos modelos de código aberto? O Qwen2.5 é o primeiro do seu género no mundo e o primeiro do seu género na China.

Endereço do blogue: https://qwenlm.github.io/blog/qwen2.5/

Endereço do projeto: https://huggingface.co/spaces/Qwen/Qwen2.5

▲Blog oficial lança clusters do modelo Aliyun Qwen 2.5

01.No topo da lista global de novo, Qwen2.5 volume cruzado Catching up with Llama3.1-405B

Vejamos especificamente o desempenho do Qwen2.5.

O modelo Qwen2.5 suporta até 128K de comprimento de contexto, pode gerar até 8K de conteúdo e suporta mais de 29 idiomas, o que significa que pode ajudar os utilizadores a escrever artigos de 10.000 palavras.

Além disso, com base na pré-treinamento de dados de token 18T, o Qwen2.5 tem mais de 18% de melhoria de desempenho geral em comparação com o Qwen2, com mais conhecimento e habilidades de programação e matemática mais fortes.

Zhou Jingren, diretor técnico da AliCloud, explica a Qwen2.5

O modelo emblemático, o modelo Qwen2.5-72B, obteve uma pontuação de 86,8, 88,2 e 83,1 no teste de referência MMLU-rudex (que examina os conhecimentos gerais), no teste de referência MBPP (que examina a capacidade de codificação) e no teste de referência MATH (que examina a capacidade matemática).

O Qwen2.5, com os seus 72 mil milhões de parâmetros, supera mesmo o Llama3.1-405B, com os seus 405 mil milhões de parâmetros, "por ordens de grandeza".

O Llama3.1-405B foi lançado pela Meta em julho de 2024 e, em mais de 150 conjuntos de testes de referência, igualou ou mesmo ultrapassou o modelo GPT-4o, então SOTA (o melhor da indústria), o que desencadeou a afirmação de que "o modelo de código aberto mais forte é o modelo mais forte".

O Qwen2.5-72B-Instruct, a versão subsequente do Qwen2.5, superou o Llama3.1-405B no MMLU-redux, MATH, MBPP, LiveCodeBench, Arena-Hard, AlignBench, MT-Bench, MultiPL-E e outras avaliações oficiais. 405B.

Imagens

Situação de avaliação do modelo Qwen2.5-72B

O Qwen2.5 é mais uma vez o modelo de fonte aberta mais forte do mundo, contribuindo para a tendência da indústria de "fonte aberta sobre fonte fechada".

O AliCloud seguiu a série de código aberto Tongyi Qianqian Qwen2 em junho deste ano, alcançando o então mais forte modelo de código aberto Llama3-70B e lançando depois uma série de versões de código aberto.

Tornou-se um ritmo familiar na comunidade de criadores de IA o facto de cada novo rei que aparece ser rapidamente ultrapassado por uma nova versão do Tongyi.

Após a abertura do Qwen2.5 na noite de 18 de setembro, muitos programadores ficaram tão entusiasmados que não dormiram e experimentaram-no primeiro.

Não tenho a certeza se vou ser capaz de o fazer.

Desenvolvedores no país e no exterior discutem calorosamente o Qwen2.5

02. a maior comunidade de modelos da história do mundo

O mais importante é ter uma boa compreensão do que está a acontecer no mundo e de como ele funciona.

A comunidade de modelagem de código aberto Qwen2.5 é a maior que já existiu.

Zhou Jingren, CTO da AliCloud, anunciou na conferência Yunqi que a série Qwen2.5 totalizava mais de 100 modelos de código aberto nas prateleiras, adaptando-se totalmente às necessidades dos programadores e das PME em vários cenários.

Esta medida responde aos apelos de muitos programadores, que há muito tempo têm vindo a "insistir" nas principais redes sociais.

Desenvolvedores nacionais e estrangeiros pedem mais Qwen2.5

1, modelo linguístico: de 0,5B a 72B, sete tamanhos, de cenários de nível final a cenários de nível industrial cobertura total

O Qwen2.5 tem sete modelos de linguagem de tamanho aberto, incluindo 0,5B, 1,5B, 3B, 7B, 14B, 32B e 72B, tendo todos eles obtido resultados SOTA nas faixas correspondentes.

Imagens

O Qwen2.5 de várias dimensões satisfaz as necessidades de diversos cenários

Dadas as suas capacidades avançadas em Processamento de Linguagem Natural (NLP) e compreensão de codificação, o Qwen2.5 da Alibaba Cloud foi concebido para lidar com uma vasta gama de aplicações. Aqui estão alguns cenários específicos onde o Qwen2.5 pode ser utilizado:

- Serviço ao cliente melhorado: O Qwen2.5 pode ser utilizado em chatbots para interações mais semelhantes às humanas, respondendo eficazmente às perguntas dos clientes e fornecendo soluções.

- Criação de conteúdos: O modelo pode ajudar a gerar artigos, publicações nas redes sociais e outros conteúdos escritos, poupando tempo aos criadores de conteúdos.

- Assistência à programação: Com a sua série especializada Qwen2.5-Coder, pode ajudar os programadores sugerindo trechos de código, ajuda na depuração e automatizando determinadas tarefas de codificação.

- Educação e aprendizagem: O Qwen2.5 pode ser utilizado para desenvolver ferramentas educativas, tais como plataformas de aprendizagem interactivas que fornecem explicações, respondem a perguntas dos alunos e até classificam trabalhos.

- Serviços de tradução: Dada a sua proficiência em várias línguas, pode fornecer serviços de tradução em tempo real para colmatar as lacunas linguísticas na comunicação internacional.

- Investigação e desenvolvimento: Na investigação, o Qwen2.5 pode processar grandes quantidades de dados de texto para ajudar a descobrir padrões, resumir resultados e gerar relatórios.

- Assistência jurídica: O modelo pode ler documentos jurídicos, extrair informações relevantes e até redigir documentos jurídicos básicos, poupando tempo aos profissionais da área jurídica.

- Apoio aos cuidados de saúde: O Qwen2.5 pode ser utilizado para responder a perguntas de saúde comuns, fornecer informações médicas e ajudar a gerir os dados dos pacientes.

- Marketing e publicidade: Pode ajudar a criar conteúdos de marketing personalizados, textos publicitários e campanhas nas redes sociais dirigidas a públicos específicos.

- Análise de dados: O Qwen2.5 pode processar e analisar grandes conjuntos de dados para fornecer informações e ajudar a tomar decisões baseadas em dados.

- Relatórios automatizados: O modelo pode gerar relatórios através do processamento de dados e informações numa variedade de áreas, o que é particularmente útil na análise financeira e empresarial.

- Desenvolvimento de jogos: O Qwen2.5 pode ajudar a criar diálogos e narrativas interactivas para personagens de jogos de vídeo para aumentar a participação dos jogadores.

- Assistente virtual: Conduz assistentes virtuais que podem gerir horários, definir lembretes e fornecer conselhos personalizados.

- Comércio eletrónico: O Qwen2.5 pode ajudar a gerar descrições de produtos, lidar com consultas de clientes e criar experiências de compras personalizadas.

- Suporte multilingue: Pode ser utilizado em aplicações globais que requerem uma interação multilingue, como o serviço de apoio ao cliente internacional ou a localização de conteúdos.

Estas versões ajudam os programadores a equilibrar a capacidade e o custo do modelo e a adaptar-se a uma variedade de cenários. Por exemplo, 3B é o tamanho de ouro para se adaptar a telemóveis e outros dispositivos terminais, 32B é o mais esperado pelos programadores para ser o "rei da rentabilidade" e 72B é o rei do desempenho dos cenários de nível industrial e de investigação científica.

Endereço do blogue: https://qwenlm.github.io/zh/blog/qwen2.5-llm/

2、Modelo multimodal: o modelo visual compreende 20 minutos de vídeo, o modelo áudio-lingual suporta 8 idiomas

O Qwen2-VL-72B, o modelo de linguagem visual de grande escala altamente antecipado, é hoje oficialmente de fonte aberta.

O Qwen2-VL pode reconhecer imagens com diferentes resoluções e proporções, compreender vídeos longos de mais de 20 minutos, ter a capacidade de regular as inteligências visuais de telemóveis e dispositivos e ultrapassar o nível GPT-4o de compreensão visual.

Modelo de linguagem visual em grande escala Qwen2-VL-72B de código aberto

O Qwen2-VL-72B tornou-se o modelo de compreensão visual de fonte aberta com a pontuação mais elevada na avaliação global autorizada LMSYS Chatbot Arena Leaderboard.

O Qwen2-VL-72B é o modelo de compreensão visual de fonte aberta com a pontuação mais elevada.

O modelo de linguagem áudio de grande escala Qwen2-Audio é um modelo de fonte aberta que pode compreender a voz humana, a música e o som natural, suportar conversação por voz, análise de mensagens áudio e suportar mais de 8 línguas e dialectos, sendo um líder mundial no índice de avaliação convencional.

Endereço do blogue: http://qwenlm.github.io/blog/qwen2-vl/

3, modelo especial: o modelo matemático de código aberto mais avançado estreado, alcançando o GPT-4o

O Qwen2.5-Coder, para programação, e o Qwen2.5-Math, para matemática, também foram anunciados como código aberto nesta Conferência Cloud Habitat.

Entre eles, o Qwen2.5-Math é a série de modelos matemáticos de código aberto mais avançada até à data, desta vez de código aberto 1.5B, 7B, 72B de três tamanhos e modelo de recompensa matemática Qwen2.5-Math-RM.

Qwen2.5-Math código aberto

O modelo principal Qwen2-Math-72B-Instruct supera os modelos proprietários como o GPT-4o e o Claude 3.5 em tarefas a jusante relacionadas com a matemática.

O Qwen2.5-Coder, que foi treinado em até 5,5T tokens de dados relacionados com a programação, foi aberto no mesmo dia nas versões 1.5B e 7B, e será aberto no futuro na versão 32B.

Qwen2.5-Coder de código aberto

Endereço do blogue:

https://qwenlm.github.io/zh/blog/qwen2.5-math/

https://qwenlm.github.io/zh/blog/qwen2.5-coder/

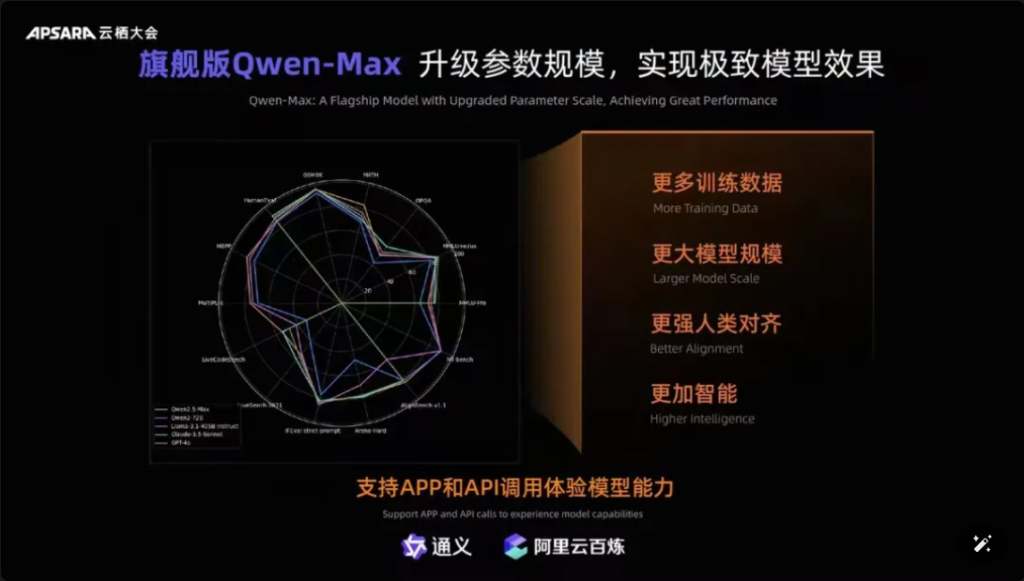

Além disso, vale a pena mencionar que o Qwen-Max, o modelo emblemático da Tongyiqianqian, foi totalmente atualizado, aproximando-se ou mesmo ultrapassando o GPT-4o em mais de dez referências de autoridade, tais como MMLU-Pro, MATH, etc., e está online no sítio Web oficial da Tongyiqianqian e da Tongyi APP. Os utilizadores também podem chamar as APIs do Qwen-Max através da plataforma AliCloud Hundred Refinement.

Imagens

▲Qwen-Max realiza uma atualização abrangente

Desde o lançamento da primeira geração do modelo de grandes dimensões Tongyi Qianqian em abril de 2023, a AliCloud permitiu que as empresas chinesas utilizassem o modelo de grandes dimensões a baixo custo, o que, por sua vez, levou a que a atual série Qwen2.5 fosse "cada vez mais útil".

Os modelos da série Qwen2.5 abrangem a versão básica, a versão de seguimento de comandos e a versão quantitativa, que é iterada em cenários do mundo real.

03.Qwen ultrapassou os 40 milhões de downloads! Nasceram mais de 50.000 "bebés".

Após um ano e meio de rápido desenvolvimento, a Tongyi Qwen tornou-se um grupo modelo de classe mundial, atrás apenas da Llama.

Zhou Jingren anunciou dois conjuntos de dados mais recentes que confirmam este facto:

Em primeiro lugar, o número de descargas de modelos: no início de setembro de 2024, as descargas cumulativas dos modelos de fonte aberta da Tongyi Qianwen ultrapassaram os 40 milhões, o que é o resultado de os programadores e as PME votarem com os pés;

O segundo é o número de modelos derivados: no início de setembro, o número total de modelos nativos e derivados do Tongyi ultrapassava os 50 000, ficando apenas atrás do Llama.

Os downloads cumulativos do modelo de código aberto Mil Perguntas de Tongyi ultrapassaram os 40 milhões

Até à data, os "10 000 modelos com a mesma origem" tornaram-se uma tendência significativa no desenvolvimento da indústria de modelos de grandes dimensões da China.

Qual é o conceito? A fonte aberta chinesa não só ocupa o primeiro lugar no mundo em termos de desempenho, mas também em termos de expansão ecológica. As comunidades de fonte aberta, os parceiros ecológicos e os programadores nacionais e estrangeiros tornaram-se a "água da torneira" da Tongyi Chienqin, que se tornou o primeiro grande modelo adotado por muitas empresas e também o grande modelo mais utilizado há mais tempo.

Já em agosto de 2023, Aliyun abriu o modelo de 7 mil milhões de parâmetros do Tongyi Qwen para comercialização gratuita e, em seguida, o Qwen1.5, Qwen2 e Qwen2.5 deste ano foram lançados um após o outro, para que os programadores possam utilizar rapidamente o modelo mais avançado ao mesmo tempo, para obter um maior controlo e espaço de afinação, tornando-se assim a escolha preferida de mais empresas.

No início de julho, os engenheiros da Hugging Face, a maior comunidade de código aberto do mundo, escreveram um tweet a certificar que a Tongyi é o grande modelo mais desenvolvido na China. E através da AliCloud, a Tongyi Big Model serviu mais de 300 000 clientes em vários sectores. No segundo trimestre de 2024 (correspondente ao primeiro trimestre do ano fiscal de 2025 da Alibaba), as receitas dos produtos relacionados com a IA da Aliyun registaram um crescimento de três dígitos.

O Grande Modelo de Tongyi serve mais de 300 000 clientes

O que é que Aliyun fez bem?

Na minha opinião, ao contrário dos grandes fabricantes estrangeiros Microsoft e ChatGPT forte ligação, Amazon AWS convergência de modelo de três partes para fazer a infraestrutura subjacente, Aliyun integrou as vantagens dos dois, no início, optou por serviços de infraestrutura de IA e auto-investigação grande modelo de duas mãos.

Centrando-se em modelos de auto-investigação, a Ali Cloud é o único gigante da nuvem na China que é firmemente claro sobre o modelo de fonte aberta e abertura, e não poupou esforços para fazer um enorme investimento em descobertas de modelos, compatibilidade ecológica, serviços de desenvolvimento, etc., de modo a tornar os grandes modelos de Tongyi, passo a passo, no círculo central da competição mundial de IA.

04.Conclusão: Todos os modelos têm a mesma origem Momento da bacia hidrográfica da indústria

Os modelos de fonte aberta estão a aproximar-se dos modelos de fonte fechada, ou mesmo a alcançá-los. Desde o Llama-405B da Meta em julho até ao Qwen2.5-72B da AliCloud hoje, o cenário de "todos os modelos da mesma fonte" está a tomar forma. O aumento de um ano e meio do grande modelo Tongyi Qianqi permitiu que muitas indústrias e empresas realizassem um pouso em escala de IA de baixo custo, e a indústria está entrando em um novo momento decisivo.

FAQS

- Q: Quais são os diferentes tamanhos de modelos disponíveis para o Qwen2.5? R: O Qwen2.5 oferece uma gama de modelos de parâmetros de 0,5B a 72B, fornecendo opções para várias aplicações e requisitos.

- Q: Como é que o Qwen2.5 suporta tarefas de programação? R: O Qwen2.5 inclui uma série especializada chamada Qwen2.5-Coder, projetada para melhorar a geração de código, inferência e depuração, com suporte para até 128K tokens.

- Q: Como são os dados de treino para o Qwen2.5? R: O Qwen2.5 é pré-treinado num vasto conjunto de dados que abrange até 18 triliões de tokens, assegurando uma ampla compreensão da linguagem.

- Q: O Qwen2.5 é adequado para utilização no ensino? R: Sim, as capacidades do Qwen2.5 no processamento de linguagem natural tornam-no adequado para ferramentas educativas, incluindo plataformas de aprendizagem interactivas.

- Q: Qual é o desempenho do Qwen2.5 nos testes de referência em comparação com outros modelos? R: Atualmente, o Qwen2.5 ocupa o terceiro lugar em benchmarks multimodais, superando modelos como o Llama3.1 em várias áreas.

- Q: Que idiomas são suportados pelo Qwen2.5? R: Qwen2.5 suporta múltiplas linguagens, incluindo mas não limitado a Python, Java e C++.

- Q: O Qwen2.5 pode gerar código em várias linguagens de programação? R: Sim, o Qwen2.5-Coder é capaz de gerar código em várias linguagens de programação, satisfazendo as necessidades de diferentes programadores.

- Q: Como é que o Qwen2.5 lida com contextos longos? R: O Qwen2.5 suporta comprimentos de contexto de até 32K, o que é benéfico para melhorar a precisão da conclusão e inferência de código.

- Q: O Qwen2.5 é de código aberto? R: Embora a versão de código aberto do Qwen2.5 ainda não tenha sido lançada, a documentação detalhada e os exemplos estão disponíveis em plataformas como o GitHub.

- Q: Quais são alguns cenários de aplicação do mundo real para o Qwen2.5? R: O Qwen2.5 pode ser utilizado em chatbots de serviço ao cliente, criação de conteúdos, assistência à programação, educação, serviços de tradução, assistência jurídica, apoio aos cuidados de saúde, marketing, análise de dados, relatórios automatizados, desenvolvimento de jogos, assistentes virtuais, comércio eletrónico e apoio multilingue em várias indústrias.