Edição de vídeo de retrato com a ajuda de

Prémios geradores multimodais

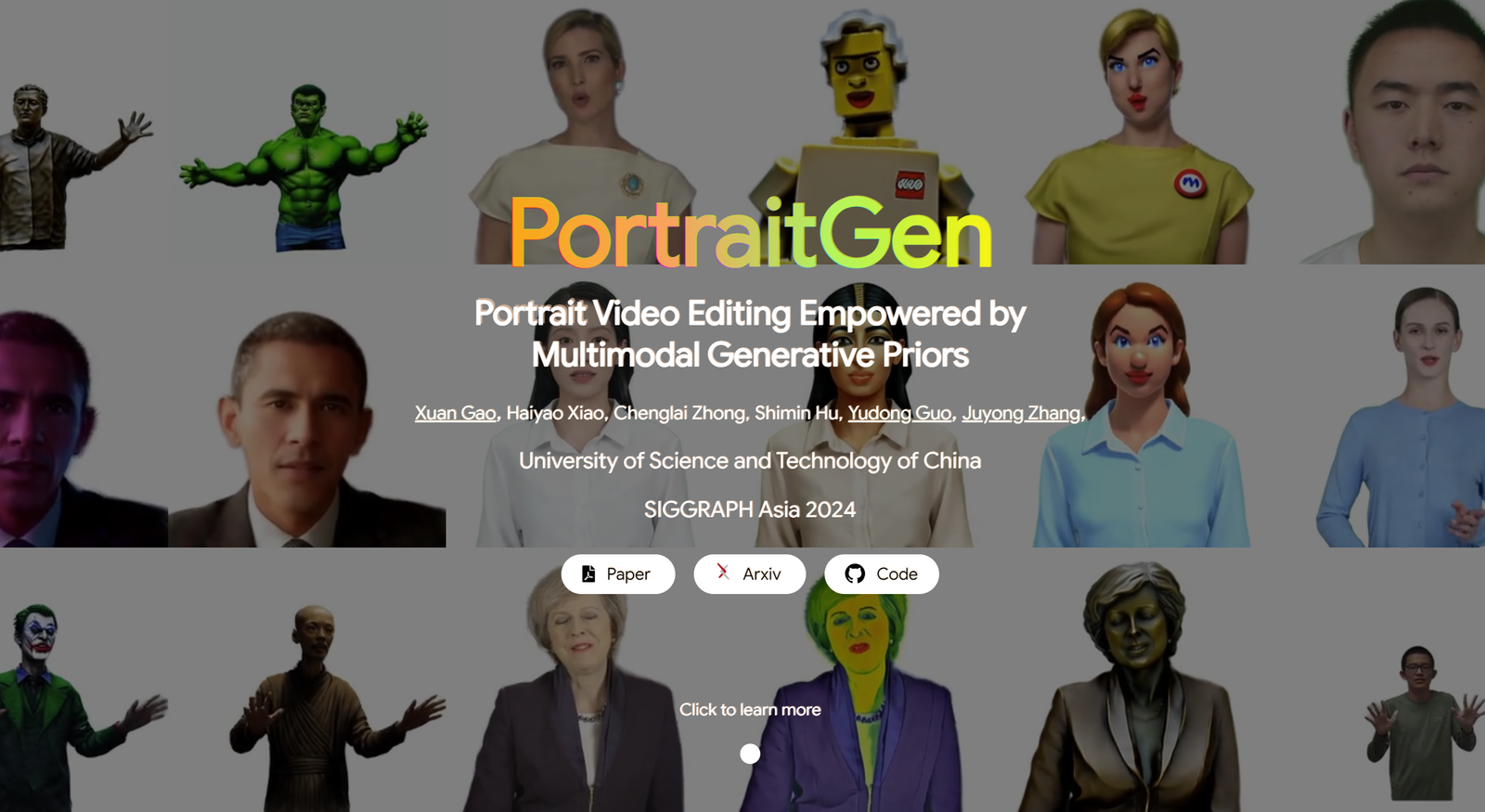

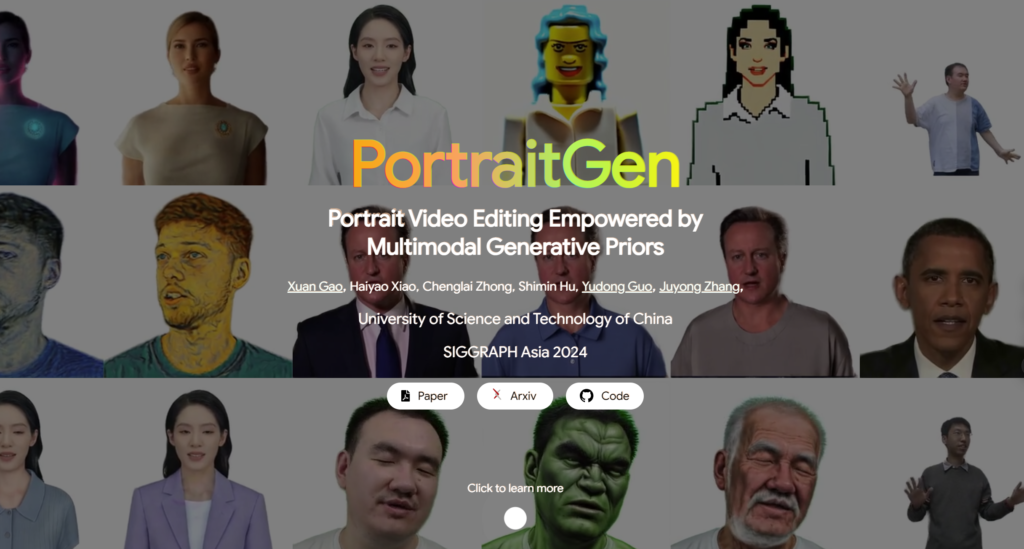

Os métodos tradicionais de edição de vídeo de retrato têm frequentemente problemas com efeitos 3D e consistência temporal, e também têm um desempenho fraco em termos de qualidade e eficiência de renderização. Para resolver estes problemas, PortraitGen eleva cada fotograma de um vídeo de retrato num campo Gaussiano 3D dinâmico unificado, que assegura a consistência estrutural e temporal de fotograma para fotograma. PortraitGen é um poderoso método de edição de vídeo de retrato que permite uma estilização consistente e expressiva com pistas multimodais.

Além disso, o PortraitGen concebeu um novo mecanismo de texturização neural Gaussiano que não só permite uma edição estilística complexa, como também permite velocidades de renderização superiores a 100 fotogramas por segundo. O PortraitGen combina uma vasta gama de entradas que são melhoradas pelo conhecimento destilado de modelos generativos 2D em grande escala. Também introduz orientação de semelhança de expressão e um módulo de edição de retrato de reconhecimento facial, reduzindo efetivamente os problemas que podem ocorrer quando se actualiza iterativamente um conjunto de dados. (Ligação no final do artigo)

01 Conteúdo da legenda

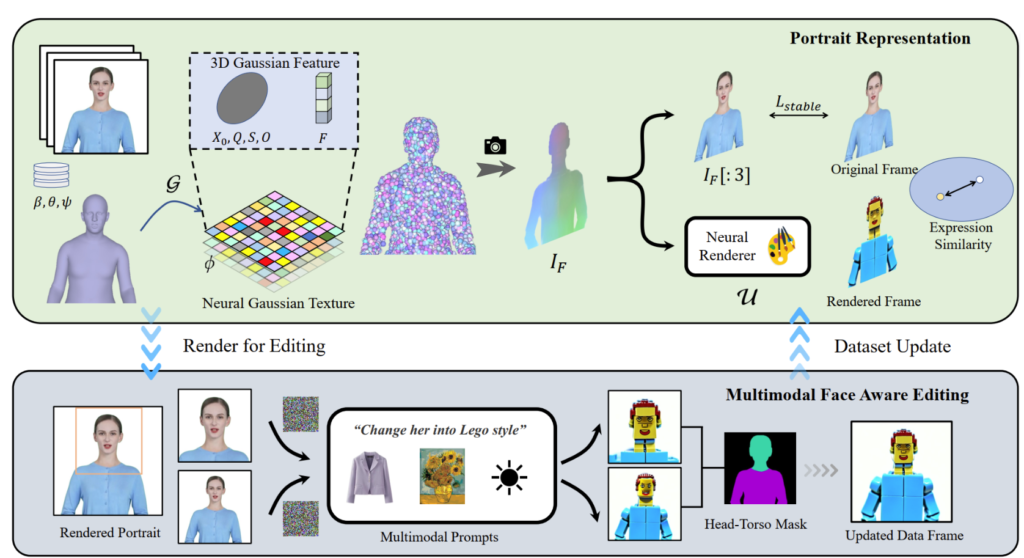

O PortraitGen transforma vídeos de retratos 2D num campo Gaussiano 4D para edição de retratos multimodais em apenas 30 minutos. O retrato 3D editado pode ser renderizado a 100 quadros por segundo. Os coeficientes SMPL-X no vídeo monocular são primeiro monitorizados e, em seguida, é gerado um campo de caraterísticas Gaussianas 3D utilizando um mecanismo de textura Neuro-Gaussiana.

O PortraitGen também utiliza uma estratégia de atualização iterativa do conjunto de dados para a edição de retratos e propõe um módulo de edição de reconhecimento facial para melhorar a qualidade das expressões e preservar a estrutura facial personalizada.

02 Utilizações práticas

A solução PortraitGen é uma estrutura unificada para a edição de vídeos de retratos. Qualquer modelo de edição de imagem que preserve a estrutura pode ser utilizado para compor vídeos de retratos consistentes em 3D e coerentes em termos temporais.

Edição orientada para o texto: O InstructPix2Pix é utilizado como modelo de edição 2D. A sua UNet requer três entradas: uma imagem RGB de entrada, um comando de texto e um ruído latente. Adiciona algum ruído à imagem renderizada e edita-a com base na imagem de origem de entrada e nas instruções.

Edição orientada para a imagem: centra-se em dois tipos de edição baseados em pistas de imagem. Um consiste em extrair o estilo global de uma imagem de referência e o outro em personalizar a imagem colocando objectos em locais específicos. Estes métodos são utilizados experimentalmente para a migração de estilos e a adaptação virtual. O estilo da imagem de referência foi migrado para as molduras do conjunto de dados utilizando o algoritmo Neural Style Migration e as roupas do sujeito foram alteradas utilizando o AnyDoor.

Relighting: utilização do IC-Light para manipular a iluminação dos quadros de vídeo. Dada uma descrição de texto como condição de iluminação, o método PortraitGen ajusta harmoniosamente a iluminação do vídeo de retrato

03 Experiências de contraste e de ablação

O método PortraitGen é comparado com os métodos de edição de vídeo mais avançados, incluindo TokenFlow, Rerender A Video, CoDeF e AnyV2V. O método PortraitGen supera significativamente os outros métodos em termos de preservação just-in-time, preservação de identidade e consistência temporal.

Duração do tempo 00:47

Inspirado na textura neural proposta em "Delayed Neural Rendering", o PortraitGen propõe uma textura neural gaussiana. Esta abordagem armazena caraterísticas aprendidas para cada Gaussiana em vez de armazenar coeficientes harmónicos esféricos. De seguida, é utilizado um renderizador neural 2D para converter os mapas de caraterísticas processados em sinais RGB. Este método fornece informações mais ricas do que os coeficientes harmónicos esféricos e permite uma melhor fusão das caraterísticas processadas, facilitando a edição de estilos complexos, como Lego e pixel art.

Ao editar uma imagem da parte superior do corpo, se o rosto ocupar uma área pequena, a edição do modelo pode não estar bem adaptada à pose da cabeça e à estrutura facial. A edição de retratos com reconhecimento facial (FA) pode melhorar os resultados efectuando duas edições para aumentar o foco na estrutura facial.

Ao mapear a imagem renderizada e a imagem de origem de entrada no espaço de expressão latente do EMOCA e otimizar a semelhança das expressões, podemos garantir que as expressões permanecem naturais e consistentes com os fotogramas de vídeo originais.

Tecnologia por detrás do PortraitGen

Referência

Pode encontrar mais informações sobre a PotraitGen aqui :https://ustc3dv.github.io/PortraitGen/