Editing video di ritratti con il supporto di

Priori generativi multimodali

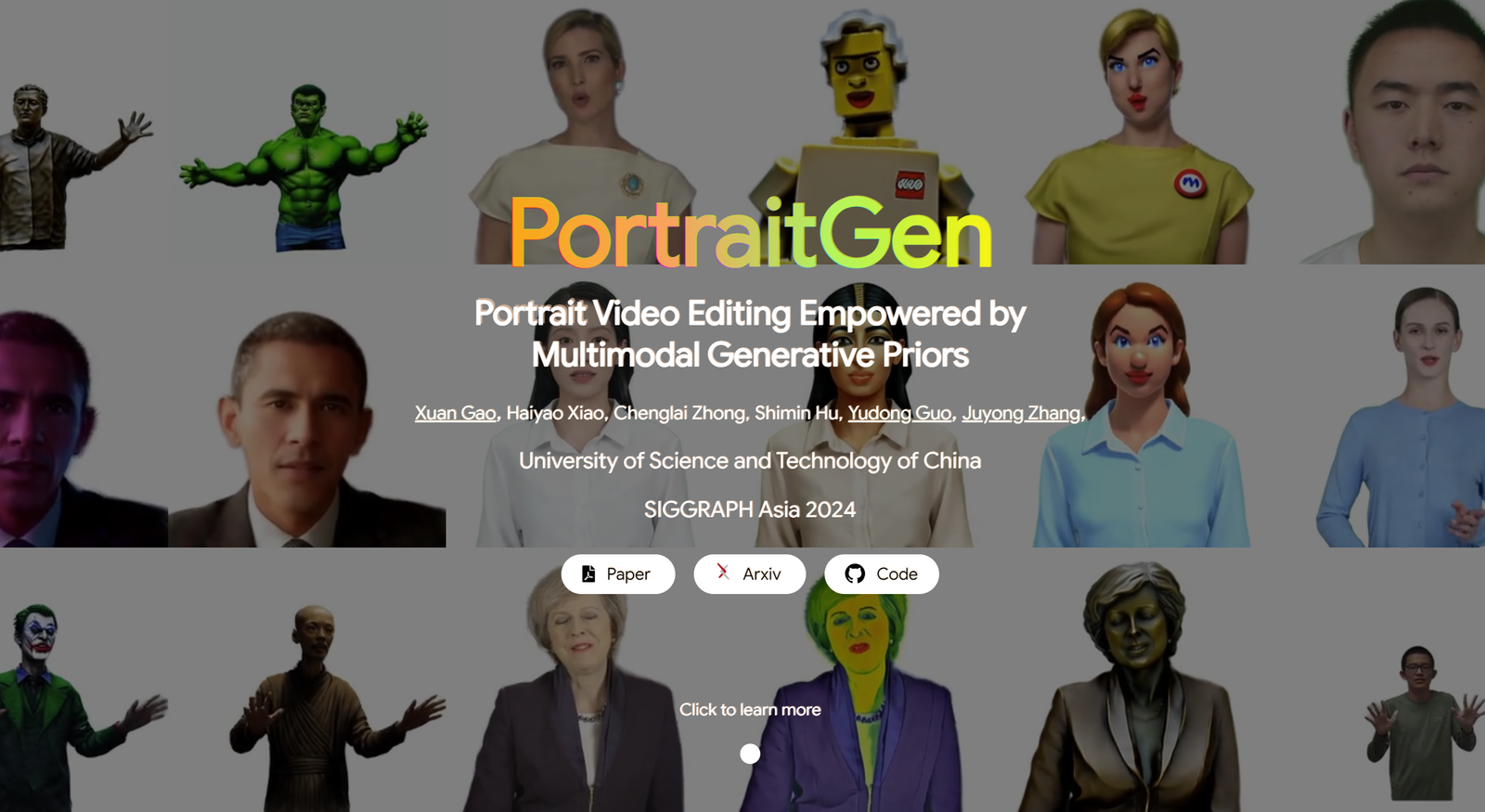

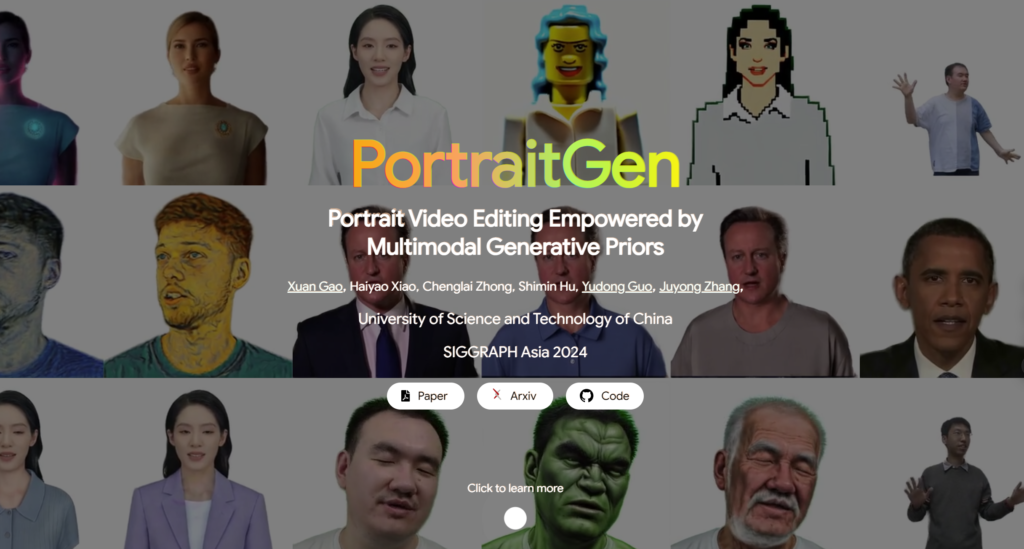

I metodi tradizionali di editing di video di ritratti hanno spesso problemi con gli effetti 3D e la coerenza temporale, oltre ad avere scarse prestazioni in termini di qualità ed efficienza del rendering. Per risolvere questi problemi, PortraitGen eleva ogni fotogramma di un video di ritratto in un campo gaussiano 3D dinamico unificato, che garantisce la coerenza strutturale e temporale da un fotogramma all'altro.PortraitGen è un potente metodo di editing di video di ritratto che consente una stilizzazione coerente ed espressiva con spunti multimodali.

Inoltre, PortraitGen ha ideato un nuovo meccanismo di texturing neurale gaussiano che non solo consente di eseguire complesse modifiche stilistiche, ma permette anche di raggiungere velocità di rendering superiori a 100 fotogrammi al secondo. PortraitGen combina un'ampia gamma di input arricchiti dalla conoscenza distillata da modelli generativi 2D su larga scala. Inoltre, introduce una guida alla somiglianza delle espressioni e un modulo di editing dei ritratti con riconoscimento facciale, riducendo efficacemente i problemi che possono verificarsi quando si aggiorna iterativamente un set di dati. (Link in fondo all'articolo)

01 Contenuto della didascalia

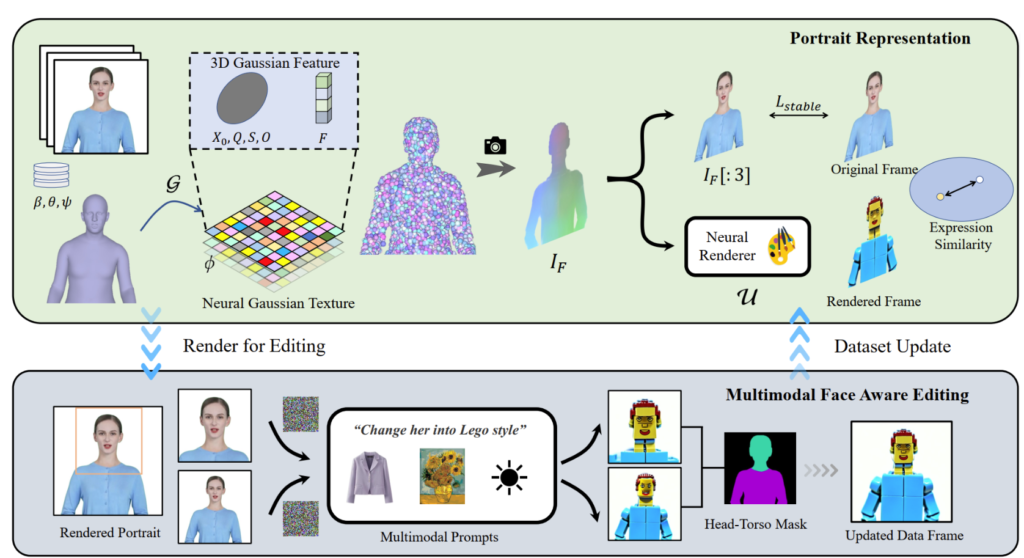

PortraitGen trasforma i video di ritratti 2D in un campo gaussiano 4D per l'editing di ritratti multimodali in soli 30 minuti. Il ritratto 3D modificato può essere renderizzato a 100 fotogrammi al secondo. I coefficienti SMPL-X del video monoculare vengono prima tracciati e poi viene generato un campo di caratteristiche gaussiane 3D utilizzando un meccanismo di texture neuro-gaussiana.

PortraitGen impiega anche una strategia di aggiornamento iterativo del set di dati per la modifica del ritratto e propone un modulo di modifica del riconoscimento facciale per migliorare la qualità delle espressioni e preservare la struttura facciale personalizzata.

02 Usi pratici

La soluzione PortraitGen è una struttura unificata per l'editing di video di ritratti. Qualsiasi modello di editing delle immagini che preservi la struttura può essere utilizzato per comporre video di ritratti coerenti in 3D e nel tempo.

Editing guidato dal testo: InstructPix2Pix è utilizzato come modello di editing 2D. Il suo UNet richiede tre input: un'immagine RGB in ingresso, un comando di testo e un rumore latente. Aggiunge del rumore all'immagine renderizzata e la modifica in base all'immagine sorgente e alle istruzioni in ingresso.

Modifica guidata dall'immagine: si concentra su due tipi di modifica basati su spunti di immagine. Uno consiste nell'estrarre lo stile globale di un'immagine di riferimento, mentre l'altro consiste nel personalizzare l'immagine collocando gli oggetti in posizioni specifiche. Questi metodi sono stati utilizzati sperimentalmente per la migrazione dello stile e l'adattamento virtuale. Lo stile dell'immagine di riferimento è stato migrato ai fotogrammi del set di dati utilizzando l'algoritmo Neural Style Migration e i vestiti del soggetto sono stati cambiati utilizzando AnyDoor.

Relighting: utilizzo di IC-Light per manipolare l'illuminazione dei fotogrammi video. Data una descrizione testuale come condizione di illuminazione, il metodo PortraitGen regola armoniosamente l'illuminazione del video del ritratto.

03 Esperimenti di contrasto e ablazione

Il metodo PortraitGen viene confrontato con i metodi di editing video più avanzati, tra cui TokenFlow, Rerender A Video, CoDeF e AnyV2V. Il metodo PortraitGen supera significativamente gli altri metodi in termini di conservazione just-in-time, conservazione dell'identità e coerenza temporale.

La durata del tempo 00:47

Ispirandosi alla texture neurale proposta in "Delayed Neural Rendering", PortraitGen propone una texture neurale gaussiana. Questo approccio memorizza caratteristiche apprendibili per ogni gaussiana, invece di memorizzare i coefficienti delle armoniche sferiche. Successivamente, viene utilizzato un rendering neurale 2D per convertire le mappe di caratteristiche elaborate in segnali RGB. Questo metodo fornisce informazioni più ricche rispetto ai coefficienti armonici sferici e consente una migliore fusione delle caratteristiche elaborate, facilitando l'editing di stili complessi come Lego e pixel art.

Quando si modifica un'immagine della parte superiore del corpo, se il viso occupa un'area ridotta, l'editing del modello potrebbe non essere ben adattato alla posa della testa e alla struttura del viso. Il Facial Awareness Portrait Editing (FA) può migliorare i risultati eseguendo due modifiche per aumentare l'attenzione sulla struttura del viso.

Mappando l'immagine renderizzata e l'immagine sorgente in ingresso nello spazio delle espressioni latenti di EMOCA e ottimizzando la somiglianza delle espressioni, possiamo garantire che le espressioni rimangano naturali e coerenti con i fotogrammi video originali.

La tecnologia dietro PortraitGen

Riferimenti

Potete trovare maggiori informazioni su PotraitGen qui :https://ustc3dv.github.io/PortraitGen/