Édition vidéo de portraits avec l'aide de

Les amorces génératives multimodales

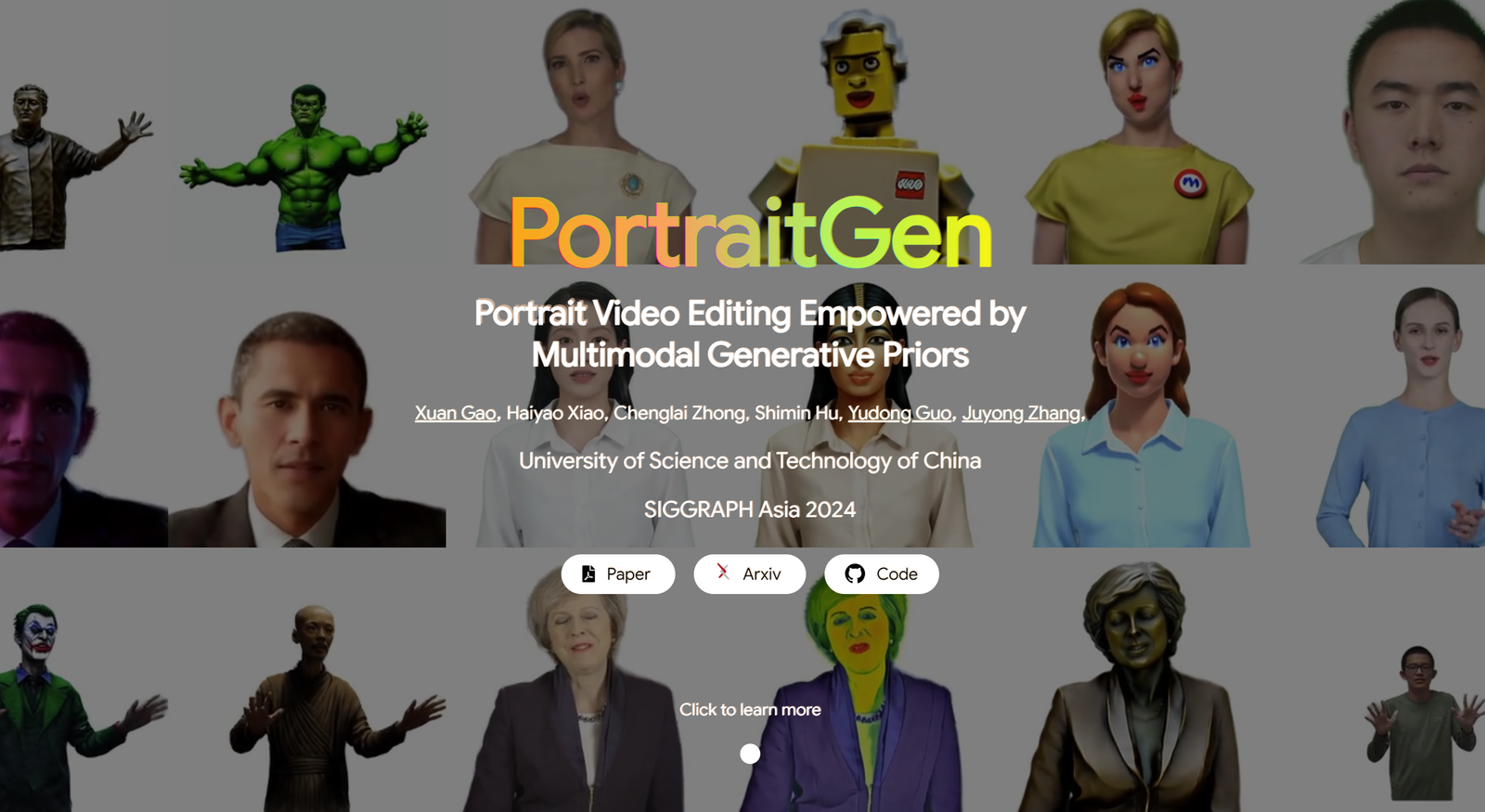

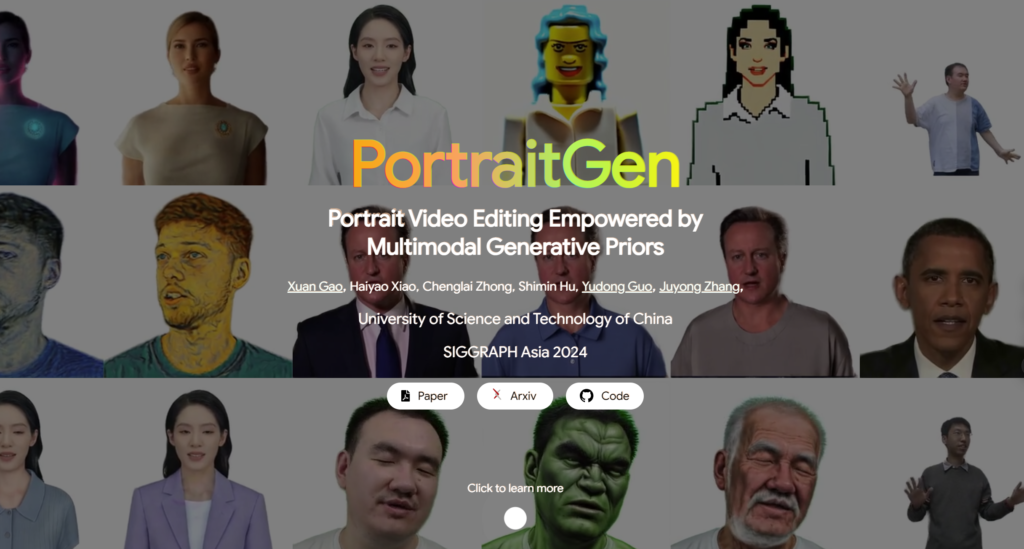

Les méthodes traditionnelles d'édition de vidéos de portraits présentent souvent des problèmes d'effets 3D et de cohérence temporelle, ainsi que des performances médiocres en termes de qualité de rendu et d'efficacité. Pour résoudre ces problèmes, PortraitGen élève chaque image d'une vidéo de portrait dans un champ gaussien dynamique 3D unifié, ce qui garantit la cohérence structurelle et temporelle d'une image à l'autre. PortraitGen est une puissante méthode d'édition de vidéo de portrait qui permet une stylisation cohérente et expressive avec des indices multimodaux.

En outre, PortraitGen a conçu un nouveau mécanisme neuronal de texturation gaussienne qui permet non seulement une édition stylistique complexe, mais aussi des vitesses de rendu supérieures à 100 images par seconde.PortraitGen combine un large éventail d'entrées qui sont améliorées par les connaissances distillées à partir de modèles génératifs 2D à grande échelle. PortraitGen combine un large éventail d'entrées enrichies par des connaissances distillées à partir de modèles génératifs 2D à grande échelle. Il introduit également des conseils de similarité d'expression et un module d'édition de portrait par reconnaissance faciale, réduisant ainsi efficacement les problèmes qui peuvent survenir lors de la mise à jour itérative d'un ensemble de données. (Lien au bas de l'article)

01 Contenu de la légende

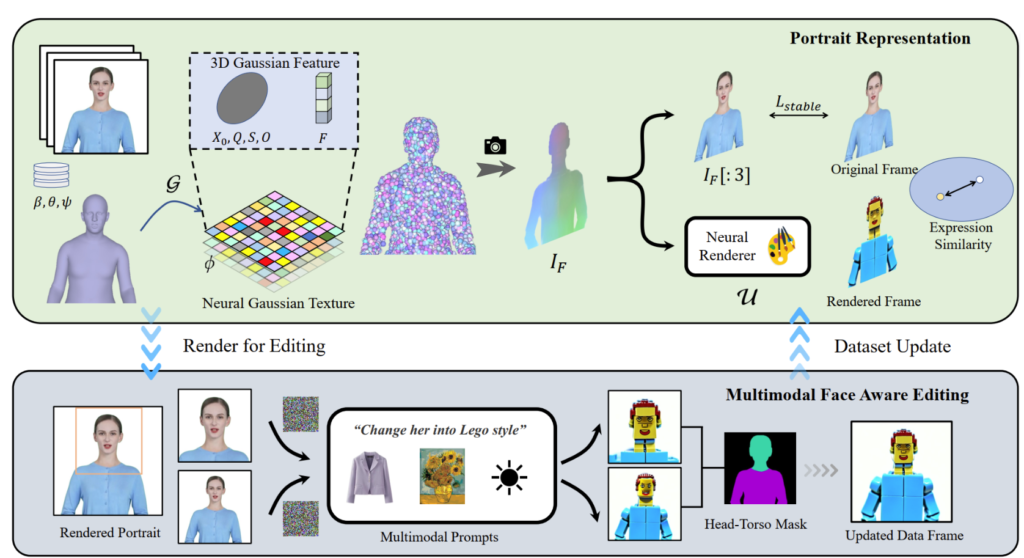

PortraitGen transforme les vidéos de portraits 2D en un champ gaussien 4D pour l'édition de portraits multimodaux en seulement 30 minutes. Le portrait 3D édité peut être rendu à 100 images par seconde. Les coefficients SMPL-X de la vidéo monoculaire sont d'abord suivis, puis un champ gaussien 3D est généré à l'aide d'un mécanisme de texture neuro-gaussien.

PortraitGen utilise également une stratégie itérative de mise à jour des données pour l'édition des portraits et propose un module d'édition de la reconnaissance faciale pour améliorer la qualité des expressions et préserver la structure faciale personnalisée.

02 Utilisations pratiques

La solution PortraitGen est un cadre unifié pour l'édition de vidéos de portraits. Tout modèle d'édition d'images qui préserve la structure peut être utilisé pour composer des portraits vidéo cohérents en 3D et dans le temps.

Edition pilotée par le texte : InstructPix2Pix est utilisé comme modèle d'édition 2D. Son UNet nécessite trois entrées : une image RVB d'entrée, une commande de texte et un bruit latent. Il ajoute du bruit à l'image rendue et la modifie en fonction de l'image source et des instructions.

Édition axée sur l'image : se concentre sur deux types d'édition basés sur des indices d'image. L'un consiste à extraire le style global d'une image de référence et l'autre à personnaliser l'image en plaçant des objets à des endroits spécifiques. Ces méthodes sont utilisées expérimentalement pour la migration de style et l'ajustement virtuel. Le style de l'image de référence a été transféré vers les images de l'ensemble de données à l'aide de l'algorithme Neural Style Migration et les vêtements du sujet ont été changés à l'aide de AnyDoor.

Relighting : utilisation de IC-Light pour manipuler l'éclairage des images vidéo. La méthode PortraitGen ajuste harmonieusement l'éclairage de la vidéo du portrait à partir d'une description textuelle.

03 Expériences de contraste et d'ablation

La méthode PortraitGen est comparée à des méthodes d'édition vidéo de pointe, notamment TokenFlow, Rerender A Video, CoDeF et AnyV2V. La méthode PortraitGen est nettement plus performante que les autres méthodes en termes de préservation juste à temps, de préservation de l'identité et de cohérence temporelle.

La durée 00:47

Inspiré par la texture neuronale proposée dans "Delayed Neural Rendering", PortraitGen propose une texture gaussienne neuronale. Cette approche stocke des caractéristiques pouvant être apprises pour chaque gaussienne au lieu de stocker des coefficients harmoniques sphériques. Ensuite, un moteur de rendu neuronal 2D est utilisé pour convertir les cartes de caractéristiques traitées en signaux RVB. Cette méthode fournit des informations plus riches que les coefficients harmoniques sphériques et permet une meilleure fusion des caractéristiques traitées, ce qui facilite l'édition de styles complexes tels que le Lego et le pixel art.

Lors de l'édition d'une image du haut du corps, si le visage occupe une petite surface, l'édition du modèle peut ne pas être bien adaptée à la pose de la tête et à la structure du visage. L'édition de portraits avec prise de conscience du visage (FA) peut améliorer les résultats en effectuant deux éditions afin de mettre davantage l'accent sur la structure du visage.

En mappant l'image rendue et l'image source d'entrée dans l'espace d'expression latente d'EMOCA et en optimisant la similarité des expressions, nous pouvons nous assurer que les expressions restent naturelles et cohérentes avec les images vidéo d'origine.

La technologie derrière PortraitGen

Référence

Pour en savoir plus sur PotraitGen, cliquez ici :https://ustc3dv.github.io/PortraitGen/