통이첸첸첸퀘인의 다운로드 수는 4000만 건을 돌파하여 5만 명 이상의 아동 모델을 '양성'했습니다.

BS가 없습니다. 먼저 Qwen을 테스트해 보세요.

클라우드 컴퓨팅 “춘절 갈라” 운치 대회 개최, 통이권 대형 모델이 다시 한번 전 현장을 폭발!

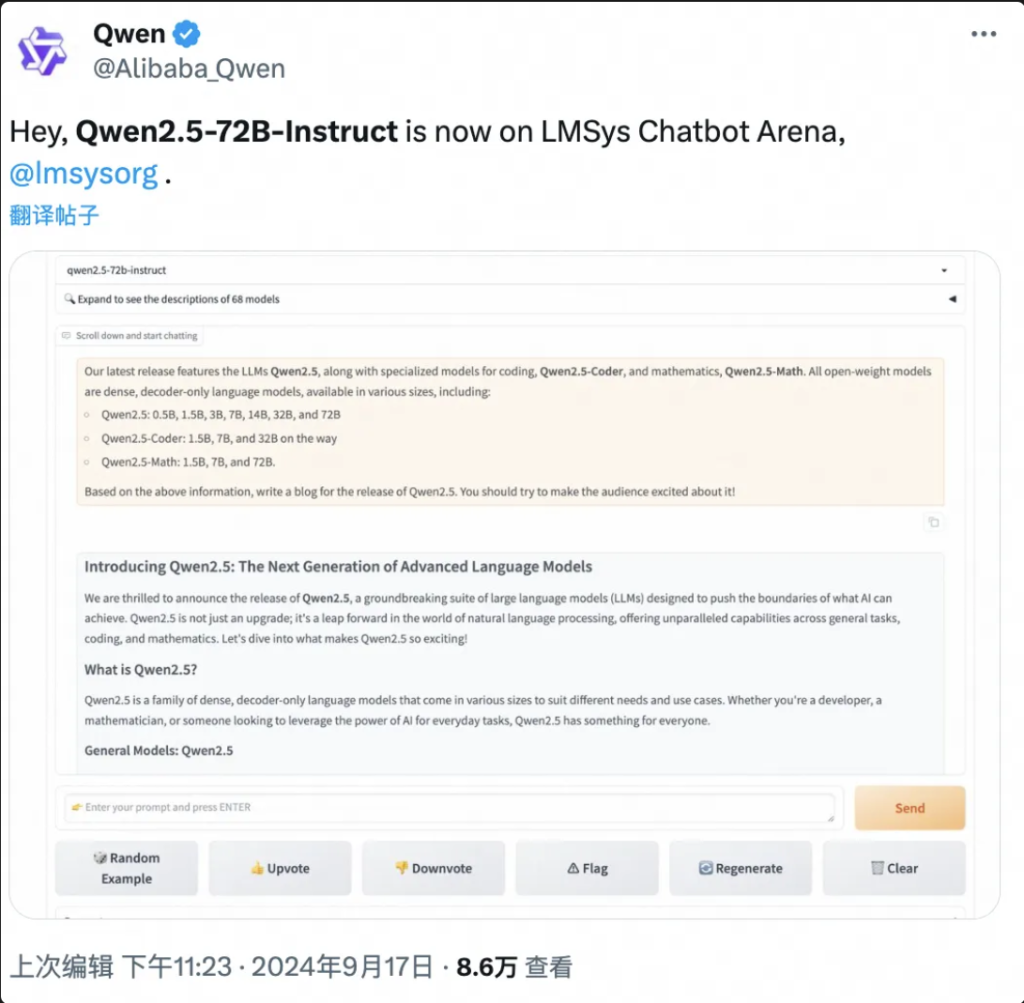

9월 19일 와이즈씽스(Wise Things)가 보도한 항저우(Hangzhou)에서 오늘 알리클라우드가 세계 최강의 오픈소스 대형 모델 Qwen2.5-72B를 출시해 성능이 '교차 측정'에서 Llama3.1-405B를 넘어 글로벌 오픈소스 대형 모델의 왕좌에 올랐습니다.

다음은 이 프로젝트의 작업 결과 요약입니다.

Qwen2.5-72B는 여러 권위 있는 테스트에서 Llama-405B보다 성능이 우수합니다.

동시에 언어 모델 Qwen2.5, 시각 언어 모델 Qwen2-VL-72B, 프로그래밍 모델 Qwen2.5-Coder, 수학 모델 Qwen2.5-Math 등 많은 Qwen2.5 모델이 오픈 소스로 공개되었으며, 누적 출시 모델이 100개가 넘고, 그 중 일부는 GPT-4o의 성능을 따라잡아 새로운 세계 기록을 세웠습니다.

"미친 목요일", '대박 상품' …… Qwen2.5는 출시 후 몇 시간 만에 국내외 소셜 미디어에서 열광적인 토론을 촉발했으며 전 세계 개발자가 시범 테스트 팀에 합류했습니다.

▲Qwen2.5는 국내외 소셜미디어에서 뜨거운 화제다.

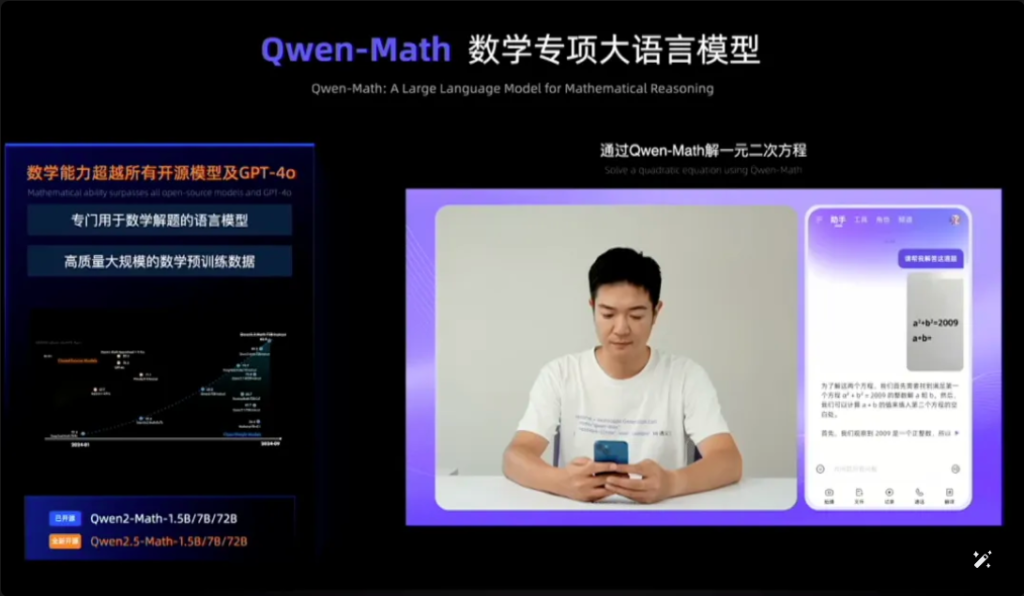

예를 들어 Qwen2.5-Math는 시각적 인식과 Qwen2.5-Math를 결합합니다. 기하학적으로 유사한 객관식 문제의 스크린샷을 입력하면 Qwen2.5-Math는 질문의 의미를 빠르게 인식하고 정답과 답 "B"를 제공하는데, 이는 정확하고 빠릅니다. 정확도와 속도가 놀랍습니다.

Qwen2.5-Math를 웹에서 본 건 이번이 처음이에요.

▲Qwen2.5-수학 시험

2023년 4월부터 불과 1년 반 만에 Qwen은 Llama에 이어 세계적인 모델 그룹으로 성장했습니다.

알리클라우드 최고기술책임자(CTO) 저우징런이 발표한 최신 데이터에 따르면, 2024년 9월 중순까지 통이큐웬의 오픈소스 모델 누적 다운로드 수는 4,000만건을 돌파했고, 5만여 개의 대형 모델이 도출됐다고 합니다.

▲큐웬 시리즈는 5만대 이상의 대형 모델을 파생시켰다

Qwen 2.5의 구체적인 성능 개선 사항은 무엇입니까? 100개의 새로운 오픈 소스 모델의 하이라이트는 무엇입니까? Qwen2.5는 세계 최초의 종류이며 중국에서도 최초의 종류입니다.

블로그 주소: https://qwenlm.github.io/blog/qwen2.5/

프로젝트 주소: https://huggingface.co/spaces/Qwen/Qwen2.5

▲공식 블로그, Aliyun Qwen 2.5 모델 클러스터 출시

01. 글로벌 차트 1위 재차 등극, Qwen2.5 크로스볼륨 Llama3.1-405B 따라잡기

Qwen2.5의 성능을 구체적으로 살펴보겠습니다.

Qwen2.5 모델은 최대 128K 컨텍스트 길이를 지원하고, 최대 8K 콘텐츠를 생성할 수 있으며, 29개 이상의 언어를 지원하므로 사용자가 10,000단어짜리 기사를 작성하는 데 도움이 될 수 있습니다.

뿐만 아니라, 18T 토큰 데이터 사전 학습을 기반으로 Qwen2.5는 Qwen2와 비교하여 전반적인 성능이 18% 이상 향상되었으며, 더 많은 지식과 더 강력한 프로그래밍 및 수학 기술을 갖추고 있습니다.

▲Qwen2.5를 설명하는 AliCloud CTO Zhou Jingren

주력 모델인 Qwen2.5-72B 모델은 MMLU-rudex 벤치마크(일반 지식 검사), MBPP 벤치마크(코딩 능력 검사), MATH 벤치마크(수학 능력 검사)에서 각각 최고 86.8, 88.2, 83.1점을 받은 것으로 알려졌습니다.

720억 개의 매개변수를 가진 Qwen2.5는 4,050억 개의 매개변수를 가진 Llama3.1-405B보다 "규모 면에서" 더 우수한 성능을 보입니다.

Llama3.1-405B는 Meta에서 2024년 7월에 출시했으며, 150개가 넘는 벤치마크 테스트 세트에서 당시 SOTA(업계 최고) 모델인 GPT-4o와 동등하거나 심지어 능가하여 "가장 강력한 오픈소스 모델이 가장 강력한 모델"이라는 주장을 촉발했습니다.

Qwen2.5의 후속 버전인 Qwen2.5-72B-Instruct는 MMLU-redux, MATH, MBPP, LiveCodeBench, Arena-Hard, AlignBench, MT-Bench, MultiPL-E 및 기타 권위 있는 평가에서 Llama3.1-405B를 능가했습니다. 405B.

영화

▲Qwen2.5-72B 모델 평가 상황

Qwen2.5는 다시 한번 세계에서 가장 강력한 오픈소스 모델이 되었으며, "클로즈드 소스보다 오픈소스"라는 산업 추세에 기여하고 있습니다.

이는 올해 6월에 오픈소스 Tongyi Qianqian Qwen2 시리즈를 출시한 데 이어, 당시 가장 강력했던 오픈소스 모델인 Llama3-70B를 따라잡고 일련의 오픈소스 버전을 출시한 AliCloud의 모습입니다.

AI 개발자 커뮤니티에서는 새로운 왕이 등장할 때마다 곧 새로운 버전의 통이에게 추월당하는 것이 익숙한 리듬이 되었습니다.

9월 18일 저녁 Qwen2.5가 출시되자마자 많은 개발자들이 너무 기뻐서 잠을 이루지 못하고 먼저 시도해보았습니다.

제가 그걸 할 수 있을지 잘 모르겠어요.

▲국내외 개발자들, Qwen2.5에 대한 뜨거운 토론

02. 세계 역사상 가장 큰 모델링 커뮤니티

가장 중요한 것은 세상에서 무슨 일이 일어나고 있는지, 그리고 그것이 어떻게 돌아가는지 잘 이해하는 것입니다.

Qwen2.5 오픈소스 모델링 커뮤니티는 그 어느 때보다 가장 큽니다.

AliCloud의 CTO인 저우징런은 Yunqi 컨퍼런스에서 Qwen2.5 시리즈가 100개가 넘는 오픈소스 모델을 출시하여 다양한 시나리오에서 개발자와 중소기업의 요구 사항을 충족한다고 발표했습니다.

이는 주요 소셜 미디어에서 오랫동안 "촉구"해 온 많은 개발자들의 요청에 따른 것입니다.

▲국내외 개발사들, Qwen2.5 더욱 촉구

1, 언어 모델: 0.5B에서 72B까지 7가지 크기, 엔드 사이드에서 산업용 시나리오까지 전체 범위

Qwen2.5는 0.5B, 1.5B, 3B, 7B, 14B, 32B, 72B를 포함한 7개의 크기 언어 모델을 오픈 소스로 공개했으며, 이는 모두 해당 트랙에서 SOTA 결과를 달성했습니다.

영화

▲다양한 시나리오의 요구에 부합하는 멀티 사이즈 Qwen2.5

자연어 처리(NLP) 및 코딩 이해에 대한 고급 기능을 감안할 때, Alibaba Cloud의 Qwen2.5는 광범위한 애플리케이션을 처리하도록 설계되었습니다. Qwen2.5를 활용할 수 있는 몇 가지 구체적인 시나리오는 다음과 같습니다.

- 향상된 고객 서비스: Qwen2.5는 더욱 인간적인 상호작용을 위해 챗봇에 적용되어 고객 문의에 효과적으로 답하고 해결책을 제공할 수 있습니다.

- 콘텐츠 생성: 이 모델은 기사, 소셜 미디어 게시물 및 기타 서면 콘텐츠를 생성하는 데 도움이 되어 콘텐츠 작성자의 시간을 절약할 수 있습니다.

- 프로그래밍 지원: Qwen2.5-Coder 시리즈의 전문적인 기능을 통해 코드 스니펫 제안, 디버깅 지원, 특정 코딩 작업 자동화 등을 통해 개발자를 지원할 수 있습니다.

- 교육 및 학습: Qwen2.5를 사용하면 설명을 제공하고, 학생의 질문에 답하고, 심지어 과제를 채점할 수 있는 대화형 학습 플랫폼과 같은 교육 도구를 개발할 수 있습니다.

- 번역 서비스: 여러 언어에 대한 능통함을 바탕으로 국제적인 의사소통에서 언어 격차를 메우는 실시간 번역 서비스를 제공할 수 있습니다.

- 연구 및 개발: 연구 분야에서 Qwen2.5는 대량의 텍스트 데이터를 처리하여 패턴 발견, 연구 결과 요약, 보고서 생성을 지원할 수 있습니다.

- 법률 지원: 이 모델은 법률 문서를 읽고, 관련 정보를 추출하고, 심지어 기본적인 법률 문서 초안을 작성할 수도 있어 법률 전문가의 시간을 절약할 수 있습니다.

- 의료 지원: Qwen2.5는 일반적인 건강 질문에 답하고, 의료 정보를 제공하며, 환자 데이터 관리를 지원하는 데 사용할 수 있습니다.

- 마케팅 및 광고: 특정 대상 고객을 타겟으로 하는 개인화된 마케팅 콘텐츠, 광고 카피, 소셜 미디어 캠페인을 만드는 데 도움이 될 수 있습니다.

- 데이터 분석: Qwen2.5는 방대한 데이터 세트를 처리하고 분석하여 통찰력을 제공하고 데이터 기반의 의사 결정을 내리는 데 도움을 줍니다.

- 자동 보고: 이 모델은 다양한 분야의 데이터와 정보를 처리하여 보고서를 생성할 수 있으며, 이는 특히 재무 및 비즈니스 분석에 유용합니다.

- 게임 개발: Qwen2.5는 비디오 게임 캐릭터의 대화형 대화와 내러티브를 만드는 데 도움을 주어 플레이어의 참여도를 높일 수 있습니다.

- 가상 비서: 일정을 관리하고, 알림을 설정하고, 개인화된 조언을 제공할 수 있는 가상 비서를 구동합니다.

- 전자상거래: Qwen2.5는 제품 설명 생성, 고객 문의 처리, 개인화된 쇼핑 경험 생성을 도울 수 있습니다.

- 다국어 지원: 국제 고객 서비스나 콘텐츠 현지화 등 다국어 상호 작용이 필요한 글로벌 애플리케이션에 사용할 수 있습니다.

이러한 버전은 개발자가 모델 성능과 비용의 균형을 맞추고 다양한 시나리오에 적응하는 데 도움이 됩니다. 예를 들어, 3B는 휴대전화 및 기타 엔드사이드 장치에 적응하는 데 가장 적합한 크기이고, 32B는 개발자가 "비용 효율성의 왕"이 될 것으로 가장 기대하는 크기이며, 72B는 산업 등급 및 과학 연구 등급 시나리오의 성능의 왕입니다.

블로그 주소: https://qwenlm.github.io/zh/blog/qwen2.5-llm/

2、멀티모달 모델: 시각 모델은 20분 분량의 영상을 이해하고, 청각-언어 모델은 8개 언어를 지원합니다.

많은 기대를 모았던 대규모 시각 언어 모델인 Qwen2-VL-72B가 오늘 공식적으로 오픈 소스로 공개되었습니다.

Qwen2-VL은 다양한 해상도와 종횡비의 사진을 인식하고, 20분 이상의 긴 영상을 이해하며, 휴대폰 및 기기의 시각 지능을 조절하는 능력을 갖추고 있어 GPT-4o 수준의 시각적 이해 능력을 능가합니다.

▲대규모 시각언어모델 Qwen2-VL-72B 오픈소스

Qwen2-VL-72B는 글로벌 권위 있는 평가인 LMSYS Chatbot Arena Leaderboard에서 가장 높은 점수를 받은 오픈소스 시각적 이해 모델이 되었습니다.

Qwen2-VL-72B는 오픈소스 시각적 이해 모델 중 가장 높은 점수를 받았습니다.

Qwen2-Audio 대규모 오디오 언어 모델은 인간의 목소리, 음악 및 자연 소리를 이해하고 음성 채팅, 오디오 메시지 분석을 지원하며 8개 이상의 언어와 방언을 지원하는 오픈 소스 모델이며 주류 평가 지수에서 글로벌 리더입니다.

블로그 주소: http://qwenlm.github.io/blog/qwen2-vl/

3, 특별 모델: 가장 진보된 오픈소스 수학 모델 데뷔, GPT-4o 따라잡기

프로그래밍을 위한 Qwen2.5-Coder와 수학을 위한 Qwen2.5-Math도 이번 Cloud Habitat 컨퍼런스에서 오픈 소스로 발표되었습니다.

그 중 Qwen2.5-Math는 현재까지 가장 진보된 오픈소스 수학 모델 시리즈이며, 이번에는 오픈소스 1.5B, 7B, 72B의 세 가지 크기와 수학적 보상 모델인 Qwen2.5-Math-RM이 있습니다.

▲Qwen2.5-Math 오픈소스

주력 모델인 Qwen2-Math-72B-Instruct는 수학 관련 다운스트림 작업에서 GPT-4o 및 Claude 3.5와 같은 독점 모델보다 우수한 성능을 발휘합니다.

최대 5.5T 토큰의 프로그래밍 관련 데이터로 학습된 Qwen2.5-Coder는 같은 날 1.5B와 7B 버전으로 오픈 소스로 공개되었으며, 향후 32B 버전에서도 오픈 소스로 공개될 예정입니다.

▲Qwen2.5-코더 오픈소스

블로그 주소:

https://qwenlm.github.io/zh/blog/qwen2.5-math/

https://qwenlm.github.io/zh/blog/qwen2.5-coder/

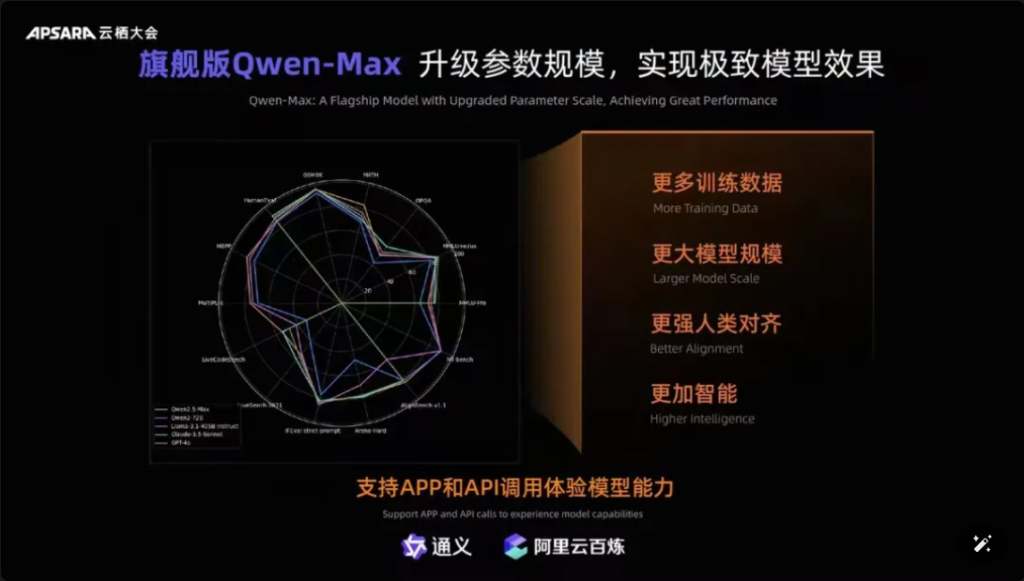

또한 Tongyiqianqian의 플래그십 모델인 Qwen-Max는 완전히 업그레이드되어 MMLU-Pro, MATH 등 10개 이상의 권위 있는 벤치마크에서 GPT-4o에 근접하거나 심지어 능가했으며 Tongyiqianqian과 Tongyi APP의 공식 웹사이트에서 온라인으로 제공됩니다. 사용자는 AliCloud Hundred Refinement Platform을 통해 Qwen-Max의 API를 호출할 수도 있습니다.

영화

▲Qwen-Max는 포괄적인 업그레이드를 실현합니다

2023년 4월 1세대 Tongyi Qianqian 대형 모델이 출시된 이후, AliCloud는 중국 기업이 저렴한 비용으로 대형 모델을 사용할 수 있도록 지원했으며, 이를 통해 오늘날의 Qwen2.5 시리즈가 "점점 더 유용해지고" 있습니다.

Qwen2.5 시리즈 모델은 기본 버전, 명령 수행 버전, 정량적 버전을 포함하며, 실제 시나리오에서 반복됩니다.

03. Qwen 다운로드 4000만 돌파!5만 마리 이상의 "아기"가 태어났습니다.

1년 반의 급속한 성장 끝에 통이큐웬은 이제 라마에 이어 세계적 모델 그룹으로 거듭났다.

저우징런은 이를 확인하기 위해 두 가지 최신 데이터를 발표했습니다.

첫째, 모델 다운로드 수입니다. 2024년 9월 초 현재 통이첸원의 오픈소스 모델 누적 다운로드가 4,000만 건을 돌파했습니다. 이는 개발자와 중소기업이 직접 투표한 결과입니다.

두 번째는 파생 모델의 수입니다. 9월 초 현재 통이의 토착 모델과 파생 모델의 총 수가 5만 개를 넘어 라마에 이어 두 번째로 많습니다.

▲통이천문 오픈소스 모델 누적 다운로드 4000만 돌파

지금까지 ‘동일 출처 1만 모델’은 중국 대형 모델 산업 발전의 중요한 추세로 자리 잡았습니다.

개념은 무엇인가? 중국 오픈소스는 성과 면에서 세계 1위일 뿐만 아니라 생태 확장 면에서도 세계 1위를 차지하고 있다. 국내외 오픈소스 커뮤니티, 생태 파트너, 개발자는 통이첸친의 "수돗물"이 되었고, 많은 기업이 채택한 최초의 빅 모델이자 가장 오랫동안 사용된 빅 모델이 되었다.

알리윈은 이르면 2023년 8월에 통이큐웬의 70억개 매개변수 모델을 오픈소스로 공개하여 무료로 상용화하였고, 올해에는 Qwen1.5, Qwen2, Qwen2.5가 잇따라 출시되어 개발자들이 가장 진보된 모델을 빠르게 사용할 수 있게 되었으며, 더 큰 제어력과 튜닝 공간을 확보하여 더 많은 기업이 선호하는 선택이 되었습니다.

7월 초, 세계 최대의 오픈소스 커뮤니티인 Hugging Face의 엔지니어들은 Tongyi가 중국에서 가장 많이 롤업된 빅 모델이라고 인증하는 트윗을 올렸습니다. 그리고 AliCloud를 통해 Tongyi Big Model은 다양한 산업에서 30만 명 이상의 고객에게 서비스를 제공했습니다. 2024년 2분기(알리바바의 2025 회계연도 1분기에 해당)에 Aliyun의 AI 관련 제품 매출은 3자리 수 성장을 실현했습니다.

▲통이빅모델, 30만명 이상 고객 서비스

앨리윈은 무엇을 잘했나요?

제 생각에 외국의 대형 제조사인 Microsoft와 ChatGPT가 긴밀히 협력하는 것과는 달리, Amazon과 AWS는 3자 모델을 융합하여 기반 인프라를 구축하고, Aliyun은 두 회사의 장점을 모두 통합하여 처음부터 AI 인프라 서비스와 자체 연구를 통해 대형 모델을 양손으로 선택했습니다.

알리바바 클라우드는 자체 연구 모델에 주력하고 있으며, 모델 오픈소스와 개방성을 확고히 하는 중국 유일의 클라우드 거대 기업으로, 모델 혁신, 생태적 호환성, 개발자 서비스 등에 막대한 투자를 아끼지 않고 있습니다. 이를 통해 통이의 거대 모델이 단계적으로 세계 AI 경쟁의 핵심으로 진입할 수 있도록 노력하고 있습니다.

04. 결론 : 모든 모델은 동일한 기원을 가지고 있습니다. 산업 분수령 순간

오픈소스 모델은 폐쇄형 소스 모델을 따라잡거나 심지어 따라잡고 있습니다. 7월 Meta의 Llama-405B에서 오늘날 AliCloud의 Qwen2.5-72B에 이르기까지 "모든 모델은 동일한 소스에서"라는 풍경이 형성되고 있습니다. Tongyi Qianqi 대형 모델의 1년 반 급증으로 많은 산업과 기업이 저비용 AI 스케일 랜딩을 실현할 수 있었으며 산업은 새로운 분수령에 접어들고 있습니다.

자주 묻는 질문

- 질문: Qwen2.5에 사용할 수 있는 모델 크기는 어떤 것들이 있나요? A: Qwen2.5는 0.5B에서 72B 매개변수까지 광범위한 모델을 제공하여 다양한 애플리케이션과 요구 사항에 맞는 옵션을 제공합니다.

- 질문: Qwen2.5는 프로그래밍 작업을 어떻게 지원하나요? 답변: Qwen2.5에는 최대 128,000개의 토큰을 지원하여 코드 생성, 추론 및 디버깅을 향상하도록 설계된 Qwen2.5-Coder라는 특수 시리즈가 포함되어 있습니다.

- 질문: Qwen2.5의 훈련 데이터는 어떤가요? 답변: Qwen2.5는 최대 18조 개의 토큰을 포함하는 방대한 데이터 세트에 대해 사전 학습되어 있어 언어에 대한 광범위한 이해를 보장합니다.

- 질문: Qwen2.5는 교육용으로 적합합니까? 대답: 네, Qwen2.5는 자연어 처리 기능을 갖추고 있어 대화형 학습 플랫폼을 포함한 교육 도구에 적합합니다.

- 질문: Qwen2.5는 다른 모델과 비교했을 때 벤치마크 성능이 어떻습니까? A: Qwen2.5는 현재 멀티모달 벤치마크에서 3위를 차지하고 있으며, 여러 영역에서 Llama3.1과 같은 모델보다 우수한 성과를 보이고 있습니다.

- 질문: Qwen2.5는 어떤 언어를 지원하나요? 답변: Qwen2.5는 Python, Java, C++ 등을 포함하되 이에 국한되지 않는 여러 언어를 지원합니다.

- 질문: Qwen2.5는 여러 프로그래밍 언어로 코드를 생성할 수 있나요? 대답: 네, Qwen2.5-Coder는 다양한 개발자의 요구에 맞춰 다양한 프로그래밍 언어로 코드를 생성할 수 있습니다.

- 질문: Qwen2.5는 긴 컨텍스트를 어떻게 처리하나요? 답변: Qwen2.5는 최대 32K의 컨텍스트 길이를 지원하므로 코드 완성 및 추론의 정확도를 향상시키는 데 유용합니다.

- 질문: Qwen2.5는 오픈 소스인가요? 답변: Qwen2.5의 오픈소스 버전은 아직 출시되지 않았지만, GitHub 등의 플랫폼에서 자세한 문서와 예제를 볼 수 있습니다.

- 질문: Qwen2.5를 실제로 적용할 수 있는 시나리오는 어떤 것이 있나요? 답변: Qwen2.5는 고객 서비스 챗봇, 콘텐츠 생성, 프로그래밍 지원, 교육, 번역 서비스, 법률 지원, 의료 지원, 마케팅, 데이터 분석, 자동 보고, 게임 개발, 가상 비서, 전자 상거래, 다양한 산업 분야에서의 다국어 지원에 활용할 수 있습니다.