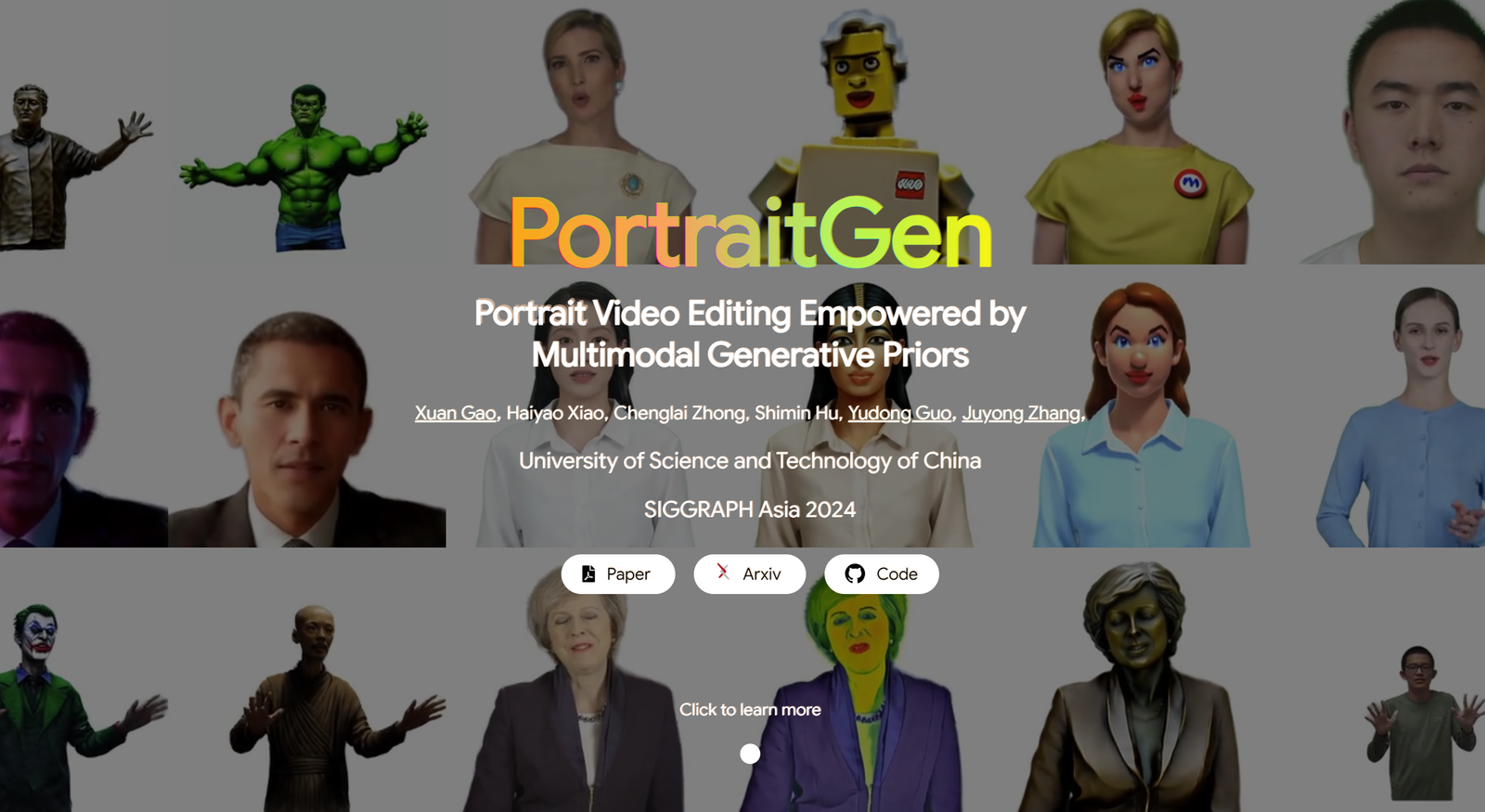

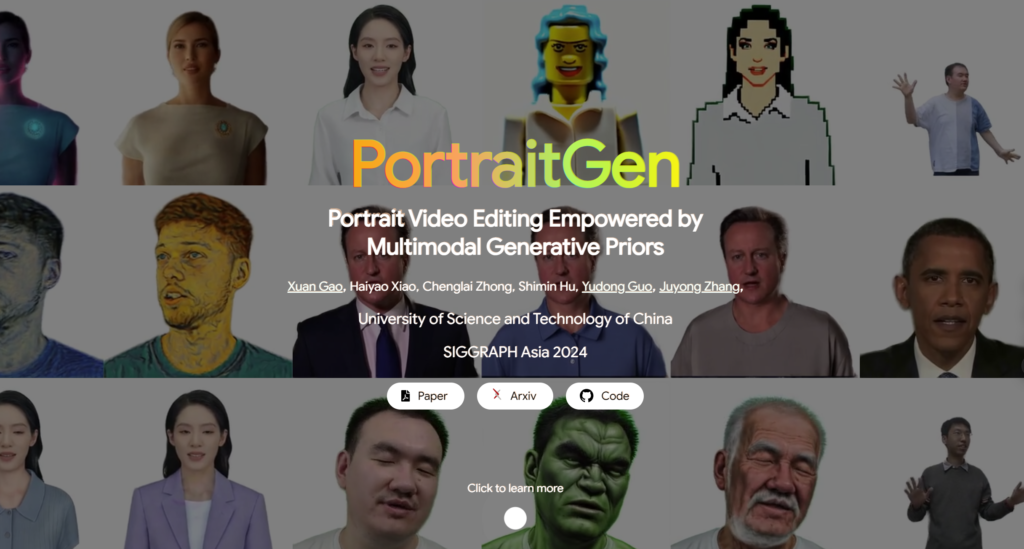

Portrait Videobearbeitung Unterstützt durch

Multimodale generative Prioren

Herkömmliche Methoden zur Bearbeitung von Portraitvideos haben oft Probleme mit 3D-Effekten und zeitlicher Konsistenz und schneiden auch in Bezug auf die Renderqualität und Effizienz schlecht ab. Um diese Probleme zu lösen, hebt PortraitGen jedes Bild eines Portraitvideos in ein einheitliches dynamisches 3D-Gauß-Feld an, das strukturelle und zeitliche Konsistenz von Bild zu Bild gewährleistet. PortraitGen ist eine leistungsstarke Methode zur Bearbeitung von Portraitvideos, die eine konsistente und ausdrucksstarke Stilisierung mit multimodalen Hinweisen ermöglicht.

Darüber hinaus hat PortraitGen einen neuen neuronalen Gaußschen Texturierungsmechanismus entwickelt, der nicht nur komplexe stilistische Bearbeitungen ermöglicht, sondern auch Rendergeschwindigkeiten von über 100 Bildern pro Sekunde ermöglicht. PortraitGen kombiniert eine breite Palette von Eingaben, die durch Wissen aus groß angelegten 2D-generativen Modellen erweitert werden. Es führt auch eine Anleitung zur Ähnlichkeit von Ausdrücken und ein Modul zur Bearbeitung von Porträts mit Gesichtserkennung ein, wodurch Probleme, die beim iterativen Aktualisieren eines Datensatzes auftreten können, effektiv reduziert werden. (Link am Ende des Artikels)

01 Bildunterschrift Inhalt

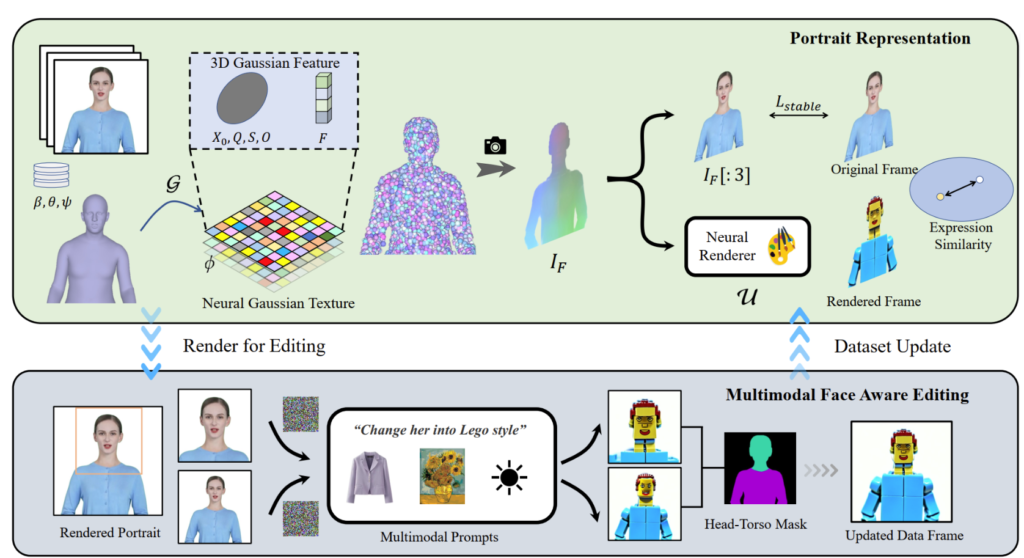

PortraitGen wandelt 2D-Porträtvideos in nur 30 Minuten in ein 4D-Gauß-Feld für die multimodale Porträtbearbeitung um. Das bearbeitete 3D-Porträt kann mit 100 Bildern pro Sekunde gerendert werden. Die SMPL-X-Koeffizienten im monokularen Video werden zuerst verfolgt und dann wird mithilfe eines neuro-gaußschen Texturmechanismus ein 3D-Gauß-Merkmalsfeld generiert.

Diese neuro-gaußschen Daten werden weiterverarbeitet, um das Porträtbild darzustellen. PortraitGen verwendet außerdem eine iterative Datensatzaktualisierungsstrategie zur Porträtbearbeitung und schlägt ein Bearbeitungsmodul zur Gesichtserkennung vor, um die Qualität der Ausdrücke zu verbessern und die personalisierte Gesichtsstruktur zu bewahren.

02 Praktische Anwendungen

Die PortraitGen-Lösung ist ein einheitliches Framework für die Bearbeitung von Portraitvideos. Jedes strukturerhaltende Bildbearbeitungsmodell kann zum Erstellen dreidimensionaler, konsistenter und zeitlich kohärenter Portraitvideos verwendet werden.

Textgesteuerte Bearbeitung: InstructPix2Pix wird als 2D-Bearbeitungsmodell verwendet. Sein UNet erfordert drei Eingaben: ein RGB-Eingabebild, einen Textbefehl und ein latentes Rauschen. Fügt dem gerenderten Bild etwas Rauschen hinzu und bearbeitet es basierend auf dem Eingabequellbild und den Anweisungen.

Bildgesteuerte Bearbeitung: konzentriert sich auf zwei Bearbeitungsarten basierend auf Bildhinweisen. Eine besteht darin, den globalen Stil eines Referenzbildes zu extrahieren, und die andere besteht darin, das Bild anzupassen, indem Objekte an bestimmten Stellen platziert werden. Diese Methoden werden experimentell für die Stilmigration und virtuelle Anpassung verwendet. Der Stil des Referenzbildes wurde mithilfe des Algorithmus „Neural Style Migration“ in die Datensatzrahmen migriert, und die Kleidung des Probanden wurde mithilfe von AnyDoor geändert.

Neubeleuchtung: Verwendung von IC-Light zur Manipulation der Beleuchtung von Videobildern. Bei einer Textbeschreibung als Beleuchtungsbedingung passt die PortraitGen-Methode die Beleuchtung des Porträtvideos harmonisch an

03 Kontrast- und Ablationsexperimente

Die PortraitGen-Methode wird mit modernsten Videobearbeitungsmethoden wie TokenFlow, Rerender A Video, CoDeF und AnyV2V verglichen. Die PortraitGen-Methode übertrifft die anderen Methoden in Bezug auf Just-in-Time-Erhaltung, Identitätserhaltung und zeitliche Konsistenz deutlich.

Die Zeitdauer 00:47

Inspiriert von der in „Delayed Neural Rendering“ vorgeschlagenen neuronalen Textur schlägt PortraitGen eine neuronale Gauß-Textur vor. Dieser Ansatz speichert lernbare Merkmale für jede Gauß-Textur, anstatt Kugelflächenfunktionskoeffizienten zu speichern. Als Nächstes wird ein 2D-Neural-Renderer verwendet, um die verarbeiteten Merkmalskarten in RGB-Signale umzuwandeln. Diese Methode liefert reichhaltigere Informationen als die Kugelflächenfunktionskoeffizienten und ermöglicht eine bessere Fusion der verarbeiteten Merkmale, wodurch die Bearbeitung komplexer Stile wie Lego und Pixelkunst erleichtert wird.

Wenn beim Bearbeiten eines Oberkörperbilds das Gesicht nur einen kleinen Bereich einnimmt, ist die Bearbeitung des Modells möglicherweise nicht gut an die Kopfhaltung und Gesichtsstruktur angepasst. Facial Awareness Portrait Editing (FA) kann die Ergebnisse verbessern, indem zwei Bearbeitungen durchgeführt werden, um den Fokus auf die Gesichtsstruktur zu erhöhen.

Indem wir das gerenderte Bild und das Bild der Eingabequelle in den latenten Ausdrucksraum von EMOCA abbilden und die Ähnlichkeit der Ausdrücke optimieren, können wir sicherstellen, dass die Ausdrücke natürlich bleiben und mit den ursprünglichen Videobildern übereinstimmen.

Die Technik hinter PortraitGen

Referenz

Weitere Informationen zu PotraitGen finden Sie hier: https://ustc3dv.github.io/PortraitGen/