Tongyi Qianqian Qwen nedladdningar översteg 40 miljoner, "gyttande" mer än 50 000 barnmodeller.

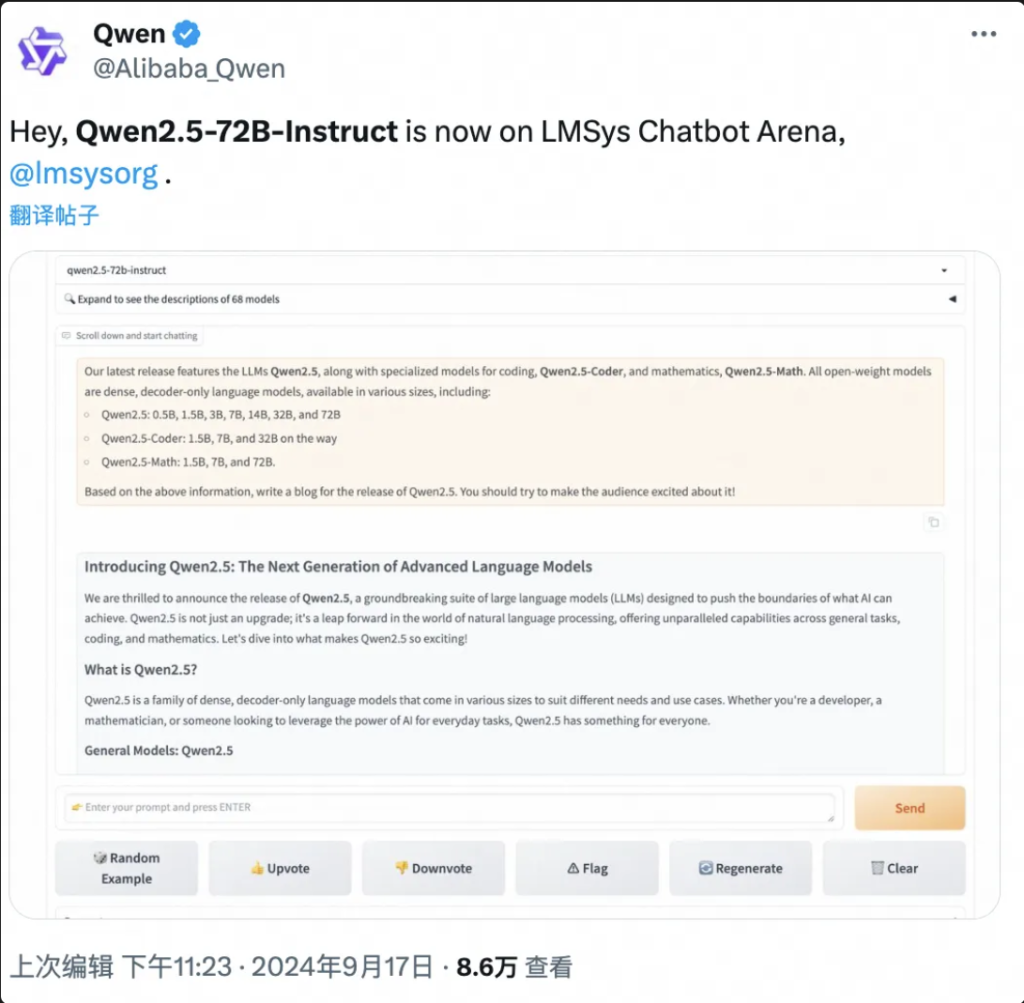

Ingen BS låt först testa Qwen här:

Cloud computing "Spring Festival Gala" Yunqi-konferensen öppnade, Tongyi Qwen stora modellen exploderade återigen hela scenen!

Kloka saker rapporterade den 19 september, Hangzhou, idag lanserade Ali Cloud världens starkaste stormodell med öppen källkod Qwen2.5-72B, prestanda "korsmätning" bortom Llama3.1-405B, och sedan på tronen i den globala stora modellen med öppen källkod.

Följande är en sammanfattning av resultatet av arbetet med detta projekt

Qwen2.5-72B överträffar Llama-405B i många auktoritativa tester.

Samtidigt skapades sedan en stor serie Qwen2.5-modeller med öppen källkod, inklusive: språkmodellen Qwen2.5, visuell språkmodell Qwen2-VL-72B, programmeringsmodellen Qwen2.5-Coder och den matematiska modellen Qwen2.5-Math, etc., med en sammanlagd summa på mer än 100 på hyllorna i G-PT och några av dem som ställs in i G-PT. nytt världsrekord.

"It's Crazy Thursday", 'Epic Product' …… På några timmar sedan lanseringen har Qwen2.5 satt igång en frenesi av diskussioner på sociala medier hemma och utomlands, och utvecklare runt om i världen har anslutit sig till testteamet.

▲Qwen2.5 är ett hett ämne på sociala medier hemma och utomlands.

Qwen2.5-Math, till exempel, kombinerar visuell igenkänning med Qwen2.5-Math. När du matar in en skärmdump av en geometriskt liknande flervalsfråga, känner Qwen2.5-Math snabbt igen innebörden av frågan och ger rätt lösning och svar "B", som är både korrekt och snabbt. Noggrannheten och hastigheten är fantastisk.

Det här är första gången jag har sett Qwen2.5-Math på webben.

▲Qwen2.5-Math Trial

På bara ett och ett halvt år sedan april 2023 har Qwen vuxit till en modellgrupp i världsklass efter Llama.

Enligt de senaste uppgifterna som släppts av Zhou Jingren, CTO för AliCloud, i mitten av september 2024, har det kumulativa antalet nedladdningar av Tongyi Qwen-modeller med öppen källkod överstigit 40 miljoner, och mer än 50 000 stora modeller har härletts.

▲Qwen-serien härledde stora modeller över 50 000

Vilka är de specifika prestandaförbättringarna för Qwen 2.5? Vilka är höjdpunkterna i de 100 nya modellerna med öppen källkod? Qwen2.5 är den första i sitt slag i världen, och den är den första i sitt slag i Kina.

Bloggadress: https://qwenlm.github.io/blog/qwen2.5/

Projektadress: https://huggingface.co/spaces/Qwen/Qwen2.5

▲ Den officiella bloggen släpper Aliyun Qwen 2.5 Model Clusters

01. Toppar den globala listan igen, Qwen2.5 cross-volym Ikapp med Llama3.1-405B

Låt oss ta en titt på prestandan för Qwen2.5 specifikt.

Qwen2.5-modellen stöder upp till 128K kontextlängd, kan generera upp till 8K innehåll och stöder mer än 29 språk, vilket innebär att den kan hjälpa användare att skriva artiklar på 10 000 ord.

Inte nog med det, baserat på 18T-tokendataförträning, har Qwen2.5 mer än 18% övergripande prestandaförbättring jämfört med Qwen2, med mer kunskap och starkare programmerings- och matematikkunskaper.

▲AliCloud CTO Zhou Jingren förklarar Qwen2.5

Det rapporteras att flaggskeppsmodellen, Qwen2.5-72B-modellen, fick så höga poäng som 86,8, 88,2 och 83,1 på MMLU-rudex benchmark (som undersöker allmän kunskap), MBPP benchmark (som undersöker kodningsförmåga) och MATH benchmark (som undersöker matematisk förmåga).

Qwen2.5, med sina 72 miljarder parametrar, överträffar till och med Llama3.1-405B, med sina 405 miljarder parametrar, "i storleksordningar".

Llama3.1-405B släpptes av Meta i juli 2024, och i mer än 150 benchmark-testuppsättningar var den lika med eller till och med överträffade den dåvarande SOTA-modellen (bäst i branschen) GPT-4o, vilket utlöste påståendet att "den starkaste modellen med öppen källkod är den starkaste modellen".

Qwen2.5-72B-Instruct, uppföljningsversionen av Qwen2.5, överträffade Llama3.1-405B i MMLU-redux, MATH, MBPP, LiveCodeBench, Arena-Hard, AlignBench, MT-Bench, MultiPL-E och andra auktoritativa utvärderingar. 405B.

Bilder

▲Qwen2.5-72B modell utvärdering situation

Qwen2.5 är återigen världens starkaste modell för öppen källkod, och bidrar till branschtrenden med "öppen källkod över stängd källkod".

Det här är AliCloud som följer den öppna källkodsserien Tongyi Qianqian Qwen2 i juni i år, ikapp den då starkaste modellen med öppen källkod Llama3-70B och lanserar sedan en serie versioner av öppen källkod.

Det har blivit en välbekant rytm i AI-utvecklargemenskapen att varje ny kung som dyker upp snart överträffas av en ny version av Tongyi.

Efter att Qwen2.5 öppnades på kvällen den 18 september var många utvecklare så exalterade att de inte sov och provade det först.

Jag är inte säker på om jag kommer att kunna göra det.

▲Utvecklare hemma och utomlands diskuterar intensivt Qwen2.5

02. Den största modellgemenskapen i världens historia

Det viktigaste är att ha en god förståelse för vad som händer i världen och hur det fungerar.

Qwen2.5-modelleringsgemenskapen med öppen källkod är den största någonsin.

Zhou Jingren, CTO för AliCloud, tillkännagav vid Yunqi-konferensen att Qwen2.5-serien uppgick till mer än 100 modeller med öppen källkod på hyllorna, helt anpassad till utvecklarnas och små och medelstora företags behov i olika scenarier.

Detta svarar på uppmaningar från många utvecklare, som har "manat" under lång tid i stora sociala medier.

▲Utvecklare hemma och utomlands uppmanar mer Qwen2.5

1, språkmodell: från 0,5B till 72B sju storlekar, från ändsidan till scenarier av industriell kvalitet full täckning

Qwen2.5 har sju språkmodeller med öppen källkod, inklusive 0,5B, 1,5B, 3B, 7B, 14B, 32B och 72B, som alla har uppnått SOTA-resultat i motsvarande spår.

Bilder

▲Multi-size Qwen2.5 möter behoven i olika scenarier

Med tanke på dess avancerade möjligheter inom Natural Language Processing (NLP) och kodningsförståelse är Alibaba Clouds Qwen2.5 designad för att hantera ett brett spektrum av applikationer. Här är några specifika scenarier där Qwen2.5 kan användas:

- Förbättrad kundservice: Qwen2.5 kan användas i chatbots för mer mänskliga interaktioner, effektivt svara på kundfrågor och tillhandahålla lösningar.

- Skapa innehåll: Modellen kan hjälpa till att generera artiklar, inlägg på sociala medier och annat skriftligt innehåll, vilket sparar tid för innehållsskapare.

- Programmeringshjälp: Med sin specialiserade Qwen2.5-Coder-serie kan den hjälpa utvecklare genom att föreslå kodavsnitt, felsökningshjälp och automatisera vissa kodningsuppgifter.

- Utbildning och lärande: Qwen2.5 kan användas för att utveckla utbildningsverktyg som interaktiva lärplattformar som ger förklaringar, svarar på elevernas frågor och till och med betygsätter uppgifter.

- Översättningstjänster: Med tanke på dess kunskaper i flera språk kan den tillhandahålla översättningstjänster i realtid för att överbrygga språkklyftan i internationell kommunikation.

- Forskning och utveckling: Inom forskning kan Qwen2.5 bearbeta stora mängder textdata för att hjälpa till att upptäcka mönster, sammanfatta resultat och generera rapporter.

- Juridisk hjälp: Modellen kan läsa juridiska dokument, extrahera relevant information och till och med utarbeta grundläggande juridiska dokument, vilket sparar tid för jurister.

- Sjukvårdsstöd: Qwen2.5 kan användas för att svara på vanliga hälsofrågor, tillhandahålla medicinsk information och hjälpa till med att hantera patientdata.

- Marknadsföring och reklam: Det kan hjälpa till att skapa personligt anpassat marknadsföringsinnehåll, annonstexter och kampanjer i sociala medier som riktar sig till specifika målgrupper.

- Dataanalys: Qwen2.5 kan bearbeta och analysera stora datamängder för att ge insikter och hjälpa till att fatta datadrivna beslut.

- Automatisk rapportering: Modellen kan generera rapporter genom att bearbeta data och information inom en mängd olika områden, vilket är särskilt användbart i finansiell och affärsanalys.

- Spelutveckling: Qwen2.5 kan hjälpa till att skapa interaktiv dialog och berättelser för videospelkaraktärer för att öka spelarens engagemang.

- Virtuell assistent: Den driver virtuella assistenter som kan hantera scheman, ställa in påminnelser och ge personliga råd.

- E-handel: Qwen2.5 kan hjälpa till att skapa produktbeskrivningar, hantera kundförfrågningar och skapa personliga shoppingupplevelser.

- Flerspråkig support: Den kan användas i globala applikationer som kräver flerspråkig interaktion, såsom internationell kundtjänst eller innehållslokalisering.

Dessa versioner hjälper utvecklare att balansera modellkapacitet och kostnad, och anpassa sig till en mängd olika scenarier. Till exempel är 3B den gyllene storleken för att anpassa sig till mobiltelefoner och andra slutenheter, 32B är det mest förväntade av utvecklare att vara "kungen av kostnadseffektiva", och 72B är kungen av prestandan för scenarierna av industriell kvalitet och vetenskaplig forskning.

Bloggadress: https://qwenlm.github.io/zh/blog/qwen2.5-llm/

2、Multimodal modell: visuell modell förstår 20 minuters video, ljudspråkmodell stöder 8 språk

Qwen2-VL-72B, den efterlängtade storskaliga visuella språkmodellen, är officiellt öppen källkod idag.

Qwen2-VL kan känna igen bilder med olika upplösningar och bildförhållanden, förstå långa videor på mer än 20 minuter, har förmågan att reglera den visuella intelligensen hos mobiltelefoner och enheter och överträffa GPT-4o-nivån för visuell förståelse.

▲ Storskalig visuell språkmodell Qwen2-VL-72B öppen källkod

Qwen2-VL-72B blev den mest poänggivande modellen för öppen källkod för visuell förståelse i den globala auktoritativa utvärderingen LMSYS Chatbot Arena Leaderboard.

Qwen2-VL-72B är den mest poänggivande modellen för visuell förståelse för öppen källkod.

Qwen2-Audio storskalig ljudspråkmodell är en modell med öppen källkod som kan förstå mänsklig röst, musik och naturligt ljud, stödja röstchatt, ljudmeddelandeanalys och stödja mer än 8 språk och dialekter, och den är en global ledare inom mainstream-utvärderingsindex.

Bloggadress: http://qwenlm.github.io/blog/qwen2-vl/

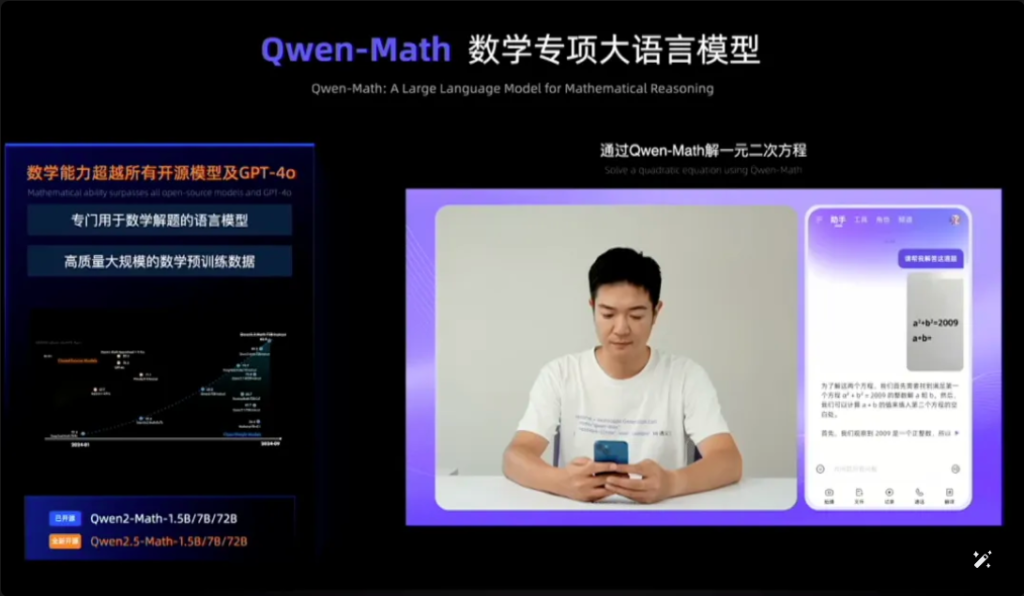

3, specialmodell: debut för den mest avancerade matematiska modellen med öppen källkod, ikapp GPT-4o

Qwen2.5-Coder för programmering och Qwen2.5-Math för matematik tillkännagavs också som öppen källkod vid denna Cloud Habitat-konferens.

Bland dem är Qwen2.5-Math den mest avancerade matematiska modellserien med öppen källkod hittills, denna gång öppen källkod 1.5B, 7B, 72B tre storlekar och matematisk belöningsmodell Qwen2.5-Math-RM.

▲Qwen2.5-Math öppen källkod

Flaggskeppsmodellen Qwen2-Math-72B-Instruct överträffar proprietära modeller som GPT-4o och Claude 3.5 i matematikrelaterade nedströmsuppgifter.

Qwen2.5-Coder, som tränades på upp till 5,5T tokens av programmeringsrelaterad data, var öppen källkod samma dag i versionerna 1.5B och 7B, och kommer att vara öppen källkod i framtiden i version 32B.

▲Qwen2.5-Coder öppen källkod

Bloggadress:

https://qwenlm.github.io/zh/blog/qwen2.5-math/

https://qwenlm.github.io/zh/blog/qwen2.5-coder/

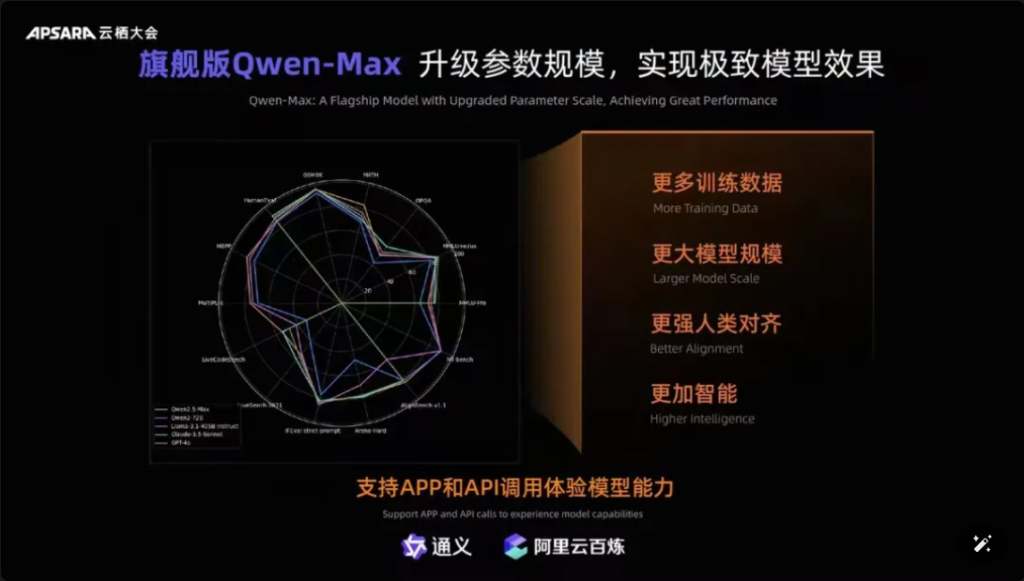

Dessutom är det värt att nämna att Qwen-Max, flaggskeppsmodellen för Tongyiqianqian, har blivit helt uppgraderad, närmar sig eller till och med överträffat GPT-4o på mer än tio auktoritativa riktmärken, såsom MMLU-Pro, MATH, etc., och är online på den officiella webbplatsen för Tongyiqianqian och Tongyi APP. Användare kan också anropa Qwen-Max API:er genom AliCloud Hundred Refinement Platform.

Bilder

▲Qwen-Max gör en omfattande uppgradering

Sedan lanseringen av den första generationen av den stora modellen Tongyi Qianqian i april 2023, har AliCloud gjort det möjligt för kinesiska företag att använda den stora modellen till låg kostnad, vilket i sin tur har drivit dagens Qwen2.5-serie till att bli "mer och mer användbar".

Qwen2.5-seriens modeller täcker grundversionen, kommandoföljande version, kvantitativ version, som upprepas i verkliga scenarier.

03.Qwen nedladdningar översteg 40 miljoner! Mer än 50 000 "bebisar" har fötts.

Efter ett och ett halvt år av snabb utveckling har Tongyi Qwen blivit en modellgrupp i världsklass efter Lama.

Zhou Jingren tillkännagav två uppsättningar av de senaste uppgifterna för att bekräfta detta:

För det första, antalet modellnedladdningar, i början av september 2024 har de kumulativa nedladdningarna av Tongyi Qianwens modeller med öppen källkod överstigit 40 miljoner, vilket är resultatet av att utvecklare och små och medelstora företag röstar med fötterna;

Den andra är antalet härledda modeller, i början av september översteg det totala antalet Tongyis inhemska och härledda modeller 50 000, näst efter Llama.

▲ Tongyi Thousand Questions open source-modell kumulativa nedladdningar översteg 40 miljoner

Hittills har "10 000 modeller med samma källa" blivit en betydande trend i utvecklingen av Kinas stora modellindustri.

Vad är konceptet? Den kinesiska öppna källkoden rankas inte bara först i världen när det gäller prestanda, utan också när det gäller ekologisk expansion. Gemenskaper med öppen källkod, ekologiska partners och utvecklare hemma och utomlands har blivit "kranvattnet" för Tongyi Chienqin, som har blivit den första stora modellen som antagits av många företag, och även den stora modellen som har använts längst.

Redan i augusti 2023 släppte Aliyun den 7 miljarder parametermodellen av Tongyi Qwen med öppen källkod för att fri kommersialisering, och sedan släpptes årets Qwen1.5, Qwen2, Qwen2.5 en efter en, så att utvecklare snabbt kan använda den mest avancerade modellen samtidigt, för att få större kontroll och inställningsutrymme, och därmed bli det föredragna valet för fler företag.

I början av juli hade ingenjörer från Hugging Face, världens största open source-community, twittrat för att intyga att Tongyi är den mest upprullade stora modellen i Kina. Och genom AliCloud har Tongyi Big Model betjänat mer än 300 000 kunder i olika branscher. Under det bara senaste andra kvartalet 2024 (motsvarande Q1 av Alibabas räkenskapsår 2025), realiserade Aliyuns AI-relaterade produktintäkter tresiffrig tillväxt.

▲Tongyi Big Model betjänar mer än 300 000 kunder

Vad gjorde Aliyun rätt?

Enligt min åsikt, till skillnad från de utländska stora tillverkarna Microsoft och ChatGPT stark bindning, Amazon AWS konvergens av trepartsmodellen för att göra den underliggande infrastrukturen, integrerade Aliyun fördelarna med de två, i början, valde att AI-infrastrukturtjänster och självforskning stor modell med två händer.

Med fokus på självforskningsmodeller är Ali Cloud den enda molnjätten i Kina som är tydligt med öppen källkod och öppenhet för modeller, och har inte sparat några ansträngningar för att göra en enorm investering i modellgenombrott, ekologisk kompatibilitet, utvecklartjänster etc., för att göra Tongyi stora modeller steg för steg in i kärncirkeln i världens AI-konkurrens.

04. Slutsats: Alla modeller har samma ursprung Industry Watershed Moment

Modeller med öppen källkod kommer ikapp eller till och med ikapp modeller med stängd källkod. Från Metas Llama-405B i juli till AliClouds Qwen2.5-72B idag tar landskapet av "alla modeller från samma källa" form. Den ett och ett halvt år långa ökningen av den stora modellen Tongyi Qianqi har gjort det möjligt för många industrier och företag att realisera landning i AI-skala med lägre kostnader, och industrin går in i en ny vattendelare.

Vanliga frågor

- F: Vilka olika modellstorlekar finns tillgängliga för Qwen2.5? S: Qwen2.5 erbjuder en rad modeller från 0,5B till 72B parametrar, vilket ger alternativ för olika applikationer och krav.

- F: Hur stöder Qwen2.5 programmeringsuppgifter? S: Qwen2.5 innehåller en specialiserad serie som heter Qwen2.5-Coder, designad för att förbättra kodgenerering, slutledning och felsökning, med stöd för upp till 128K tokens.

- F: Hur ser träningsdata ut för Qwen2.5? S: Qwen2.5 är förtränad på ett stort dataset som täcker upp till 18 biljoner tokens, vilket säkerställer en bred språkförståelse.

- F: Är Qwen2.5 lämplig för utbildning? S: Ja, Qwen2.5:s möjligheter inom naturlig språkbehandling gör den lämplig för utbildningsverktyg, inklusive interaktiva lärplattformar.

- F: Hur presterar Qwen2.5 i benchmarks jämfört med andra modeller? S: Qwen2.5 rankas för närvarande på tredje plats i multimodala riktmärken och överträffar modeller som Llama3.1 på flera områden.

- F: Vilka språk stöder Qwen2.5? S: Qwen2.5 stöder flera språk, inklusive men inte begränsat till Python, Java och C++.

- F: Kan Qwen2.5 generera kod på flera programmeringsspråk? S: Ja, Qwen2.5-Coder kan generera kod i olika programmeringsspråk, för att tillgodose behoven hos olika utvecklare.

- F: Hur hanterar Qwen2.5 långa sammanhang? S: Qwen2.5 stöder kontextlängder upp till 32K, vilket är fördelaktigt för att förbättra noggrannheten i kodkomplettering och slutledning.

- F: Är Qwen2.5 öppen källkod? S: Även om öppen källkodsversionen av Qwen2.5 ännu inte har släppts, finns detaljerad dokumentation och exempel tillgängliga på plattformar som GitHub.

- F: Vilka är några verkliga tillämpningsscenarier för Qwen2.5? S: Qwen2.5 kan användas i kundtjänstchattbotar, innehållsskapande, programmeringshjälp, utbildning, översättningstjänster, juridisk assistans, sjukvårdssupport, marknadsföring, dataanalys, automatiserad rapportering, spelutveckling, virtuella assistenter, e-handel och flerspråkig support inom olika branscher.