Porträtt videoredigering bemyndigad av

Multimodala Generativa Priorer

Traditionella metoder för porträttvideoredigering har ofta problem med 3D-effekter och tidsmässig konsistens, och presterar också dåligt när det gäller renderingskvalitet och effektivitet. För att lösa dessa problem lyfter PortraitGen varje bildruta i en porträttvideo till ett enhetligt dynamiskt 3D Gaussiskt fält, vilket säkerställer strukturell och tidsmässig konsistens från bildruta till bildruta.PortraitGen är en kraftfull porträttvideoredigeringsmetod som möjliggör konsekvent och uttrycksfull stilisering med multimodala signaler.

Dessutom har PortraitGen tagit fram en ny neural gaussisk textureringsmekanism som inte bara möjliggör komplex stilistisk redigering, utan också möjliggör renderingshastigheter på över 100 bilder per sekund. PortraitGen kombinerar ett brett utbud av indata som förstärks av kunskap som destillerats från storskaliga 2D-generativa modeller. Den introducerar också vägledning för uttryckslikhet och en porträttredigeringsmodul för ansiktsigenkänning, vilket effektivt minskar problem som kan uppstå vid iterativ uppdatering av en datauppsättning. (Länk längst ner i artikeln)

01 Bildtextinnehåll

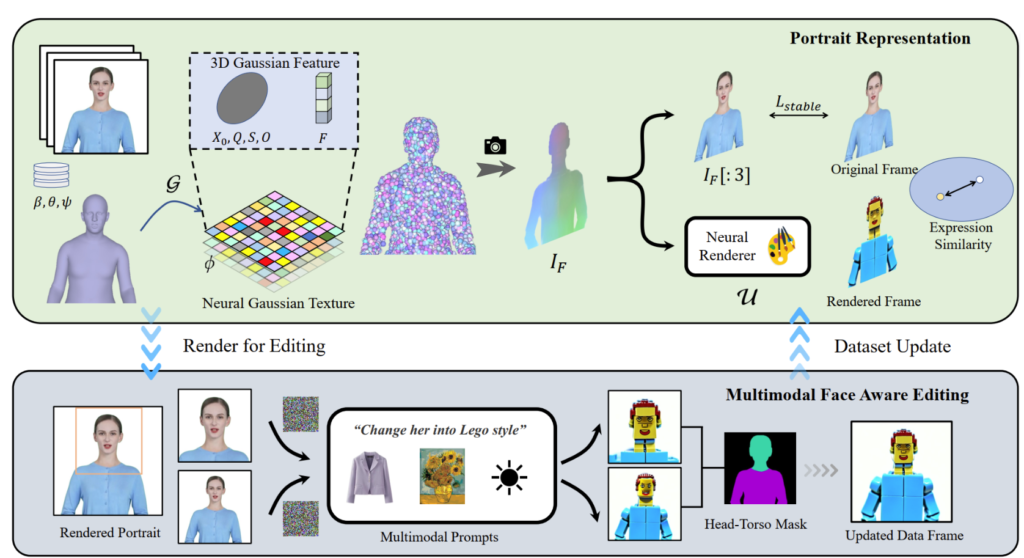

PortraitGen lyfter 2D-porträttvideor till ett 4D Gaussiskt fält för multimodal porträttredigering på bara 30 minuter. Det redigerade 3D-porträttet kan renderas med 100 bilder per sekund. SMPL-X-koefficienterna i den monokulära videon spåras först och sedan genereras ett 3D Gaussiskt funktionsfält med hjälp av en neuro-Gaussisk texturmekanism.

Dessa neuro-Gaussiska data bearbetas ytterligare för att återge porträttbilden. PortraitGen använder också en iterativ datauppsättningsstrategi för porträttredigering och föreslår en redigeringsmodul för ansiktsigenkänning för att förbättra kvaliteten på uttrycken och bevara den personliga ansiktsstrukturen.

02 Praktisk användning

PortraitGen-lösningen är ett enhetligt ramverk för porträttvideoredigering. Alla bildredigeringsmodeller som bevarar struktur kan användas för att komponera 3D-konsekventa och tidsmässigt sammanhängande porträttvideor.

Textdriven redigering: InstructPix2Pix används som en 2D-redigeringsmodell. Dess UNet kräver tre ingångar: en ingångs RGB-bild, ett textkommando och en latent brus. Lägger till lite brus till den renderade bilden och redigerar den baserat på indatakällans bild och instruktioner.

Bilddriven redigering: fokuserar på två typer av redigering baserad på bildsignaler. Den ena är att extrahera den globala stilen för en referensbild och den andra är att anpassa bilden genom att placera objekt på specifika platser. Dessa metoder används experimentellt för stilmigrering och virtuell anpassning. Stilen på referensbilden migrerades till datauppsättningsramarna med hjälp av Neural Style Migration-algoritmen och motivets kläder byttes med AnyDoor.

Relighting: Använd IC-Light för att manipulera belysningen av videoramar. Givet en textbeskrivning som ljusförhållande, justerar PortraitGen-metoden harmoniskt ljuset i porträttvideon

03 Kontrast- och ablationsexperiment

PortraitGen-metoden jämförs med toppmoderna videoredigeringsmetoder inklusive TokenFlow, Rerender A Video, CoDeF och AnyV2V. PortraitGen-metoden överträffar betydligt de andra metoderna när det gäller just-in-time bevarande, identitetsbevarande och tidsmässig konsistens.

Tidslängden 00:47

Inspirerad av den neurala textur som föreslagits i 'Delayed Neural Rendering', föreslår PortraitGen en neural Gaussisk textur. Detta tillvägagångssätt lagrar inlärbara egenskaper för varje Gauss istället för att lagra sfäriska harmoniska koefficienter. Därefter används en 2D neural renderare för att konvertera de bearbetade funktionskartorna till RGB-signaler. Denna metod ger rikare information än de sfäriska harmoniska koefficienterna och möjliggör bättre sammansmältning av de bearbetade funktionerna, vilket gör det lättare att redigera komplexa stilar som Lego och pixelkonst.

När du redigerar en överkroppsbild, om ansiktet upptar en liten yta, kanske redigeringen av modellen inte är väl anpassad till huvudställningen och ansiktsstrukturen. Facial Awareness Portrait Editing (FA) kan förbättra resultaten genom att utföra två redigeringar för att öka fokus på ansiktsstruktur.

Genom att mappa den renderade bilden och ingångskällans bild till EMOCAs latenta uttrycksutrymme och optimera likheten mellan uttryck, kan vi säkerställa att uttrycken förblir naturliga och konsekventa med de ursprungliga videoramarna.

Tekniken bakom PortraitGen

Referens

du kan hitta mer om PotraitGen här :https://ustc3dv.github.io/PortraitGen/