Количество загрузок Tongyi Qianqian Qwen превысило 40 миллионов, «породив» более 50 000 дочерних моделей.

Никаких глупостей, давайте сначала проверим Qwen здесь:

Открытие конференции Yunqi «Весенний гала-фестиваль» по облачным вычислениям, крупная модель Tongyi Qwen снова взорвала всю сцену!

Wise Things сообщил 19 сентября, Ханчжоу, сегодня Ali Cloud запустил самую мощную в мире большую модель с открытым исходным кодом Qwen2.5-72B, производительность которой «по перекрёстным меркам» превосходит Llama3.1-405B, а затем она заняла трон глобальной большой модели с открытым исходным кодом.

Ниже приводится краткое изложение результатов работы над этим проектом.

Qwen2.5-72B превосходит Llama-405B во многих авторитетных тестах.

В то же время большая серия моделей Qwen2.5 была затем открыта для исходного кода, включая: языковую модель Qwen2.5, визуальную языковую модель Qwen2-VL-72B, модель программирования Qwen2.5-Coder и математическую модель Qwen2.5-Math и т. д., в общей сложности на полках магазинов их насчитывается более 100, а некоторые из них догнали по производительности GPT-4o, установив новый мировой рекорд.

«Безумный четверг», «Эпический продукт»… За несколько часов с момента релиза Qwen2.5 вызвал бурное обсуждение в социальных сетях как в стране, так и за рубежом, а к команде тестировщиков присоединились разработчики со всего мира.

▲Qwen2.5 — горячая тема в социальных сетях как в стране, так и за рубежом.

Например, Qwen2.5-Math объединяет визуальное распознавание с Qwen2.5-Math. При вводе снимка экрана геометрически похожего вопроса с несколькими вариантами ответов Qwen2.5-Math быстро распознает смысл вопроса и дает правильное решение и ответ «B», что является как точным, так и быстрым. Точность и скорость поразительны.

Я впервые вижу Qwen2.5-Math в сети.

▲Qwen2.5-Пробная математика

Всего за полтора года, с апреля 2023 года, Qwen превратилась в модельную группу мирового уровня, уступающую только Llama.

Согласно последним данным, опубликованным Чжоу Цзинжэнем, техническим директором AliCloud, по состоянию на середину сентября 2024 года совокупное количество загрузок моделей с открытым исходным кодом Tongyi Qwen превысило 40 миллионов, и было создано более 50 000 крупных моделей.

▲Серия Qwen производных больших моделей более 50 000

Каковы конкретные улучшения производительности Qwen 2.5? Каковы основные моменты 100 новых моделей с открытым исходным кодом? Qwen2.5 — первый в своем роде в мире, и первый в своем роде в Китае.

Адрес блога: https://qwenlm.github.io/blog/qwen2.5/

Адрес проекта: https://huggingface.co/spaces/Qwen/Qwen2.5

▲Официальный блог публикует кластеры моделей Aliyun Qwen 2.5

01. Qwen2.5 снова на первом месте в мировом списке, догоняя Llama3.1-405B

Давайте рассмотрим производительность Qwen2.5 более подробно.

Модель Qwen2.5 поддерживает длину контекста до 128 КБ, может генерировать до 8 КБ контента и поддерживает более 29 языков, что означает, что она может помочь пользователям писать статьи объемом 10 000 слов.

Более того, на основе предварительной подготовки данных токенов 18T, Qwen2.5 демонстрирует общее улучшение производительности более чем на 18% по сравнению с Qwen2, обладая большими знаниями и более сильными навыками программирования и математики.

▲ Технический директор AliCloud Чжоу Цзинжэнь объясняет Qwen2.5

Сообщается, что флагманская модель Qwen2.5-72B набрала 86,8, 88,2 и 83,1 балла в тесте MMLU-rudex (проверяющем общие знания), тесте MBPP (проверяющем способности к кодированию) и тесте MATH (проверяющем способности к математике).

Qwen2.5 с его 72 миллиардами параметров даже превосходит Llama3.1-405B с его 405 миллиардами параметров «на порядки».

Llama3.1-405B была выпущена Meta в июле 2024 года, и в более чем 150 тестовых наборах она сравнялась или даже превзошла тогдашнюю модель SOTA (лучшую в отрасли) GPT-4o, что дало повод утверждать, что «самая сильная модель с открытым исходным кодом — это самая сильная модель».

Qwen2.5-72B-Instruct, последующая версия Qwen2.5, превзошла Llama3.1-405B в MMLU-redux, MATH, MBPP, LiveCodeBench, Arena-Hard, AlignBench, MT-Bench, MultiPL-E и других авторитетных оценках. 405B.

Фотографии

▲Ситуация оценки модели Qwen2.5-72B

Qwen2.5 снова стала сильнейшей в мире моделью с открытым исходным кодом, способствуя отраслевой тенденции «открытый исходный код вместо закрытого».

Это AliCloud, который в июне этого года выпустил серию Tongyi Qianqian Qwen2 с открытым исходным кодом, догнал сильнейшую на тот момент модель с открытым исходным кодом Llama3-70B, а затем выпустил серию версий с открытым исходным кодом.

В сообществе разработчиков искусственного интеллекта уже стало привычным, что каждый новый появляющийся король вскоре оказывается превзойденным новой версией Тонги.

После того, как вечером 18 сентября был открыт Qwen2.5, многие разработчики были настолько взволнованы, что не спали и попробовали его первыми.

Я не уверен, что смогу это сделать.

▲Разработчики в стране и за рубежом горячо обсуждают Qwen2.5

02.Крупнейшее модельное сообщество в истории мира

Самое главное — хорошо понимать, что происходит в мире и как он работает.

Сообщество разработчиков программного обеспечения с открытым исходным кодом Qwen2.5 является крупнейшим за всю историю.

Чжоу Цзинжэнь, технический директор AliCloud, объявил на конференции Yunqi, что серия Qwen2.5 насчитывает более 100 моделей с открытым исходным кодом, полностью адаптированных к потребностям разработчиков и предприятий малого и среднего бизнеса в различных сценариях.

Это ответ на призывы многих разработчиков, которые уже давно «настойчиво» звучат в основных социальных сетях.

▲Разработчики в стране и за рубежом призывают больше Qwen2.5

1, языковая модель: от 0,5 до 72 Б, семь размеров, от конечных до промышленных сценариев, полный охват

Qwen2.5 открывает исходный код семи языковых моделей размера, включая 0.5B, 1.5B, 3B, 7B, 14B, 32B и 72B, все из которых достигли результатов SOTA в соответствующих треках.

Фотографии

▲Многоразмерный Qwen2.5 отвечает потребностям различных сценариев

Учитывая его передовые возможности в обработке естественного языка (NLP) и понимании кодирования, Qwen2.5 от Alibaba Cloud предназначен для обработки широкого спектра приложений. Вот некоторые конкретные сценарии, в которых может использоваться Qwen2.5:

- Улучшенное обслуживание клиентов: Qwen2.5 можно использовать в чат-ботах для более человеческого взаимодействия, эффективного ответа на запросы клиентов и предоставления решений.

- Создание контента: Модель может помочь в создании статей, постов в социальных сетях и другого письменного контента, экономя время создателей контента.

- Помощь в программировании: Благодаря специализированной серии Qwen2.5-Coder он может помочь разработчикам, предлагая фрагменты кода, помогая в отладке и автоматизируя определенные задачи кодирования.

- Образование и обучение: Qwen2.5 можно использовать для разработки образовательных инструментов, таких как интерактивные обучающие платформы, которые предоставляют объяснения, отвечают на вопросы учащихся и даже выставляют оценки заданиям.

- Услуги перевода: Благодаря знанию нескольких языков компания может предоставлять услуги перевода в режиме реального времени, устраняя языковой барьер в международном общении.

- Исследования и разработки: В ходе исследований Qwen2.5 может обрабатывать большие объемы текстовых данных, помогая выявлять закономерности, обобщать результаты и составлять отчеты.

- Юридическая помощь: Модель может читать юридические документы, извлекать соответствующую информацию и даже составлять основные юридические документы, экономя время юристов.

- Поддержка здравоохранения: Qwen2.5 можно использовать для ответов на распространенные вопросы о здоровье, предоставления медицинской информации и помощи в управлении данными пациентов.

- Маркетинг и реклама: Он может помочь в создании персонализированного маркетингового контента, рекламных текстов и кампаний в социальных сетях, ориентированных на определенную аудиторию.

- Аналитика данных: Qwen2.5 может обрабатывать и анализировать большие наборы данных, предоставляя ценную информацию и помогая принимать решения на основе данных.

- Автоматизированная отчетность: Модель может генерировать отчеты, обрабатывая данные и информацию в различных областях, что особенно полезно в финансовом и бизнес-анализе.

- Разработка игры: Qwen2.5 может помочь в создании интерактивных диалогов и повествований для персонажей видеоигр, чтобы повысить вовлеченность игроков.

- Виртуальный помощник: Он управляет виртуальными помощниками, которые могут управлять расписаниями, устанавливать напоминания и давать персонализированные советы.

- Электронная коммерция: Qwen2.5 поможет вам создавать описания продуктов, обрабатывать запросы клиентов и создавать персонализированные покупательские впечатления.

- Поддержка нескольких языков: Его можно использовать в глобальных приложениях, требующих многоязычного взаимодействия, например, для международного обслуживания клиентов или локализации контента.

Эти версии помогают разработчикам сбалансировать возможности модели и стоимость, а также адаптироваться к различным сценариям. Например, 3B — это золотой размер для адаптации к сотовым телефонам и другим конечным устройствам, 32B — наиболее ожидаемый разработчиками «король экономичности», а 72B — король производительности сценариев промышленного и научно-исследовательского уровня.

Адрес блога: https://qwenlm.github.io/zh/blog/qwen2.5-llm/

2. Мультимодальная модель: визуальная модель понимает 20 минут видео, аудиолингвистическая модель поддерживает 8 языков.

Qwen2-VL-72B, долгожданная крупномасштабная модель визуального языка, сегодня официально стала общедоступной.

Qwen2-VL может распознавать изображения с различным разрешением и соотношением сторон, понимать длинные видеоролики продолжительностью более 20 минут, обладает способностью регулировать визуальный интеллект мобильных телефонов и устройств и превосходить уровень визуального понимания GPT-4o.

▲Масштабная визуальная языковая модель Qwen2-VL-72B с открытым исходным кодом

Qwen2-VL-72B стала моделью визуального понимания с открытым исходным кодом, набравшей наибольшее количество баллов в авторитетном глобальном рейтинге LMSYS Chatbot Arena Leaderboard.

Qwen2-VL-72B — это открытая модель визуального понимания с наивысшим рейтингом.

Крупномасштабная модель языка аудио Qwen2-Audio — это модель с открытым исходным кодом, которая может распознавать человеческий голос, музыку и естественные звуки, поддерживать голосовой чат, анализ аудиосообщений и поддерживать более 8 языков и диалектов, а также является мировым лидером по индексу оценки основных языков.

Адрес блога: http://qwenlm.github.io/blog/qwen2-vl/

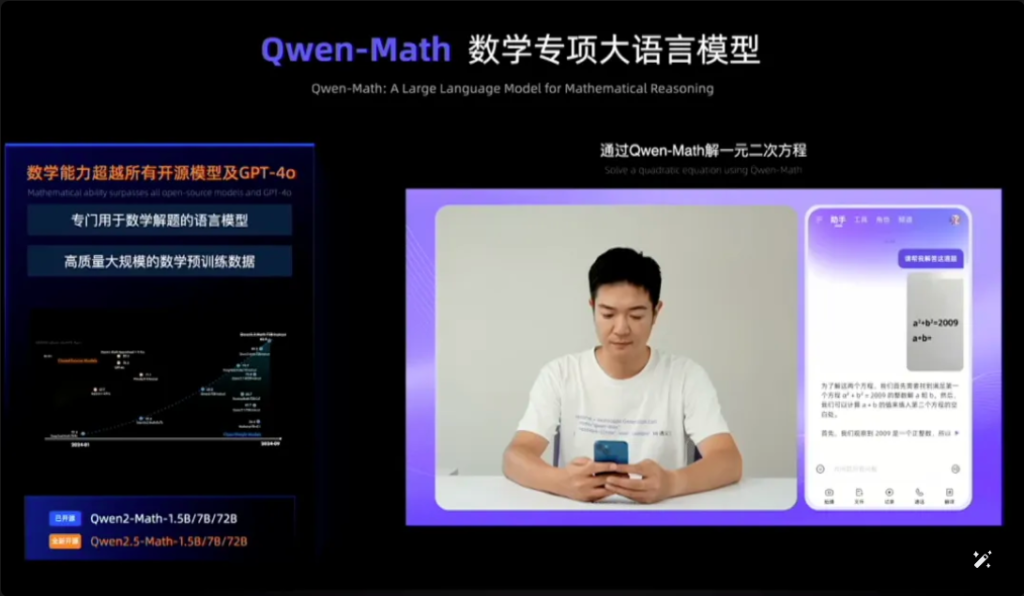

3, специальная модель: дебют самой передовой математической модели с открытым исходным кодом, догоняющей GPT-4o

На конференции Cloud Habitat также были анонсированы продукты с открытым исходным кодом Qwen2.5-Coder для программирования и Qwen2.5-Math для математики.

Среди них Qwen2.5-Math — самая продвинутая на сегодняшний день серия математических моделей с открытым исходным кодом, на этот раз с открытым исходным кодом 1.5B, 7B, 72B трех размеров и математическая модель вознаграждения Qwen2.5-Math-RM.

▲Qwen2.5-Math с открытым исходным кодом

Флагманская модель Qwen2-Math-72B-Instruct превосходит такие фирменные модели, как GPT-4o и Claude 3.5, в задачах, связанных с математикой.

Qwen2.5-Coder, обученный на 5,5T токенов данных, связанных с программированием, был открыт в тот же день в версиях 1.5B и 7B и будет открыт в будущем в версии 32B.

▲Qwen2.5-Coder с открытым исходным кодом

Адрес блога:

https://qwenlm.github.io/zh/blog/qwen2.5-math/

https://qwenlm.github.io/zh/blog/qwen2.5-coder/

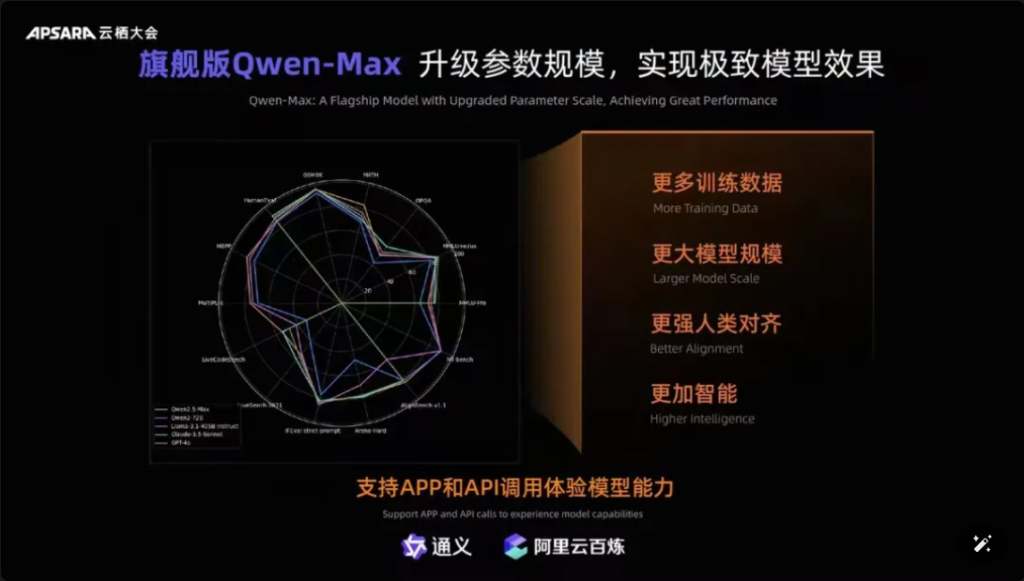

Кроме того, стоит отметить, что Qwen-Max, флагманская модель Tongyiqianqian, была полностью обновлена, приблизившись или даже превзойдя GPT-4o в более чем десяти авторитетных бенчмарках, таких как MMLU-Pro, MATH и т. д., и находится в сети на официальном сайте Tongyiqianqian и Tongyi APP. Пользователи также могут вызывать API Qwen-Max через платформу AliCloud Hundred Refinement.

Фотографии

▲Qwen-Max реализует комплексную модернизацию

С момента выпуска первого поколения большой модели Tongyi Qianqian в апреле 2023 года AliCloud позволил китайским предприятиям использовать большую модель по низкой цене, что, в свою очередь, сделало сегодняшнюю серию Qwen2.5 «все более и более полезной».

Модели серии Qwen2.5 охватывают базовую версию, версию с отслеживанием команд и количественную версию, которая итерируется в реальных сценариях.

03. Количество загрузок Qwen превысило 40 миллионов! На свет появилось более 50 000 «детей».

После полутора лет стремительного развития Tongyi Qwen стала модельной группой мирового класса, уступающей только Llama.

Чжоу Цзинжэнь обнародовал два набора последних данных, подтверждающих это:

Во-первых, количество загрузок моделей. По состоянию на начало сентября 2024 года общее количество загрузок моделей с открытым исходным кодом Tongyi Qianwen превысило 40 миллионов, что является результатом голосования разработчиков и представителей малого и среднего бизнеса ногами.

Во-вторых, это количество производных моделей: по состоянию на начало сентября общее количество собственных и производных моделей Tongyi превысило 50 000, уступая по этому показателю только Llama.

▲Общее количество загрузок модели Tongyi Thousand Questions с открытым исходным кодом превысило 40 миллионов

На сегодняшний день «10 000 моделей из одного источника» стали значимой тенденцией в развитии индустрии крупного моделирования в Китае.

В чем заключается концепция? Китайский открытый исходный код занимает первое место в мире не только по производительности, но и по экологическому расширению. Сообщества открытого исходного кода, экологические партнеры и разработчики в стране и за рубежом стали «водой из крана» Tongyi Chienqin, которая стала первой большой моделью, принятой многими предприятиями, а также самой долго используемой большой моделью.

Еще в августе 2023 года Aliyun открыла исходный код модели Tongyi Qwen с 7 миллиардами параметров для свободной коммерциализации, а затем в этом году Qwen1.5, Qwen2, Qwen2.5 были выпущены одна за другой, чтобы разработчики могли быстро использовать самую передовую модель одновременно, чтобы получить больше контроля и пространства для настройки, таким образом став предпочтительным выбором для большего количества предприятий.

В начале июля инженеры Hugging Face, крупнейшего в мире сообщества разработчиков ПО с открытым исходным кодом, опубликовали в Twitter сообщение, подтверждающее, что Tongyi — самая свернутая большая модель в Китае. А через AliCloud Tongyi Big Model обслужила более 300 000 клиентов в различных отраслях. Только что за прошедший второй квартал 2024 года (соответствующий первому кварталу 2025 финансового года Alibaba) выручка Aliyun от продуктов, связанных с ИИ, продемонстрировала трехзначный рост.

▲Tongyi Big Model обслуживает более 300 000 клиентов

Что Алиюн сделал правильно?

По моему мнению, в отличие от крупных иностранных производителей Microsoft и ChatGPT, сильно связывающих Amazon AWS, конвергенция трехсторонней модели для создания базовой инфраструктуры, Aliyun объединила преимущества двух, изначально выбрав службы инфраструктуры ИИ и самостоятельное исследование большой модели двумя руками.

Сосредоточившись на моделях самостоятельного исследования, Ali Cloud является единственным облачным гигантом в Китае, который твердо придерживается принципов открытого исходного кода и открытости моделей и не жалеет усилий, чтобы вложить огромные средства в прорывные модели, экологическую совместимость, услуги разработчиков и т. д., чтобы шаг за шагом вывести большие модели Tongyi в основной круг мирового соревнования в области искусственного интеллекта.

04.Вывод: Все модели имеют одинаковое происхождение. Переломный момент в отрасли

Модели с открытым исходным кодом догоняют или даже догоняют модели с закрытым исходным кодом. От Meta Llama-405B в июле до AliCloud Qwen2.5-72B сегодня формируется ландшафт «все модели из одного источника». Полуторагодовой всплеск большой модели Tongyi Qianqi позволил многим отраслям и предприятиям реализовать более дешевые масштабные посадки ИИ, и отрасль вступает в новый переломный момент.

FAQ

- В: Какие размеры моделей доступны для Qwen2.5? A: Qwen2.5 предлагает ряд моделей с параметрами от 0,5 до 72 Б, что обеспечивает варианты для различных приложений и требований.

- В: Каким образом Qwen2.5 поддерживает задачи программирования? A: Qwen2.5 включает в себя специализированную серию под названием Qwen2.5-Coder, разработанную для улучшения генерации кода, вывода и отладки с поддержкой до 128 тыс. токенов.

- В: Каковы данные обучения для Qwen2.5? A: Qwen2.5 предварительно обучен на обширном наборе данных, охватывающем до 18 триллионов токенов, что обеспечивает широкое понимание языка.

- В: Подходит ли Qwen2.5 для использования в образовании? A: Да, возможности Qwen2.5 в обработке естественного языка делают его пригодным для образовательных инструментов, включая интерактивные обучающие платформы.

- В: Как Qwen2.5 показывает себя в тестах по сравнению с другими моделями? A: Qwen2.5 в настоящее время занимает третье место в мультимодальных тестах, превосходя такие модели, как Llama3.1, в нескольких областях.

- В: Какие языки поддерживает Qwen2.5? A: Qwen2.5 поддерживает несколько языков, включая, помимо прочего, Python, Java и C++.

- В: Может ли Qwen2.5 генерировать код на нескольких языках программирования? A: Да, Qwen2.5-Coder способен генерировать код на различных языках программирования, удовлетворяя потребности разных разработчиков.

- В: Как Qwen2.5 обрабатывает длинные контексты? A: Qwen2.5 поддерживает длину контекста до 32 КБ, что полезно для повышения точности автодополнения кода и вывода.

- В: Является ли Qwen2.5 открытым исходным кодом? A: Хотя версия Qwen2.5 с открытым исходным кодом еще не выпущена, подробная документация и примеры доступны на таких платформах, как GitHub.

- В: Каковы реальные сценарии применения Qwen2.5? A: Qwen2.5 можно использовать в чат-ботах для обслуживания клиентов, создании контента, помощи в программировании, образовании, переводческих услугах, юридической помощи, поддержке здравоохранения, маркетинге, аналитике данных, автоматизированной отчетности, разработке игр, виртуальных помощниках, электронной коммерции и многоязычной поддержке в различных отраслях.