Portrett videoredigering bemyndiget av

Multimodale Generative Priors

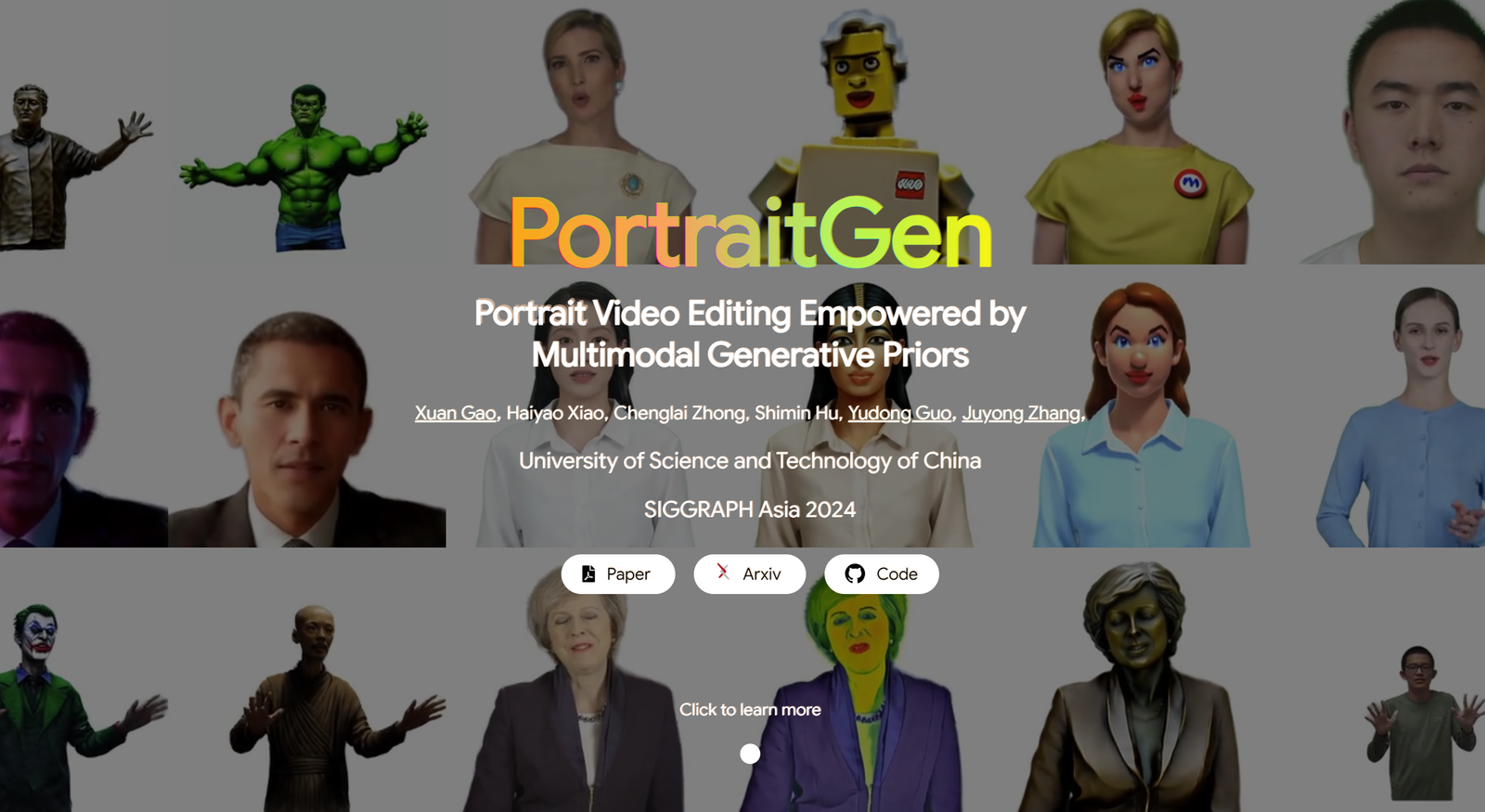

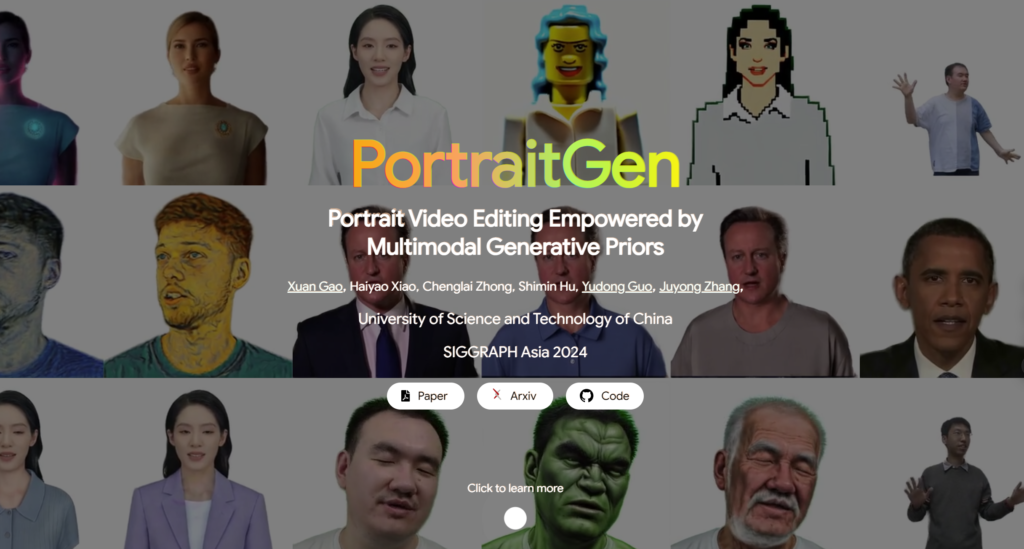

Tradisjonelle portrettvideoredigeringsmetoder har ofte problemer med 3D-effekter og tidsmessig konsistens, og fungerer også dårlig med tanke på gjengivelseskvalitet og effektivitet. For å løse disse problemene løfter PortraitGen hvert bilde av en portrettvideo til et enhetlig dynamisk 3D Gauss-felt, som sikrer strukturell og tidsmessig konsistens fra bilde til bilde. PortraitGen er en kraftig portrettvideoredigeringsmetode som gir konsistent og uttrykksfull stilisering med multimodale signaler.

I tillegg har PortraitGen utviklet en ny nevral Gaussisk tekstureringsmekanisme som ikke bare muliggjør kompleks stilistisk redigering, men også muliggjør gjengivelseshastigheter på over 100 bilder per sekund. PortraitGen kombinerer et bredt spekter av input som er forbedret av kunnskap destillert fra store 2D-generative modeller. Den introduserer også uttrykkslikhetsveiledning og en portrettredigeringsmodul for ansiktsgjenkjenning, som effektivt reduserer problemer som kan oppstå ved iterativ oppdatering av et datasett. (Link nederst i artikkelen)

01 Bildetekstinnhold

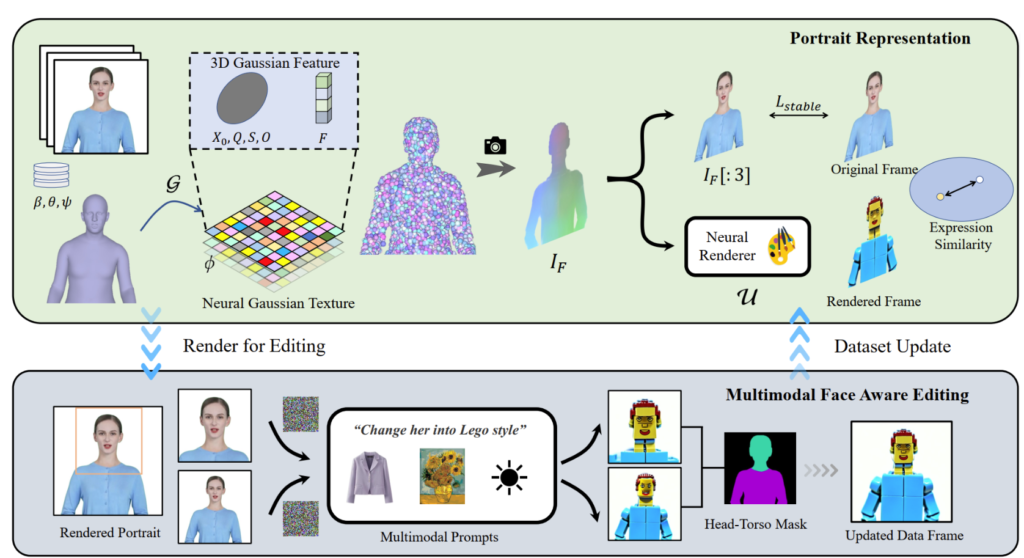

PortraitGen løfter 2D-portrettvideoer inn i et 4D Gaussisk felt for multimodal portrettredigering på bare 30 minutter. Det redigerte 3D-portrettet kan gjengis med 100 bilder per sekund. SMPL-X-koeffisientene i den monokulære videoen spores først, og deretter genereres et 3D Gaussisk funksjonsfelt ved å bruke en nevro-Gaussisk teksturmekanisme.

Disse nevro-gaussiske dataene behandles videre for å gjengi portrettbildet. PortraitGen bruker også en iterativ datasettoppdateringsstrategi for portrettredigering og foreslår en redigeringsmodul for ansiktsgjenkjenning for å forbedre kvaliteten på uttrykkene og bevare den personlige ansiktsstrukturen.

02 Praktisk bruk

PortraitGen-løsningen er et enhetlig rammeverk for portrettvideoredigering. Enhver bilderedigeringsmodell som bevarer struktur kan brukes til å komponere 3D-konsistente og tidsmessig sammenhengende portrettvideoer.

Tekstdrevet redigering: InstructPix2Pix brukes som en 2D-redigeringsmodell. Dens UNet krever tre innganger: et input RGB-bilde, en tekstkommando og en latent støy. Legger til noe støy til det gjengitte bildet og redigerer det basert på inndatakildebildet og instruksjonene.

Bildedrevet redigering: fokuserer på to typer redigering basert på bildesignaler. Den ene er å trekke ut den globale stilen til et referansebilde, og den andre er å tilpasse bildet ved å plassere objekter på bestemte steder. Disse metodene brukes eksperimentelt for stilmigrering og virtuell tilpasning. Stilen til referansebildet ble migrert til datasettrammene ved hjelp av Neural Style Migration-algoritmen og motivets klær ble endret med AnyDoor.

Relighting: bruk av IC-Light for å manipulere belysningen av videorammer. Gitt en tekstbeskrivelse som lysforhold, justerer PortraitGen-metoden harmonisk belysningen av portrettvideoen

03 Kontrast- og ablasjonseksperimenter

PortraitGen-metoden sammenlignes med toppmoderne videoredigeringsmetoder, inkludert TokenFlow, Rerender A Video, CoDeF og AnyV2V. PortraitGen-metoden overgår de andre metodene betydelig når det gjelder just-in-time bevaring, identitetsbevaring og tidsmessig konsistens.

Tiden varighet 00:47

Inspirert av den nevrale teksturen foreslått i 'Delayed Neural Rendering', foreslår PortraitGen en nevral Gaussisk tekstur. Denne tilnærmingen lagrer lærbare funksjoner for hver Gauss i stedet for å lagre sfæriske harmoniske koeffisienter. Deretter brukes en 2D nevral renderer til å konvertere de behandlede funksjonskartene til RGB-signaler. Denne metoden gir rikere informasjon enn de sfæriske harmoniske koeffisientene og muliggjør bedre sammensmelting av de behandlede funksjonene, noe som gjør det enklere å redigere komplekse stiler som Lego og pikselkunst.

Når du redigerer et overkroppsbilde, hvis ansiktet opptar et lite område, kan det hende at redigeringen av modellen ikke er godt tilpasset hodestillingen og ansiktsstrukturen. Facial Awareness Portrait Editing (FA) kan forbedre resultatene ved å utføre to redigeringer for å øke fokus på ansiktsstruktur.

Ved å kartlegge det gjengitte bildet og inngangskildebildet til EMOCAs latente uttrykksrom og optimalisere likheten mellom uttrykk, kan vi sikre at uttrykk forblir naturlige og konsistente med de originale videorammene.

Teknikken bak PortraitGen

Referanse

du kan finne mer om PotraitGen her :https://ustc3dv.github.io/PortraitGen/