I download di Tongyi Qianqian Qwen hanno superato i 40 milioni, "generando" più di 50.000 modelli per bambini.

Niente BS, testiamo prima Qwen qui:

Si è aperta la conferenza Yunqi "Spring Festival Gala" del cloud computing, il grande modello Tongyi Qwen ha fatto esplodere ancora una volta l'intera scena!

Wise Things ha riferito che il 19 settembre, ad Hangzhou, Ali Cloud ha lanciato il modello open source più potente al mondo, Qwen2.5-72B, con prestazioni "cross-measure" superiori a Llama3.1-405B, e si è quindi piazzato sul trono del modello open source globale di grandi dimensioni.

Di seguito è riportato un riepilogo dei risultati del lavoro svolto su questo progetto

Qwen2.5-72B supera Llama-405B in molti test autorevoli.

Contemporaneamente, è stata resa open source una vasta serie di modelli Qwen2.5, tra cui: il modello linguistico Qwen2.5, il modello linguistico visivo Qwen2-VL-72B, il modello di programmazione Qwen2.5-Coder e il modello matematico Qwen2.5-Math, ecc., con un totale cumulativo di oltre 100 modelli disponibili, alcuni dei quali hanno raggiunto le prestazioni del GPT-4o, stabilendo un nuovo record mondiale.

"È un giovedì pazzo", "prodotto epico" …… Nelle poche ore trascorse dalla sua uscita, Qwen2.5 ha scatenato una frenesia di discussioni sui social media in patria e all'estero, e sviluppatori da tutto il mondo si sono uniti al team di test di prova.

▲Qwen2.5 è un argomento caldo sui social media in patria e all'estero.

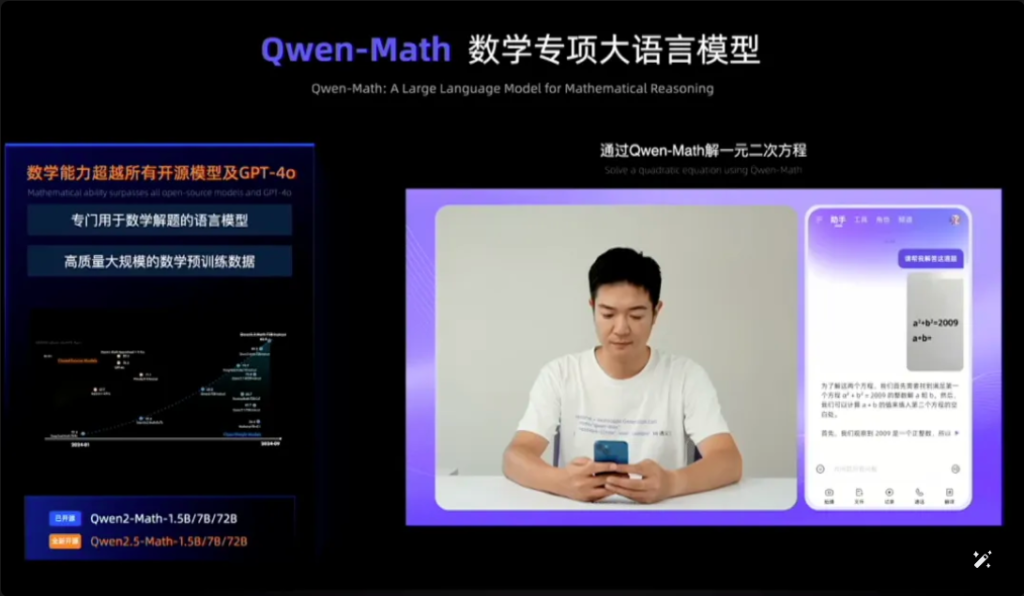

Qwen2.5-Math, ad esempio, combina il riconoscimento visivo con Qwen2.5-Math. Quando si inserisce uno screenshot di una domanda a scelta multipla geometricamente simile, Qwen2.5-Math riconosce rapidamente il significato della domanda e fornisce la soluzione corretta e la risposta "B", che è sia accurata che veloce. L'accuratezza e la velocità sono sorprendenti.

Questa è la prima volta che vedo Qwen2.5-Math sul web.

▲Qwen2.5-Prova matematica

In appena un anno e mezzo, da aprile 2023, Qwen è diventato un gruppo di modelle di fama mondiale, secondo solo a Llama.

Secondo gli ultimi dati pubblicati da Zhou Jingren, CTO di AliCloud, a metà settembre 2024 il numero cumulativo di download dei modelli open source di Tongyi Qwen ha superato i 40 milioni e sono stati derivati più di 50.000 modelli di grandi dimensioni.

▲La serie Qwen ha derivato modelli di grandi dimensioni oltre 50.000

Quali sono i miglioramenti specifici delle prestazioni di Qwen 2.5? Quali sono i punti salienti dei 100 nuovi modelli open source? Qwen2.5 è il primo del suo genere al mondo, ed è il primo del suo genere in Cina.

Indirizzo del blog: https://qwenlm.github.io/blog/qwen2.5/

Indirizzo del progetto: https://huggingface.co/spaces/Qwen/Qwen2.5

▲Il blog ufficiale pubblica i cluster modello Aliyun Qwen 2.5

01. Di nuovo in cima alla lista mondiale, Qwen2.5 cross-volume Recuperando Llama3.1-405B

Diamo un'occhiata specifica alle prestazioni di Qwen2.5.

Il modello Qwen2.5 supporta una lunghezza di contesto fino a 128K, può generare contenuti fino a 8K e supporta più di 29 lingue, il che significa che può aiutare gli utenti a scrivere articoli di 10.000 parole.

Non solo, sulla base del pre-addestramento dei dati del token 18T, Qwen2.5 ha un miglioramento complessivo delle prestazioni di oltre 18% rispetto a Qwen2, con maggiori conoscenze e competenze di programmazione e matematica più solide.

▲Zhou Jingren, CTO di AliCloud, spiega Qwen2.5

È stato segnalato che il modello di punta, il modello Qwen2.5-72B, ha ottenuto punteggi pari a 86,8, 88,2 e 83,1 nel benchmark MMLU-rudex (che esamina la conoscenza generale), nel benchmark MBPP (che esamina la capacità di programmazione) e nel benchmark MATH (che esamina la capacità matematica).

Qwen2.5, con i suoi 72 miliardi di parametri, supera addirittura Llama3.1-405B, con i suoi 405 miliardi di parametri, “di ordini di grandezza”.

Llama3.1-405B è stato rilasciato da Meta nel luglio 2024 e, in più di 150 set di test di benchmark, ha eguagliato o addirittura superato l'allora modello SOTA (il migliore del settore) GPT-4o, innescando l'affermazione che "il modello open source più forte è il modello più forte".

Qwen2.5-72B-Instruct, la versione successiva di Qwen2.5, ha superato Llama3.1-405B in MMLU-redux, MATH, MBPP, LiveCodeBench, Arena-Hard, AlignBench, MT-Bench, MultiPL-E e altre valutazioni autorevoli. 405B.

Immagini

▲Situazione di valutazione del modello Qwen2.5-72B

Qwen2.5 si conferma ancora una volta il modello open source più forte al mondo, contribuendo alla tendenza del settore "open source anziché closed source".

AliCloud segue la serie open source Tongyi Qianqian Qwen2 di giugno di quest'anno, raggiungendo il modello open source allora più potente, Llama3-70B, e lanciando poi una serie di versioni open source.

Nella comunità degli sviluppatori di intelligenza artificiale è ormai consuetudine che ogni nuovo re che appare venga presto superato da una nuova versione di Tongyi.

Dopo l'inaugurazione di Qwen2.5 la sera del 18 settembre, molti sviluppatori erano così entusiasti che non riuscirono a dormire e lo provarono per primi.

Non so se sarò in grado di farlo.

▲Gli sviluppatori nazionali e internazionali discutono animatamente di Qwen2.5

02.La più grande comunità di modellismo nella storia del mondo

La cosa più importante è avere una buona comprensione di cosa sta succedendo nel mondo e di come funziona.

La comunità di modellazione open source Qwen2.5 è la più grande di sempre.

Zhou Jingren, CTO di AliCloud, ha annunciato alla conferenza Yunqi che la serie Qwen2.5 conta più di 100 modelli open source disponibili, adattandosi perfettamente alle esigenze degli sviluppatori e delle PMI in vari scenari.

Ciò risponde alle richieste di molti sviluppatori, che da tempo “sollecitano” sui principali social media.

▲Gli sviluppatori nazionali e internazionali sollecitano più Qwen2.5

1, modello linguistico: da 0,5B a 72B sette dimensioni, da scenari end-side a scenari di livello industriale copertura completa

Qwen2.5 rende open source sette modelli linguistici di dimensioni diverse, tra cui 0.5B, 1.5B, 3B, 7B, 14B, 32B e 72B, tutti e sette i quali hanno ottenuto risultati SOTA nei rispettivi ambiti.

Immagini

▲Il Qwen2.5 multi-size soddisfa le esigenze di diversi scenari

Date le sue capacità avanzate nell'elaborazione del linguaggio naturale (NLP) e nella comprensione della codifica, Qwen2.5 di Alibaba Cloud è progettato per gestire un'ampia gamma di applicazioni. Ecco alcuni scenari specifici in cui Qwen2.5 può essere utilizzato:

- Servizio clienti migliorato: Qwen2.5 può essere utilizzato nei chatbot per interazioni più simili a quelle umane, rispondendo efficacemente alle domande dei clienti e fornendo soluzioni.

- Creazione di contenuti: Il modello può aiutare a generare articoli, post sui social media e altri contenuti scritti, facendo risparmiare tempo ai creatori di contenuti.

- Assistenza alla programmazione: Grazie alla serie specializzata Qwen2.5-Coder, può assistere gli sviluppatori suggerendo frammenti di codice, supporto per il debug e automatizzando determinate attività di codifica.

- Istruzione e apprendimento: Qwen2.5 può essere utilizzato per sviluppare strumenti didattici, come piattaforme di apprendimento interattive che forniscono spiegazioni, rispondono alle domande degli studenti e persino correggono i compiti.

- Servizi di traduzione: Grazie alla sua competenza in più lingue, può fornire servizi di traduzione in tempo reale per colmare il divario linguistico nella comunicazione internazionale.

- Ricerca e sviluppo: Nella ricerca, Qwen2.5 può elaborare grandi quantità di dati di testo per facilitare l'individuazione di modelli, la sintesi dei risultati e la generazione di report.

- Assistenza legale: Il modello è in grado di leggere documenti legali, estrarre informazioni rilevanti e persino redigere documenti legali di base, facendo risparmiare tempo ai professionisti del diritto.

- Supporto sanitario: Qwen2.5 può essere utilizzato per rispondere a domande comuni in materia di salute, fornire informazioni mediche e assistere nella gestione dei dati dei pazienti.

- Marketing e pubblicità: Può aiutare a creare contenuti di marketing personalizzati, testi pubblicitari e campagne sui social media che si rivolgono a un pubblico specifico.

- Analisi dei dati: Qwen2.5 è in grado di elaborare e analizzare grandi set di dati per fornire informazioni e aiutare a prendere decisioni basate sui dati.

- Segnalazione automatica: Il modello è in grado di generare report elaborando dati e informazioni in vari ambiti, il che risulta particolarmente utile nell'analisi finanziaria e aziendale.

- Sviluppo del gioco: Qwen2.5 può aiutare a creare dialoghi e narrazioni interattive per i personaggi dei videogiochi, migliorando il coinvolgimento dei giocatori.

- Assistente virtuale: Fornisce assistenti virtuali in grado di gestire programmi, impostare promemoria e fornire consigli personalizzati.

- Commercio elettronico: Qwen2.5 può aiutare a generare descrizioni di prodotti, gestire le richieste dei clienti e creare esperienze di acquisto personalizzate.

- Supporto multilingua: Può essere utilizzato in applicazioni globali che richiedono interazione multilingue, come il servizio clienti internazionale o la localizzazione dei contenuti.

Queste versioni aiutano gli sviluppatori a bilanciare la capacità e il costo del modello e ad adattarsi a una varietà di scenari. Ad esempio, 3B è la dimensione d'oro per adattarsi ai telefoni cellulari e ad altri dispositivi end-side, 32B è la più attesa dagli sviluppatori come "re del rapporto costo-efficacia" e 72B è il re delle prestazioni degli scenari di livello industriale e di livello di ricerca scientifica.

Indirizzo del blog: https://qwenlm.github.io/zh/blog/qwen2.5-llm/

2、Modello multimodale: il modello visivo comprende 20 minuti di video, il modello audio-lingue supporta 8 lingue

Qwen2-VL-72B, l'attesissimo modello di linguaggio visivo su larga scala, è oggi ufficialmente open source.

Qwen2-VL è in grado di riconoscere immagini con diverse risoluzioni e proporzioni, comprendere video lunghi più di 20 minuti, è in grado di regolare l'intelligenza visiva di telefoni cellulari e dispositivi e superare il livello di comprensione visiva GPT-4o.

▲Modello di linguaggio visivo su larga scala Qwen2-VL-72B open source

Qwen2-VL-72B è diventato il modello di comprensione visiva open source con il punteggio più alto nella classifica autorevole di valutazione globale LMSYS Chatbot Arena Leaderboard.

Qwen2-VL-72B è il modello di comprensione visiva open source con il punteggio più alto.

Il modello linguistico audio su larga scala Qwen2-Audio è un modello open source in grado di comprendere la voce umana, la musica e i suoni naturali, supportare la chat vocale, l'analisi dei messaggi audio e supportare più di 8 lingue e dialetti, ed è leader mondiale nell'indice di valutazione mainstream.

Indirizzo del blog: http://qwenlm.github.io/blog/qwen2-vl/

3, modello speciale: il debutto del modello matematico open source più avanzato, che raggiunge GPT-4o

In occasione della Cloud Habitat Conference sono stati annunciati anche Qwen2.5-Coder per la programmazione e Qwen2.5-Math per la matematica, che saranno open source.

Tra questi, Qwen2.5-Math è la serie di modelli matematici open source più avanzata fino ad oggi, questa volta open source 1.5B, 7B, 72B, tre dimensioni e modello di ricompensa matematica Qwen2.5-Math-RM.

▲Qwen2.5-Matematica open source

Il modello di punta Qwen2-Math-72B-Instruct supera i modelli proprietari come GPT-4o e Claude 3.5 nelle attività downstream correlate alla matematica.

Qwen2.5-Coder, che è stato addestrato su un massimo di 5,5 T token di dati correlati alla programmazione, è stato reso open source lo stesso giorno nelle versioni 1.5B e 7B e sarà reso open source in futuro nella versione 32B.

▲Qwen2.5-Codificatore open source

Indirizzo del blog:

https://qwenlm.github.io/zh/blog/qwen2.5-math/

https://qwenlm.github.io/zh/blog/qwen2.5-coder/

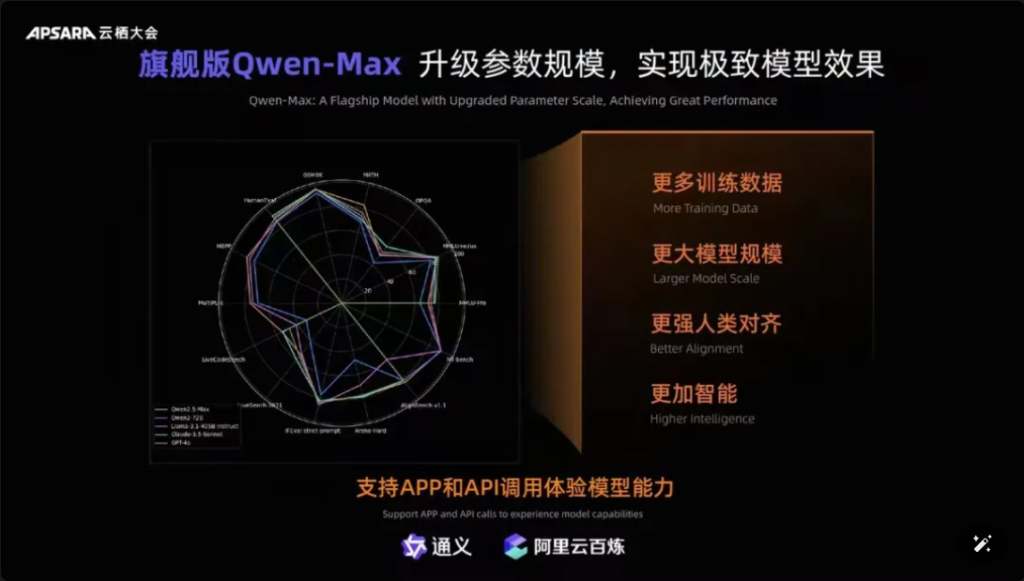

Inoltre, vale la pena menzionare che Qwen-Max, il modello di punta di Tongyiqianqian, è stato completamente aggiornato, avvicinandosi o addirittura superando GPT-4o su più di dieci benchmark autorevoli, come MMLU-Pro, MATH, ecc., ed è online sul sito Web ufficiale di Tongyiqianqian e Tongyi APP. Gli utenti possono anche chiamare le API di Qwen-Max tramite la piattaforma AliCloud Hundred Refinement.

Immagini

▲Qwen-Max realizza un aggiornamento completo

Dall'uscita della prima generazione del modello grande Tongyi Qianqian nell'aprile 2023, AliCloud ha consentito alle aziende cinesi di utilizzare il modello grande a basso costo, il che a sua volta ha reso l'attuale serie Qwen2.5 "sempre più utile".

I modelli della serie Qwen2.5 comprendono la versione base, la versione basata sui comandi e la versione quantitativa, che viene riproposta in scenari reali.

03. I download di Qwen hanno superato i 40 milioni! Sono nati più di 50.000 "bambini".

Dopo un anno e mezzo di rapido sviluppo, Tongyi Qwen è diventato un gruppo di modelle di fama mondiale, secondo solo a Llama.

Zhou Jingren ha annunciato due serie di dati più recenti per confermarlo:

In primo luogo, il numero di download dei modelli: all'inizio di settembre 2024, i download cumulativi dei modelli open source di Tongyi Qianwen hanno superato i 40 milioni, il che è dovuto al fatto che sviluppatori e PMI hanno votato con i piedi;

Il secondo è il numero di modelli derivati: all'inizio di settembre, il numero totale di modelli nativi e derivati di Tongyi superava i 50.000, secondo solo a Llama.

▲I download cumulativi del modello open source Tongyi Thousand Questions hanno superato i 40 milioni

Finora, la tendenza dei "10.000 modelli con la stessa fonte" è diventata una tendenza significativa nello sviluppo dell'industria cinese dei grandi modelli.

Qual è il concetto? L'open source cinese non solo è al primo posto al mondo in termini di prestazioni, ma anche in termini di espansione ecologica. Le comunità open source, i partner ecologici e gli sviluppatori in patria e all'estero sono diventati "l'acqua del rubinetto" di Tongyi Chienqin, che è diventato il primo grande modello adottato da molte aziende e anche il grande modello più a lungo utilizzato.

Già nell'agosto 2023, Aliyun ha reso open source il modello da 7 miliardi di parametri di Tongyi Qwen per la commercializzazione gratuita, e poi quest'anno sono stati rilasciati uno dopo l'altro Qwen1.5, Qwen2 e Qwen2.5, in modo che gli sviluppatori possano utilizzare rapidamente il modello più avanzato contemporaneamente, per ottenere maggiore controllo e spazio di ottimizzazione, diventando così la scelta preferita di più aziende.

All'inizio di luglio, gli ingegneri di Hugging Face, la più grande comunità open source al mondo, avevano twittato per certificare che Tongyi è il modello più grande e più popolare in Cina. E tramite AliCloud, Tongyi Big Model ha servito più di 300.000 clienti in vari settori. Nel secondo trimestre del 2024 appena trascorso (corrispondente al primo trimestre dell'anno fiscale 2025 di Alibaba), i ricavi dei prodotti correlati all'intelligenza artificiale di Aliyun hanno registrato una crescita a tre cifre.

▲Tongyi Big Model serve più di 300.000 clienti

Cosa ha fatto di giusto Aliyun?

A mio parere, a differenza dei grandi produttori stranieri Microsoft e ChatGPT, che hanno un forte legame con la convergenza del modello a tre parti di Amazon AWS per realizzare l'infrastruttura di base, Aliyun ha integrato i vantaggi dei due e, all'inizio, ha scelto di gestire i servizi infrastrutturali di intelligenza artificiale e di auto-ricercarli in modo bidirezionale.

Concentrandosi sui modelli di auto-ricerca, Ali Cloud è l'unico colosso del cloud in Cina che ha ben chiaro in mente il modello open source e l'apertura, e non ha risparmiato sforzi per investire ingenti somme in innovazioni nei modelli, compatibilità ecologica, servizi per sviluppatori, ecc., così da far entrare, passo dopo passo, i grandi modelli di Tongyi nel novero principale della competizione mondiale in materia di intelligenza artificiale.

04.Conclusione: tutti i modelli hanno la stessa origine Industry Watershed Moment

I modelli open source stanno recuperando o addirittura recuperando terreno rispetto ai modelli closed source. Dal Llama-405B di Meta a luglio al Qwen2.5-72B di AliCloud di oggi, il panorama di "tutti i modelli dalla stessa fonte" sta prendendo forma. L'impennata di un anno e mezzo del modello di grandi dimensioni Tongyi Qianqi ha permesso a molti settori e aziende di realizzare un atterraggio su scala AI a costi inferiori e il settore sta entrando in un nuovo momento spartiacque.

Domande frequenti

- D: Quali sono le diverse dimensioni del modello Qwen2.5 disponibili? R: Qwen2.5 offre una gamma di modelli con parametri da 0,5B a 72B, offrendo opzioni per varie applicazioni e requisiti.

- D: In che modo Qwen2.5 supporta le attività di programmazione? R: Qwen2.5 include una serie specializzata chiamata Qwen2.5-Coder, progettata per migliorare la generazione, l'inferenza e il debug del codice, con supporto per token fino a 128K.

- D: Quali sono i dati di allenamento per Qwen2.5? R: Qwen2.5 è pre-addestrato su un vasto set di dati che copre fino a 18 trilioni di token, garantendo un'ampia comprensione del linguaggio.

- D: Qwen2.5 è adatto all'uso in ambito educativo? R: Sì, le capacità di Qwen2.5 nell'elaborazione del linguaggio naturale lo rendono adatto agli strumenti didattici, comprese le piattaforme di apprendimento interattive.

- D: Come si comporta Qwen2.5 nei benchmark rispetto ad altri modelli? R: Qwen2.5 si classifica attualmente al terzo posto nei benchmark multimodali, superando modelli come Llama3.1 in diversi ambiti.

- D: Quali lingue supporta Qwen2.5? R: Qwen2.5 supporta più linguaggi, tra cui Python, Java e C++.

- D: Qwen2.5 può generare codice in più linguaggi di programmazione? R: Sì, Qwen2.5-Coder è in grado di generare codice in vari linguaggi di programmazione, soddisfacendo le esigenze di diversi sviluppatori.

- D: Come gestisce Qwen2.5 i contesti lunghi? R: Qwen2.5 supporta lunghezze di contesto fino a 32K, il che è utile per migliorare l'accuratezza del completamento del codice e dell'inferenza.

- D: Qwen2.5 è open source? R: Sebbene la versione open source di Qwen2.5 non sia ancora stata rilasciata, documentazione dettagliata ed esempi sono disponibili su piattaforme come GitHub.

- D: Quali sono alcuni scenari applicativi concreti per Qwen2.5? R: Qwen2.5 può essere utilizzato nei chatbot per il servizio clienti, nella creazione di contenuti, nell'assistenza alla programmazione, nell'istruzione, nei servizi di traduzione, nell'assistenza legale, nel supporto sanitario, nel marketing, nell'analisi dei dati, nella reportistica automatizzata, nello sviluppo di giochi, negli assistenti virtuali, nell'e-commerce e nel supporto multilingue in vari settori.