Les téléchargements de Tongyi Qianqian Qwen ont dépassé les 40 millions, "engendrant" plus de 50 000 enfants Modèles.

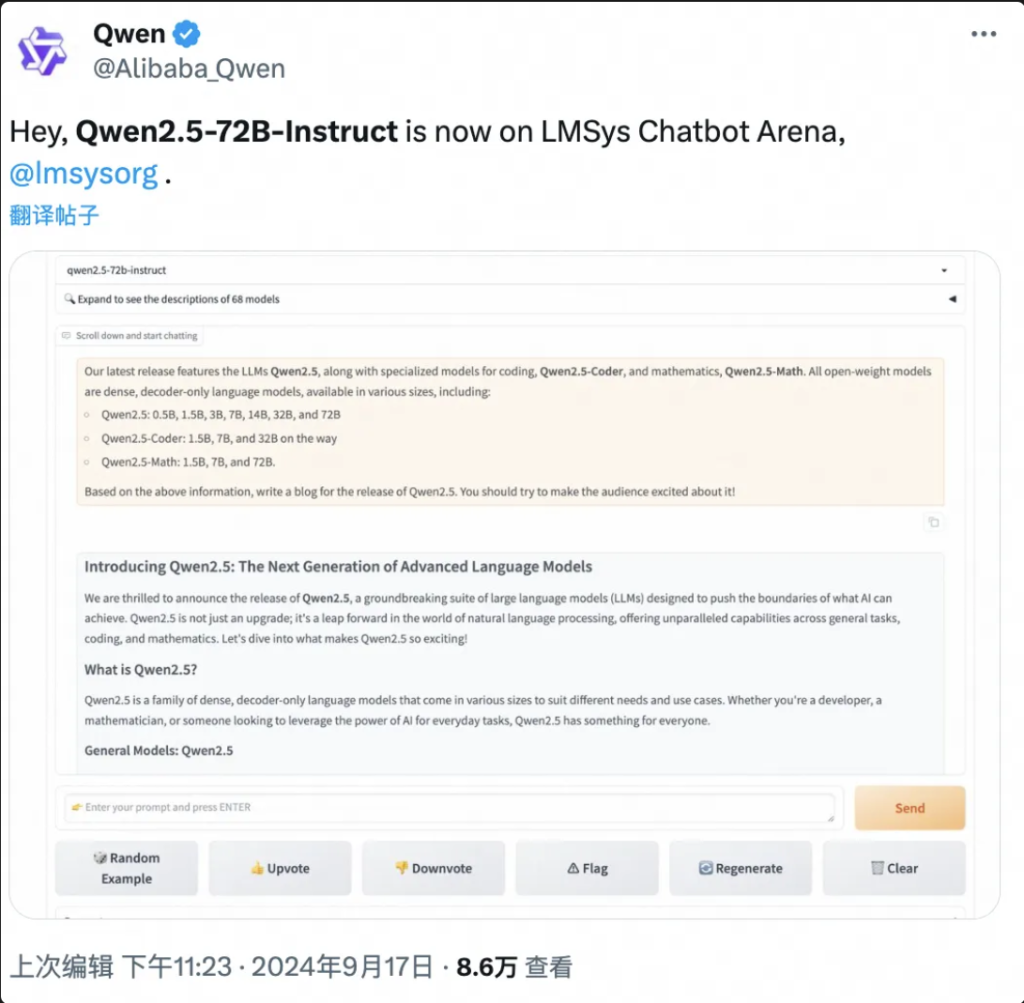

No BS let first test Qwen here:

La conférence de Yunqi sur l'informatique en nuage "Spring Festival Gala" s'est ouverte, et le grand modèle de Tongyi Qwen a une fois de plus fait exploser toute la scène !

Le 19 septembre, à Hangzhou, Ali Cloud a lancé le plus grand modèle open source du monde, Qwen2.5-72B, dont les performances dépassent celles de Llama3.1-405B, et qui est devenu le plus grand modèle open source du monde.

Voici un résumé des résultats des travaux sur ce projet

Qwen2.5-72B surpasse Llama-405B dans de nombreux tests faisant autorité.

Dans le même temps, une grande série de modèles Qwen2.5 ont été mis en libre accès, notamment le modèle de langage Qwen2.5, le modèle de langage visuel Qwen2-VL-72B, le modèle de programmation Qwen2.5-Coder et le modèle mathématique Qwen2.5-Math, etc., avec un total cumulé de plus de 100 sur les étagères, et certains d'entre eux rattrapant les performances du GPT-4o pour établir un nouveau record mondial.

Jeudi fou", "produit épique" ...... Quelques heures après sa sortie, Qwen2.5 a déclenché une frénésie de discussions sur les médias sociaux en Allemagne et à l'étranger, et des développeurs du monde entier ont rejoint l'équipe chargée des tests d'essai.

▲Qwen2.5 est un sujet brûlant sur les médias sociaux, au pays comme à l'étranger.

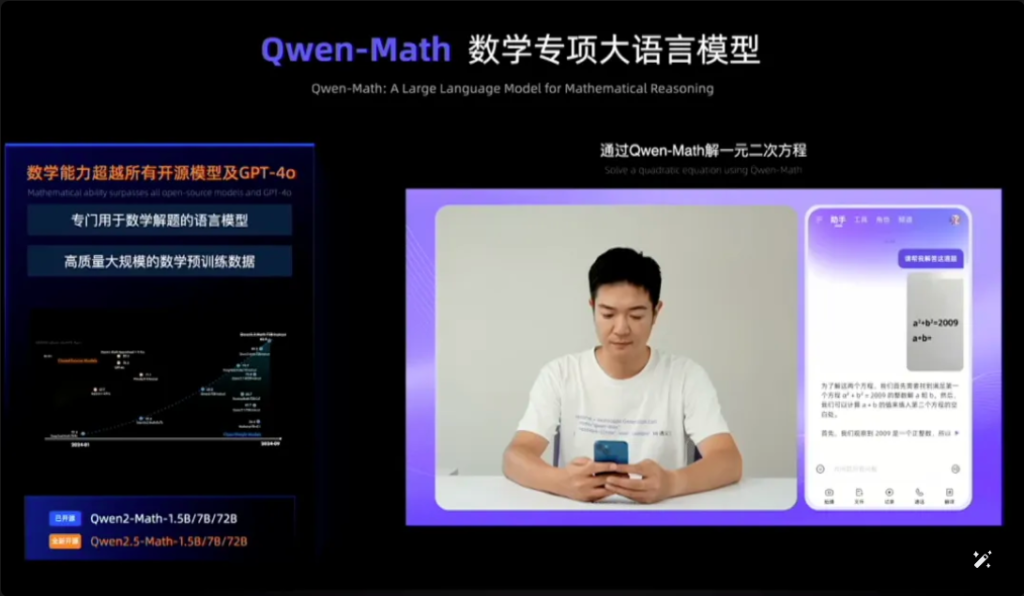

Qwen2.5-Math, par exemple, associe la reconnaissance visuelle à Qwen2.5-Math. Lors de la saisie d'une capture d'écran d'une question à choix multiples géométriquement similaire, Qwen2.5-Math reconnaît rapidement le sens de la question et donne la solution correcte et la réponse "B", ce qui est à la fois précis et rapide. La précision et la rapidité sont étonnantes.

C'est la première fois que je vois Qwen2.5-Math sur le web.

▲Qwen2.5-Essai mathématique

En seulement un an et demi, depuis avril 2023, Qwen est devenu un groupe de mannequins de classe mondiale, qui n'a d'égal que Llama.

Selon les dernières données publiées par Zhou Jingren, directeur technique d'AliCloud, à la mi-septembre 2024, le nombre cumulé de téléchargements de modèles open source de Tongyi Qwen a dépassé les 40 millions, et plus de 50 000 grands modèles ont été dérivés.

▲Qwen series derived large models over 50,000

Quelles sont les améliorations spécifiques de Qwen 2.5 en termes de performances ? Quels sont les points forts des 100 nouveaux modèles open source ? Le Qwen 2.5 est le premier de son genre au monde, et le premier de son genre en Chine.

Adresse du blog : https://qwenlm.github.io/blog/qwen2.5/

Adresse du projet : https://huggingface.co/spaces/Qwen/Qwen2.5

▲Le blog officiel publie les grappes modèles Aliyun Qwen 2.5

01. en tête de la liste mondiale, Qwen2.5 cross-volume Catching up with Llama3.1-405B

Examinons les performances de Qwen2.5 en particulier.

Le modèle Qwen2.5 prend en charge jusqu'à 128K de longueur de contexte, peut générer jusqu'à 8K de contenu et prend en charge plus de 29 langues, ce qui signifie qu'il peut aider les utilisateurs à rédiger des articles de 10 000 mots.

De plus, sur la base d'un pré-entraînement de 18 tonnes de données de jetons, Qwen2.5 a amélioré ses performances globales de plus de 18% par rapport à Qwen2, avec plus de connaissances et des compétences plus solides en programmation et en mathématiques.

▲AliCloud CTO Zhou Jingren explique Qwen2.5

Le modèle phare, le modèle Qwen2.5-72B, a obtenu des scores de 86,8, 88,2 et 83,1 au test MMLU-rudex (qui évalue les connaissances générales), au test MBPP (qui évalue la capacité de codage) et au test MATH (qui évalue la capacité mathématique).

Qwen2.5, avec ses 72 milliards de paramètres, surpasse même Llama3.1-405B, avec ses 405 milliards de paramètres, "de plusieurs ordres de grandeur".

Llama3.1-405B a été publié par Meta en juillet 2024 et, dans plus de 150 séries de tests de référence, il a égalé ou même dépassé le modèle GPT-4o, alors SOTA (le meilleur de l'industrie), ce qui a déclenché l'affirmation selon laquelle "le modèle open-source le plus puissant est le modèle le plus puissant".

Qwen2.5-72B-Instruct, la version suivante de Qwen2.5, a surpassé Llama3.1-405B dans MMLU-redux, MATH, MBPP, LiveCodeBench, Arena-Hard, AlignBench, MT-Bench, MultiPL-E et d'autres évaluations faisant autorité. 405B.

Photos

▲Qwen2.5-72B modèle d'évaluation de la situation

Qwen2.5 est une fois de plus le modèle open source le plus puissant au monde, contribuant à la tendance du secteur "open source over closed source".

AliCloud a suivi la série Tongyi Qianqian Qwen2 en juin de cette année, rattrapant le modèle open source le plus puissant à l'époque, Llama3-70B, et lançant ensuite une série de versions open source.

La communauté des développeurs d'IA a pris l'habitude de constater que chaque nouveau roi qui apparaît est rapidement dépassé par une nouvelle version de Tongyi.

Après l'ouverture de Qwen2.5 dans la soirée du 18 septembre, de nombreux développeurs étaient si enthousiastes qu'ils n'ont pas dormi et l'ont essayé en premier.

Je ne suis pas sûr de pouvoir le faire.

▲Les développeurs nationaux et étrangers discutent vivement de Qwen2.5

02 La plus grande communauté de mannequins de l'histoire du monde

Le plus important est de bien comprendre ce qui se passe dans le monde et comment il fonctionne.

La communauté de modélisation open source Qwen2.5 n'a jamais été aussi importante.

Zhou Jingren, directeur technique d'AliCloud, a annoncé lors de la conférence Yunqi que la série Qwen2.5 comptait au total plus de 100 modèles open source sur les étagères, s'adaptant ainsi parfaitement aux besoins des développeurs et des PME dans différents scénarios.

Cela répond aux appels de nombreux développeurs, qui ont longtemps insisté dans les principaux médias sociaux.

▲Les développeurs nationaux et étrangers demandent plus de Qwen2.5

1, modèle de langue : de 0,5B à 72B sept tailles, de l'utilisateur final aux scénarios de qualité industrielle couverture complète

Qwen2.5 propose sept modèles linguistiques de taille, dont 0,5B, 1,5B, 3B, 7B, 14B, 32B et 72B, qui ont tous obtenu des résultats SOTA dans les pistes correspondantes.

Photos

▲Multi-size Qwen2.5 répond aux besoins de divers scénarios

Grâce à ses capacités avancées de traitement du langage naturel (NLP) et de compréhension du codage, Qwen2.5 d'Alibaba Cloud est conçu pour gérer un large éventail d'applications. Voici quelques scénarios spécifiques dans lesquels Qwen2.5 peut être utilisé :

- Amélioration du service à la clientèle : Qwen2.5 peut être utilisé dans les chatbots pour des interactions plus humaines, en répondant efficacement aux questions des clients et en leur fournissant des solutions.

- Création de contenu : Le modèle peut aider à générer des articles, des posts sur les médias sociaux et d'autres contenus écrits, ce qui permet aux créateurs de contenu de gagner du temps.

- Aide à la programmation : Avec sa série spécialisée Qwen2.5-Coder, il peut aider les développeurs en leur suggérant des extraits de code, en les aidant à déboguer et en automatisant certaines tâches de codage.

- Éducation et apprentissage : Qwen2.5 peut être utilisé pour développer des outils éducatifs tels que des plateformes d'apprentissage interactives qui fournissent des explications, répondent aux questions des étudiants et notent même les devoirs.

- Services de traduction : Grâce à sa maîtrise de plusieurs langues, elle peut fournir des services de traduction en temps réel pour combler le fossé linguistique dans la communication internationale.

- Recherche et développement : Dans le domaine de la recherche, Qwen2.5 peut traiter de grandes quantités de données textuelles pour aider à découvrir des modèles, à résumer les résultats et à produire des rapports.

- Assistance juridique : Le modèle peut lire des documents juridiques, extraire des informations pertinentes et même rédiger des documents juridiques de base, ce qui permet aux professionnels du droit de gagner du temps.

- Soutien aux soins de santé : Qwen2.5 peut être utilisé pour répondre à des questions de santé courantes, fournir des informations médicales et aider à gérer les données des patients.

- Marketing et publicité : Il permet de créer des contenus marketing personnalisés, des textes publicitaires et des campagnes de médias sociaux qui ciblent des publics spécifiques.

- Analyse des données : Qwen2.5 peut traiter et analyser de grands ensembles de données pour fournir des informations et aider à prendre des décisions fondées sur des données.

- Rapports automatisés : Le modèle peut générer des rapports en traitant des données et des informations dans divers domaines, ce qui est particulièrement utile pour l'analyse financière et commerciale.

- Développement de jeux : Qwen2.5 peut aider à créer des dialogues et des récits interactifs pour les personnages de jeux vidéo afin d'améliorer l'engagement des joueurs.

- Assistant virtuel : Il pilote des assistants virtuels capables de gérer des emplois du temps, de fixer des rappels et de fournir des conseils personnalisés.

- Commerce électronique : Qwen2.5 peut aider à générer des descriptions de produits, à traiter les demandes des clients et à créer des expériences d'achat personnalisées.

- Prise en charge multilingue : Il peut être utilisé dans des applications globales nécessitant une interaction multilingue, telles que le service clientèle international ou la localisation de contenu.

Ces versions aident les développeurs à équilibrer la capacité et le coût du modèle, et à s'adapter à une variété de scénarios. Par exemple, 3B est la taille idéale pour s'adapter aux téléphones cellulaires et autres appareils terminaux, 32B est la taille la plus attendue par les développeurs pour être le "roi de la rentabilité", et 72B est le roi de la performance des scénarios de qualité industrielle et de recherche scientifique.

Adresse du blog : https://qwenlm.github.io/zh/blog/qwen2.5-llm/

2、Modalité : le modèle visuel comprend 20 minutes de vidéo, le modèle audio-linguistique prend en charge 8 langues.

Qwen2-VL-72B, le modèle de langage visuel à grande échelle très attendu, est officiellement mis à disposition aujourd'hui.

Qwen2-VL peut reconnaître des images de différentes résolutions et de différents formats, comprendre des vidéos de plus de 20 minutes, réguler l'intelligence visuelle des téléphones portables et des appareils, et dépasser le niveau de compréhension visuelle GPT-4o.

▲Modèle visuel de langage à grande échelle Qwen2-VL-72B open source

Qwen2-VL-72B est devenu le modèle de compréhension visuelle open source ayant obtenu le meilleur score dans l'évaluation mondiale faisant autorité LMSYS Chatbot Arena Leaderboard.

Qwen2-VL-72B est le modèle de compréhension visuelle open source le plus performant.

Le modèle de langage audio à grande échelle Qwen2-Audio est un modèle open source capable de comprendre la voix humaine, la musique et les sons naturels, de prendre en charge le chat vocal et l'analyse des messages audio, de prendre en charge plus de 8 langues et dialectes, et d'être un leader mondial dans l'indice d'évaluation du grand public.

Adresse du blog : http://qwenlm.github.io/blog/qwen2-vl/

3, modèle spécial : le modèle mathématique open source le plus avancé fait ses débuts, rattrapant ainsi le GPT-4o

Qwen2.5-Coder pour la programmation et Qwen2.5-Math pour les mathématiques ont également été annoncés en tant qu'open source lors de la conférence Cloud Habitat.

Parmi eux, Qwen2.5-Math est la série de modèles mathématiques open source la plus avancée à ce jour, cette fois-ci open source 1.5B, 7B, 72B trois tailles et modèle de récompense mathématique Qwen2.5-Math-RM.

▲Qwen2.5-Math open source

Le modèle phare Qwen2-Math-72B-Instruct surpasse les modèles propriétaires tels que GPT-4o et Claude 3.5 dans les tâches en aval liées aux mathématiques.

Qwen2.5-Coder, qui a été entraîné sur un maximum de 5,5 tonnes de données liées à la programmation, a été mis en libre accès le même jour dans les versions 1.5B et 7B, et sera mis en libre accès à l'avenir dans la version 32B.

▲Qwen2.5-Coder open source

Adresse du blog :

https://qwenlm.github.io/zh/blog/qwen2.5-math/

https://qwenlm.github.io/zh/blog/qwen2.5-coder/

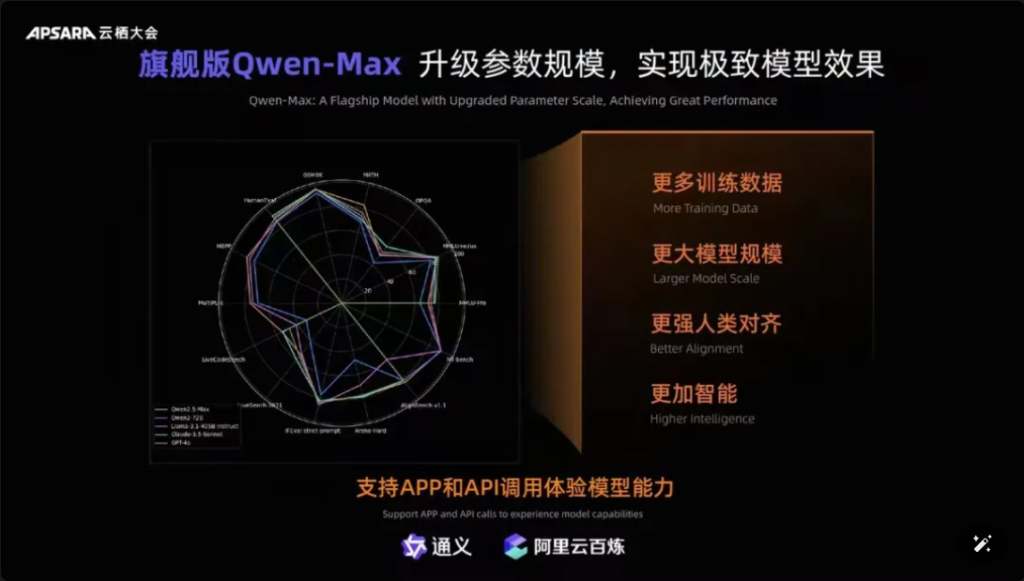

En outre, il convient de mentionner que Qwen-Max, le modèle phare de Tongyiqianqian, a été entièrement mis à niveau, approchant ou même dépassant GPT-4o sur plus de dix critères de référence, tels que MMLU-Pro, MATH, etc. Les utilisateurs peuvent également appeler les API de Qwen-Max via la plate-forme AliCloud Hundred Refinement.

Photos

▲Qwen-Max réalise une mise à niveau complète

Depuis le lancement de la première génération du grand modèle Tongyi Qianqian en avril 2023, AliCloud a permis aux entreprises chinoises d'utiliser le grand modèle à faible coût, ce qui a conduit la série Qwen2.5 d'aujourd'hui à être "de plus en plus utile".

Les modèles de la série Qwen2.5 couvrent la version de base, la version de suivi des commandes, la version quantitative, qui est itérée dans des scénarios du monde réel.

03.Qwen a dépassé les 40 millions de téléchargements ! Plus de 50 000 "bébés" sont nés.

Après un an et demi de développement rapide, Tongyi Qwen est devenu un groupe modèle de classe mondiale, après Llama.

Zhou Jingren a annoncé deux séries de données récentes qui le confirment :

Premièrement, le nombre de téléchargements de modèles, au début du mois de septembre 2024, les téléchargements cumulés des modèles open source de Tongyi Qianwen ont dépassé les 40 millions, ce qui est le résultat du vote des développeurs et des PME ;

Le deuxième est le nombre de modèles dérivés. Début septembre, le nombre total de modèles natifs et dérivés de Tongyi dépassait les 50 000, juste derrière Llama.

▲Tongyi Thousand Questions open source model cumulative downloads exceeded 40 million

Jusqu'à présent, les "10 000 modèles ayant la même source" sont devenus une tendance importante dans le développement de l'industrie chinoise des grands modèles.

Quel est le concept ? Le logiciel libre chinois n'est pas seulement le premier au monde en termes de performance, mais aussi en termes d'expansion écologique. Les communautés open source, les partenaires écologiques et les développeurs nationaux et étrangers sont devenus "l'eau du robinet" de Tongyi Chienqin, qui est devenu le premier grand modèle adopté par de nombreuses entreprises, et aussi le plus anciennement utilisé.

Dès le mois d'août 2023, Aliyun a mis en open-source le modèle de 7 milliards de paramètres de Tongyi Qwen pour une commercialisation libre, puis cette année Qwen1.5, Qwen2, Qwen2.5 ont été publiés l'un après l'autre, de sorte que les développeurs peuvent rapidement utiliser le modèle le plus avancé en même temps, pour obtenir un plus grand contrôle et un plus grand espace de réglage, devenant ainsi le choix préféré d'un plus grand nombre d'entreprises.

Au début du mois de juillet, des ingénieurs de Hugging Face, la plus grande communauté open source du monde, ont tweeté pour certifier que Tongyi est le grand modèle le plus développé en Chine. Grâce à AliCloud, Tongyi Big Model a servi plus de 300 000 clients dans divers secteurs. Au cours du deuxième trimestre 2024 (correspondant au premier trimestre de l'exercice 2025 d'Alibaba), les revenus des produits liés à l'IA d'Aliyun ont connu une croissance à trois chiffres.

▲Tongyi Big Model sert plus de 300 000 clients

Qu'est-ce qu'Aliyun a fait de bien ?

À mon avis, contrairement aux grands fabricants étrangers, Microsoft et ChatGPT, qui se lient fortement, et Amazon AWS, qui converge vers un modèle tripartite pour s'occuper de l'infrastructure sous-jacente, Aliyun a intégré les avantages des deux, dès le départ, et a choisi d'offrir des services d'infrastructure d'IA et de faire de la recherche autonome sur un grand modèle, à deux mains.

En se concentrant sur les modèles d'auto-recherche, Ali Cloud est le seul géant du cloud en Chine à être fermement convaincu de l'ouverture des modèles et des sources ouvertes, et n'a pas ménagé ses efforts pour investir massivement dans les percées des modèles, la compatibilité écologique, les services aux développeurs, etc.

04.Conclusion : Tous les modèles ont la même origine Industry Watershed Moment

Les modèles open source rattrapent ou même rattrapent les modèles à source fermée. De Llama-405B de Meta en juillet à Qwen2.5-72B d'AliCloud aujourd'hui, le paysage de "tous les modèles provenant de la même source" prend forme. L'essor du grand modèle Tongyi Qianqi, qui dure depuis un an et demi, a permis à de nombreuses industries et entreprises de réaliser un atterrissage à l'échelle de l'IA à moindre coût, et le secteur entre dans un nouveau moment décisif.

FAQS

- Q : Quelles sont les différentes tailles de modèles disponibles pour Qwen2.5 ? R : Qwen2.5 propose une gamme de modèles allant des paramètres 0,5B à 72B, offrant des options pour diverses applications et exigences.

- Q : Comment Qwen2.5 prend-il en charge les tâches de programmation ? R : Qwen2.5 comprend une série spécialisée appelée Qwen2.5-Coder, conçue pour améliorer la génération de code, l'inférence et le débogage, avec une prise en charge de 128 000 jetons.

- Q : À quoi ressemblent les données d'entraînement pour Qwen2.5 ? R : Qwen2.5 est pré-entraîné sur un vaste ensemble de données couvrant jusqu'à 18 billions de tokens, ce qui garantit une large compréhension de la langue.

- Q : Qwen2.5 peut-il être utilisé dans l'enseignement ? R : Oui, les capacités de Qwen2.5 en matière de traitement du langage naturel le rendent adapté aux outils éducatifs, y compris les plateformes d'apprentissage interactives.

- Q : Quelles sont les performances de Qwen2.5 par rapport à d'autres modèles ? R : Qwen2.5 occupe actuellement la troisième place dans les benchmarks multimodaux, surpassant des modèles tels que Llama3.1 dans plusieurs domaines.

- Q : Quelles sont les langues prises en charge par Qwen2.5 ? R : Qwen2.5 prend en charge plusieurs langages, y compris, mais sans s'y limiter, Python, Java et C++.

- Q : Qwen2.5 peut-il générer du code dans plusieurs langages de programmation ? R : Oui, Qwen2.5-Coder est capable de générer du code dans différents langages de programmation, répondant ainsi aux besoins de différents développeurs.

- Q : Comment Qwen2.5 gère-t-il les contextes longs ? R : Qwen2.5 prend en charge des longueurs de contexte allant jusqu'à 32K, ce qui permet d'améliorer la précision de la complétion et de l'inférence du code.

- Q : Qwen2.5 est-il open source ? R : Bien que la version open source de Qwen2.5 n'ait pas encore été publiée, une documentation détaillée et des exemples sont disponibles sur des plateformes telles que GitHub.

- Q : Quels sont les scénarios d'application de Qwen2.5 dans le monde réel ? R : Qwen2.5 peut être utilisé dans les chatbots du service client, la création de contenu, l'assistance à la programmation, l'éducation, les services de traduction, l'assistance juridique, l'assistance médicale, le marketing, l'analyse de données, les rapports automatisés, le développement de jeux, les assistants virtuels, le commerce électronique et l'assistance multilingue dans divers secteurs d'activité.