Las descargas de Tongyi Qianqian Qwen superaron los 40 millones, "engendrando" más de 50.000 niños Modelos.

No BS dejar primero probar Qwen aquí:

Inaugurada la Conferencia Yunqi de la "Gala del Festival de Primavera" de computación en nube, ¡el gran modelo Tongyi Qwen volvió a hacer estallar toda la escena!

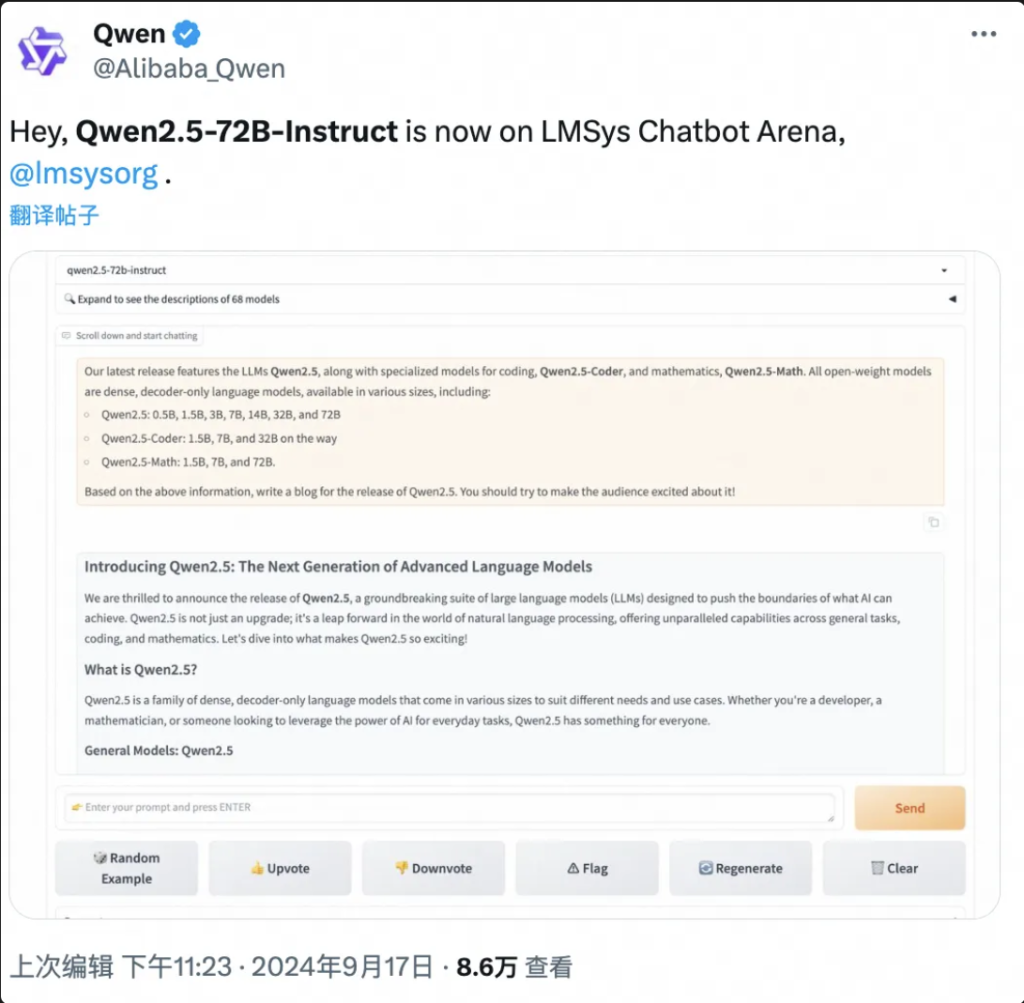

Cosas sabias informó el 19 de septiembre, Hangzhou, hoy en día, Ali Cloud lanzó el más fuerte del mundo de código abierto gran modelo Qwen2.5-72B, el rendimiento "medida cruzada" más allá de Llama3.1-405B, y luego en el trono del mundo de código abierto gran modelo.

A continuación se resumen los resultados de los trabajos de este proyecto

Qwen2.5-72B supera a Llama-405B en muchas pruebas acreditadas.

Al mismo tiempo, una gran serie de modelos Qwen2.5 se hicieron de código abierto, incluyendo: el modelo de lenguaje Qwen2.5, el modelo de lenguaje visual Qwen2-VL-72B, el modelo de programación Qwen2.5-Coder, y el modelo matemático Qwen2.5-Math, etc., con un total acumulado de más de 100 en las estanterías, y algunos de ellos alcanzando el rendimiento de la GPT-4o para establecer un nuevo récord mundial.

"Es un jueves de locos", "Producto épico" ...... En las pocas horas transcurridas desde su lanzamiento, Qwen2.5 ha desatado un frenesí de discusiones en las redes sociales nacionales e internacionales, y desarrolladores de todo el mundo se han unido al equipo de pruebas.

▲Qwen2.5 es un tema candente en las redes sociales nacionales e internacionales.

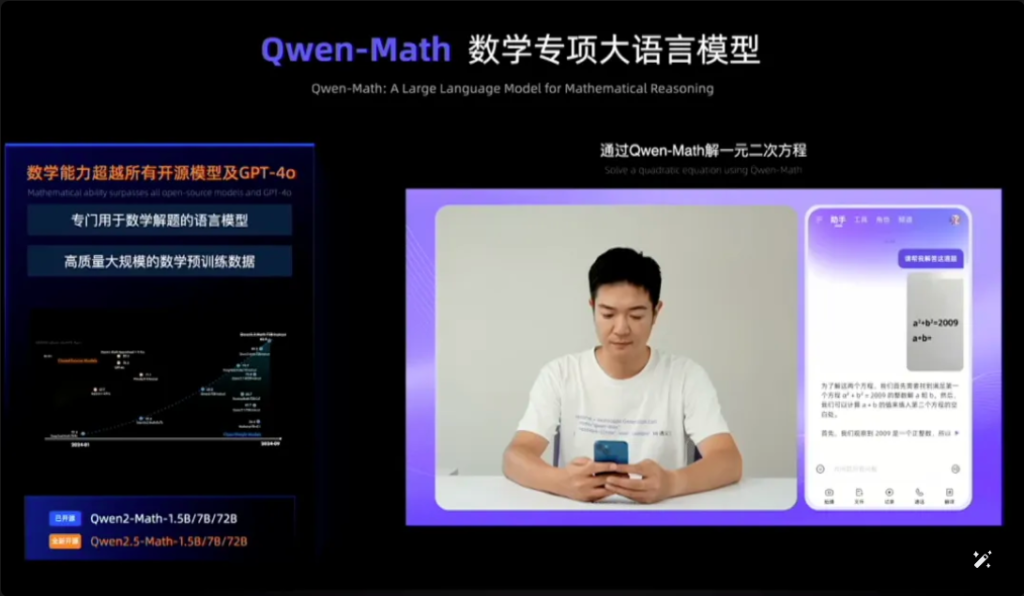

Qwen2.5-Math, por ejemplo, combina el reconocimiento visual con Qwen2.5-Math. Al introducir una captura de pantalla de una pregunta de opción múltiple geométricamente similar, Qwen2.5-Math reconoce rápidamente el significado de la pregunta y da la solución correcta y la respuesta "B", que es a la vez precisa y rápida. La precisión y la velocidad son asombrosas.

Es la primera vez que veo Qwen2.5-Math en la web.

▲Qwen2.5-Prueba de matemáticas

En solo un año y medio, desde abril de 2023, Qwen se ha convertido en un grupo de modelaje de talla mundial, solo superado por Llama.

Según los últimos datos publicados por Zhou Jingren, CTO de AliCloud, a mediados de septiembre de 2024, el número acumulado de descargas de modelos de código abierto de Tongyi Qwen ha superado los 40 millones, y se han derivado más de 50.000 modelos de gran tamaño.

▲Qwen serie derivada grandes modelos de más de 50.000

¿Cuáles son las mejoras específicas de rendimiento de Qwen 2.5? ¿Cuáles son los aspectos más destacados de los 100 nuevos modelos de código abierto? El Qwen2.5 es el primero de su clase en el mundo, y es el primero de su clase en China.

Dirección del blog: https://qwenlm.github.io/blog/qwen2.5/

Dirección del proyecto: https://huggingface.co/spaces/Qwen/Qwen2.5

▲El blog oficial publica los clústeres del modelo Aliyun Qwen 2.5

01.A la cabeza de la lista mundial de nuevo, Qwen2.5 cross-volume Catching up with Llama3.1-405B

Veamos en concreto el rendimiento de Qwen2.5.

El modelo Qwen2.5 admite hasta 128K de longitud de contexto, puede generar hasta 8K de contenido y es compatible con más de 29 idiomas, lo que significa que puede ayudar a los usuarios a escribir artículos de 10.000 palabras.

No sólo eso, basándose en 18T de datos de tokens de preentrenamiento, Qwen2.5 tiene más de 18% de mejora de rendimiento global en comparación con Qwen2, con más conocimientos y habilidades de programación y matemáticas más fuertes.

Zhou Jingren, director de tecnología de AliCloud, explica Qwen2.5

El modelo estrella, Qwen2.5-72B, obtuvo puntuaciones de 86,8, 88,2 y 83,1 en las pruebas de referencia MMLU-rudex (que examina los conocimientos generales), MBPP (que examina la capacidad de codificación) y MATH (que examina la capacidad matemática).

Qwen2.5, con sus 72.000 millones de parámetros, supera incluso a Llama3.1-405B, con sus 405.000 millones de parámetros, "en órdenes de magnitud".

Llama3.1-405B fue lanzado por Meta en julio de 2024, y en más de 150 conjuntos de pruebas de referencia, igualó o incluso superó al entonces modelo SOTA (el mejor de la industria) GPT-4o, desencadenando la afirmación de que "el modelo de código abierto más fuerte es el modelo más fuerte".

Qwen2.5-72B-Instruct, la versión de seguimiento de Qwen2.5, superó a Llama3.1-405B en MMLU-redux, MATH, MBPP, LiveCodeBench, Arena-Hard, AlignBench, MT-Bench, MultiPL-E y otras evaluaciones autorizadas. 405B.

Fotos

▲Qwen2.5-72B situación de evaluación del modelo

Qwen2.5 vuelve a ser el modelo de código abierto más sólido del mundo, contribuyendo a la tendencia del sector de "código abierto sobre código cerrado".

Se trata de AliCloud tras la serie de código abierto Tongyi Qianqian Qwen2 en junio de este año, alcanzando al entonces modelo de código abierto más fuerte Llama3-70B, y luego lanzando una serie de versiones de código abierto.

Se ha convertido en un ritmo familiar en la comunidad de desarrolladores de IA que cada nuevo rey que aparece es pronto superado por una nueva versión de Tongyi.

Tras la apertura de Qwen2.5 en la noche del 18 de septiembre, muchos desarrolladores estaban tan entusiasmados que no durmieron y lo probaron primero.

No estoy seguro de poder hacerlo.

Los desarrolladores nacionales e internacionales debaten acaloradamente sobre Qwen2.5

02.La mayor comunidad de modelos de la historia del mundo

Lo más importante es comprender bien lo que ocurre en el mundo y cómo funciona.

La comunidad de modelado de código abierto Qwen2.5 es la mayor que ha existido nunca.

Zhou Jingren, CTO de AliCloud, anunció en la conferencia de Yunqi que la serie Qwen2.5 sumaba más de 100 modelos de código abierto en las estanterías, adaptándose plenamente a las necesidades de desarrolladores y pymes en diversos escenarios.

Esto responde a las peticiones de muchos desarrolladores, que llevan mucho tiempo "urgiendo" en los principales medios sociales.

▲Los promotores nacionales e internacionales piden más Qwen2.5

1, modelo lingüístico: de 0,5B a 72B siete tamaños, de escenarios de uso final a escenarios de uso industrial cobertura total

Qwen2.5 ofrece siete tamaños de modelos lingüísticos de código abierto: 0,5B, 1,5B, 3B, 7B, 14B, 32B y 72B, todos los cuales han obtenido resultados SOTA en las pistas correspondientes.

Fotos

▲El Qwen2.5 de múltiples tamaños satisface las necesidades de diversos escenarios

Dadas sus avanzadas capacidades en Procesamiento del Lenguaje Natural (PLN) y comprensión de la codificación, Qwen2.5 de Alibaba Cloud está diseñado para manejar una amplia gama de aplicaciones. Estos son algunos escenarios específicos en los que se puede utilizar Qwen2.5:

- Mejor servicio al cliente: Qwen2.5 puede emplearse en chatbots para interacciones más parecidas a las humanas, respondiendo eficazmente a las consultas de los clientes y ofreciéndoles soluciones.

- Creación de contenidos: El modelo puede ayudar a generar artículos, publicaciones en redes sociales y otros contenidos escritos, ahorrando tiempo a los creadores de contenidos.

- Ayuda a la programación: Con su serie especializada Qwen2.5-Coder, puede ayudar a los desarrolladores sugiriéndoles fragmentos de código, ayuda para la depuración y automatización de determinadas tareas de codificación.

- Educación y Aprendizaje: Qwen2.5 puede utilizarse para desarrollar herramientas educativas como plataformas de aprendizaje interactivas que ofrecen explicaciones, responden a las preguntas de los alumnos e incluso califican las tareas.

- Servicios de traducción: Dado su dominio de múltiples idiomas, puede prestar servicios de traducción en tiempo real para salvar las distancias lingüísticas en la comunicación internacional.

- Investigación y desarrollo: En investigación, Qwen2.5 puede procesar grandes cantidades de datos de texto para ayudar a descubrir patrones, resumir hallazgos y generar informes.

- Asistencia jurídica: El modelo puede leer documentos jurídicos, extraer información relevante e incluso redactar documentos jurídicos básicos, lo que ahorra tiempo a los profesionales del Derecho.

- Asistencia sanitaria: Qwen2.5 puede utilizarse para responder a preguntas habituales sobre salud, proporcionar información médica y ayudar a gestionar los datos de los pacientes.

- Marketing y publicidad: Puede ayudar a crear contenidos de marketing personalizados, textos publicitarios y campañas en redes sociales dirigidas a públicos específicos.

- Análisis de datos: Qwen2.5 puede procesar y analizar grandes conjuntos de datos para proporcionar información y ayudar a tomar decisiones basadas en datos.

- Informes automatizados: El modelo puede generar informes procesando datos e información en diversas áreas, lo que resulta especialmente útil en el análisis financiero y empresarial.

- Desarrollo de juegos: Qwen2.5 puede ayudar a crear diálogos y narraciones interactivas para personajes de videojuegos con el fin de mejorar la participación de los jugadores.

- Asistente virtual: Impulsa asistentes virtuales que pueden gestionar horarios, establecer recordatorios y proporcionar asesoramiento personalizado.

- Comercio electrónico: Qwen2.5 puede ayudar a generar descripciones de productos, gestionar las consultas de los clientes y crear experiencias de compra personalizadas.

- Soporte multilingüe: Puede utilizarse en aplicaciones globales que requieran una interacción multilingüe, como la atención al cliente internacional o la localización de contenidos.

Estas versiones ayudan a los desarrolladores a equilibrar la capacidad y el coste del modelo, y a adaptarse a diversos escenarios. Por ejemplo, 3B es el tamaño de oro para adaptarse a los teléfonos móviles y otros dispositivos finales, 32B es el más esperado por los desarrolladores para ser el "rey de la rentabilidad", y 72B es el rey del rendimiento de los escenarios de grado industrial y de grado de investigación científica.

Dirección del blog: https://qwenlm.github.io/zh/blog/qwen2.5-llm/

2、Modelo multimodal: el modelo visual comprende 20 minutos de vídeo, el modelo audiolingüe admite 8 idiomas

Qwen2-VL-72B, el esperado modelo de lenguaje visual a gran escala, ha sido publicado hoy oficialmente en código abierto.

Qwen2-VL puede reconocer imágenes con distintas resoluciones y relaciones de aspecto, comprender vídeos largos de más de 20 minutos, tener la capacidad de regular las inteligencias visuales de teléfonos móviles y dispositivos, y superar el nivel GPT-4o de comprensión visual.

▲Modelo de lenguaje visual a gran escala Qwen2-VL-72B de código abierto

Qwen2-VL-72B se convirtió en el modelo de comprensión visual de código abierto con mayor puntuación en la evaluación global autorizada LMSYS Chatbot Arena Leaderboard.

Qwen2-VL-72B es el modelo de comprensión visual de código abierto con mayor puntuación.

El modelo de lenguaje de audio a gran escala Qwen2-Audio es un modelo de código abierto capaz de comprender la voz humana, la música y el sonido natural, soportar el chat de voz, el análisis de mensajes de audio y admitir más de 8 idiomas y dialectos, y es líder mundial en el índice de evaluación de la corriente principal.

Dirección del blog: http://qwenlm.github.io/blog/qwen2-vl/

3, modelo especial: debut del modelo matemático de código abierto más avanzado, a la altura del GPT-4o

Qwen2.5-Coder para programación y Qwen2.5-Math para matemáticas también se anunciaron como código abierto en esta Conferencia Cloud Habitat.

Entre ellos, Qwen2.5-Math es la serie de modelos matemáticos de código abierto más avanzada hasta la fecha, esta vez de código abierto de 1,5B, 7B, 72B tres tamaños y modelo de recompensa matemática Qwen2.5-Math-RM.

▲Qwen2.5-Math código abierto

El modelo insignia Qwen2-Math-72B-Instruct supera a modelos propios como GPT-4o y Claude 3.5 en tareas descendentes relacionadas con las matemáticas.

Qwen2.5-Coder, que se entrenó con hasta 5,5T de tokens de datos relacionados con la programación, se abrió el mismo día en las versiones 1.5B y 7B, y se abrirá en el futuro en la versión 32B.

Código abierto ▲Qwen2.5-Coder

Dirección del blog:

https://qwenlm.github.io/zh/blog/qwen2.5-math/

https://qwenlm.github.io/zh/blog/qwen2.5-coder/

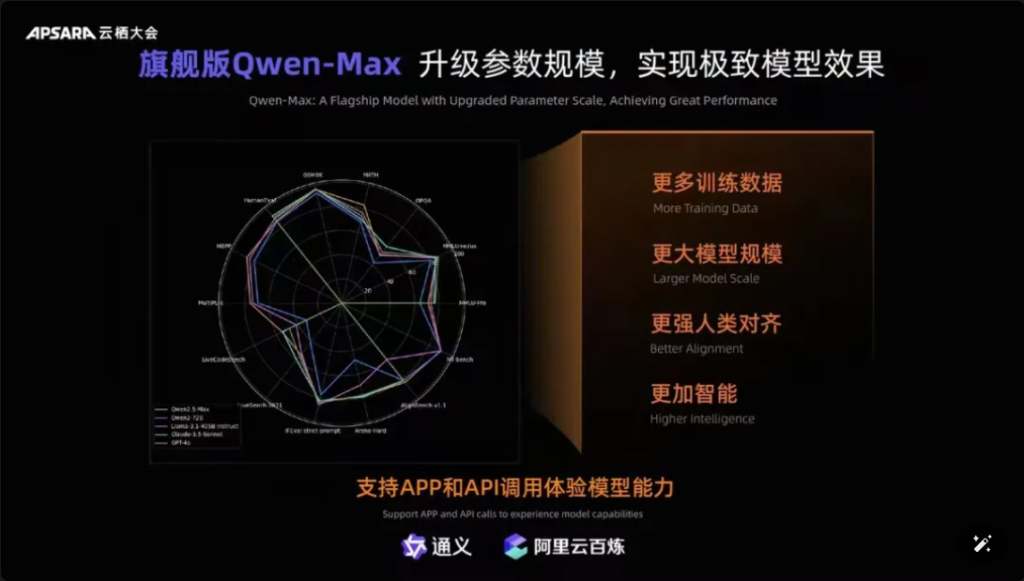

Además, cabe mencionar que Qwen-Max, el modelo insignia de Tongyiqianqian, se ha actualizado por completo, acercándose o incluso superando a GPT-4o en más de diez puntos de referencia autorizados, como MMLU-Pro, MATH, etc., y está en línea en el sitio web oficial de Tongyiqianqian y Tongyi APP. Los usuarios también pueden llamar a las API de Qwen-Max a través de la plataforma de refinamiento AliCloud Hundred.

Fotos

▲Qwen-Max realiza una actualización integral

Desde el lanzamiento de la primera generación del modelo grande Tongyi Qianqian en abril de 2023, AliCloud ha permitido a las empresas chinas utilizar el modelo grande a bajo costo, lo que a su vez ha impulsado a la serie Qwen2.5 actual a ser "cada vez más útil".

Los modelos de la serie Qwen2.5 cubren la versión básica, la versión de seguimiento de comandos y la versión cuantitativa, que se itera en escenarios del mundo real.

03.¡Qwen ha superado los 40 millones de descargas! Han nacido más de 50.000 "bebés".

Después de un año y medio de rápido desarrollo, Tongyi Qwen se ha convertido en un grupo modelo de clase mundial, solo superado por Llama.

Zhou Jingren anunció dos conjuntos de los últimos datos para confirmar esto:

En primer lugar, el número de descargas de modelos: a principios de septiembre de 2024, las descargas acumuladas de los modelos de código abierto de Tongyi Qianwen han superado los 40 millones, lo que es el resultado de que los desarrolladores y las pymes voten con sus pies;

El segundo es el número de modelos derivados: a principios de septiembre, el número total de modelos nativos y derivados de Tongyi superó los 50.000, solo superado por Llama.

▲Las descargas acumuladas del modelo de código abierto de Tongyi Thousand Questions superaron los 40 millones

Hasta ahora, los “10.000 modelos con la misma fuente” se han convertido en una tendencia significativa en el desarrollo de la industria de modelos a gran escala de China.

¿Cuál es el concepto? El código abierto chino no solo ocupa el primer lugar en el mundo en términos de rendimiento, sino también en términos de expansión ecológica. Las comunidades de código abierto, los socios ecológicos y los desarrolladores nacionales e internacionales se han convertido en el "agua del grifo" de Tongyi Chienqin, que se ha convertido en el primer gran modelo adoptado por muchas empresas, y también en el gran modelo utilizado durante más tiempo.

Ya en agosto de 2023, Aliyun lanzó de código abierto el modelo de 7 mil millones de parámetros de Tongyi Qwen para su comercialización gratuita, y luego este año se lanzaron Qwen1.5, Qwen2, Qwen2.5 uno tras otro, para que los desarrolladores puedan usar rápidamente el modelo más avanzado al mismo tiempo, para obtener un mayor control y espacio de ajuste, convirtiéndose así en la opción preferida de más empresas.

A principios de julio, los ingenieros de Hugging Face, la comunidad de código abierto más grande del mundo, tuitearon para certificar que Tongyi es la gran modelo más consolidada de China. Y a través de AliCloud, Tongyi Big Model ha prestado servicio a más de 300.000 clientes en varias industrias. En el segundo trimestre de 2024 (que corresponde al primer trimestre del año fiscal 2025 de Alibaba), los ingresos por productos relacionados con la IA de Aliyun alcanzaron un crecimiento de tres dígitos.

▲Tongyi Big Model atiende a más de 300.000 clientes

¿Qué hizo bien Aliyun?

En mi opinión, a diferencia de los grandes fabricantes extranjeros Microsoft y ChatGPT, la fuerte vinculación, la convergencia del modelo de tres partes de Amazon AWS para hacer la infraestructura subyacente, Aliyun integró las ventajas de los dos, desde el principio, eligió los servicios de infraestructura de IA y el modelo grande de autoinvestigación con las dos manos.

Centrándose en modelos de autoinvestigación, Ali Cloud es el único gigante de la nube en China que tiene muy claro el código abierto y la apertura del modelo, y no ha escatimado esfuerzos para hacer una gran inversión en avances de modelos, compatibilidad ecológica, servicios para desarrolladores, etc., a fin de hacer que los grandes modelos de Tongyi paso a paso entren en el círculo central de la competencia de IA del mundo.

04.Conclusión: Todos los modelos tienen el mismo origen Momento Cuenca Industria

Los modelos de código abierto están alcanzando o incluso alcanzando a los modelos de código cerrado. Desde el Llama-405B de Meta en julio hasta el Qwen2.5-72B de AliCloud en la actualidad, el panorama de "todos los modelos de la misma fuente" está tomando forma. El auge de un año y medio del modelo grande Tongyi Qianqi ha permitido que muchas industrias y empresas logren un aterrizaje a escala de IA de menor costo, y la industria está entrando en un nuevo momento decisivo.

FAQS

- P: ¿Cuáles son los diferentes tamaños de modelo disponibles para Qwen2.5? A: Qwen2.5 ofrece una gama de modelos desde 0.5B hasta 72B parámetros, brindando opciones para diversas aplicaciones y requisitos.

- P: ¿Cómo Qwen2.5 admite las tareas de programación? R: Qwen2.5 incluye una serie especializada llamada Qwen2.5-Coder, diseñada para mejorar la generación, inferencia y depuración de código, con soporte para hasta 128K tokens.

- P: ¿Cómo son los datos de entrenamiento para Qwen2.5? R: Qwen2.5 está previamente entrenado en un vasto conjunto de datos que cubre hasta 18 billones de tokens, lo que garantiza una amplia comprensión del lenguaje.

- P: ¿Qwen2.5 es adecuado para su uso en educación? R: Sí, las capacidades de Qwen2.5 en el procesamiento del lenguaje natural lo hacen adecuado para herramientas educativas, incluidas las plataformas de aprendizaje interactivas.

- P: ¿Cómo se comporta Qwen2.5 en las pruebas comparativas en comparación con otros modelos? R: Qwen2.5 actualmente ocupa el tercer lugar en los puntos de referencia multimodales, superando a modelos como Llama3.1 en varias áreas.

- P: ¿Qué idiomas admite Qwen2.5? R: Qwen2.5 admite varios lenguajes, incluidos, entre otros, Python, Java y C++.

- P: ¿Puede Qwen2.5 generar código en múltiples lenguajes de programación? R: Sí, Qwen2.5-Coder es capaz de generar código en varios lenguajes de programación, satisfaciendo las necesidades de diferentes desarrolladores.

- P: ¿Cómo maneja Qwen2.5 los contextos largos? R: Qwen2.5 admite longitudes de contexto de hasta 32K, lo que resulta beneficioso para mejorar la precisión de la finalización y la inferencia del código.

- P: ¿Qwen2.5 es de código abierto? R: Si bien aún no se ha lanzado la versión de código abierto de Qwen2.5, hay documentación detallada y ejemplos disponibles en plataformas como GitHub.

- P: ¿Cuáles son algunos escenarios de aplicación en el mundo real para Qwen2.5? R: Qwen2.5 se puede utilizar en chatbots de atención al cliente, creación de contenido, asistencia de programación, educación, servicios de traducción, asistencia legal, asistencia sanitaria, marketing, análisis de datos, informes automatizados, desarrollo de juegos, asistentes virtuales, comercio electrónico y soporte multilingüe en diversas industrias.