Die Downloads von Tongyi Qianqian Qwen überstiegen 40 Millionen und brachten mehr als 50.000 Kindermodels hervor.

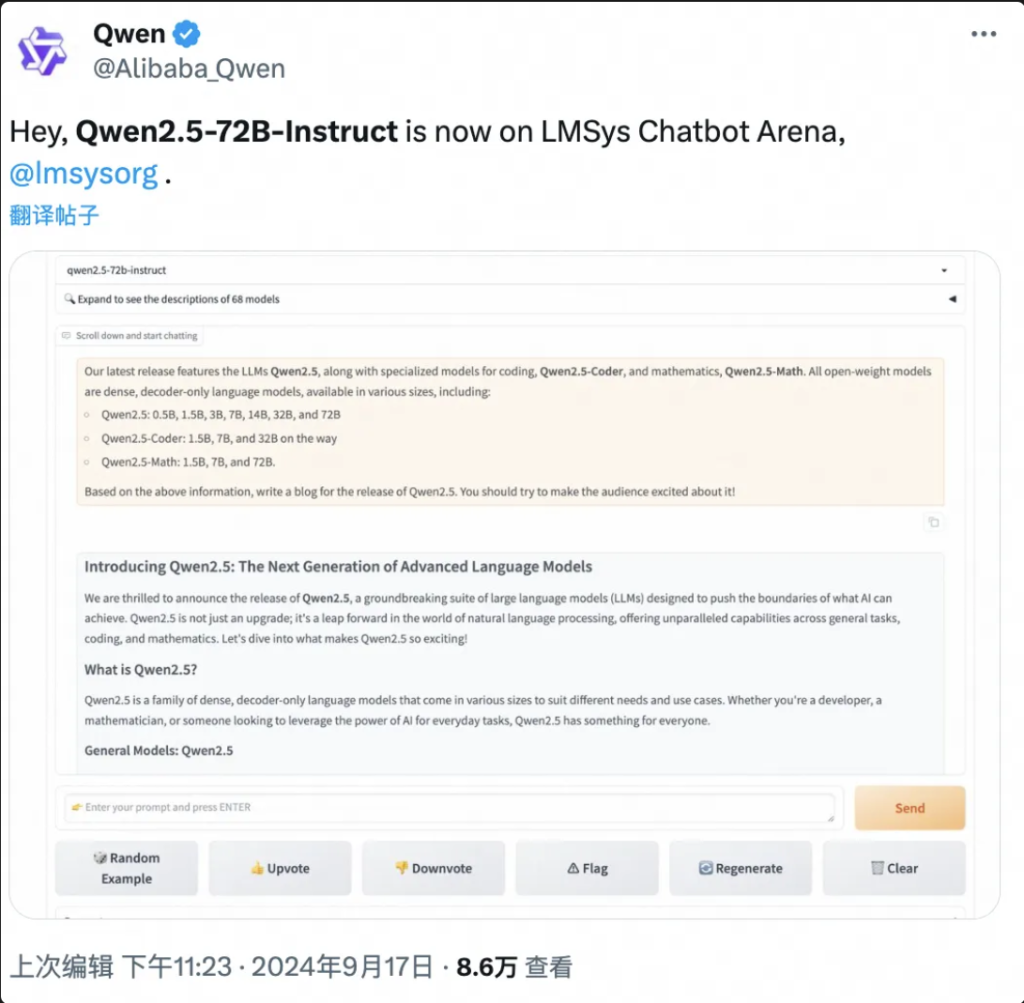

Kein Blödsinn, testen wir erst Qwen hier:

Die Cloud-Computing-Konferenz „Frühlingsfest-Gala“ in Yunqi wurde eröffnet und das große Model Tongyi Qwen ließ erneut die ganze Szene explodieren!

Wise Things berichtete am 19. September, dass Ali Cloud heute in Hangzhou das weltweit leistungsstärkste Open-Source-Großmodell Qwen2.5-72B auf den Markt gebracht hat, dessen Leistung Llama3.1-405B „übergreifend“ übertrifft und damit den Thron der globalen Open-Source-Großmodelle erobert.

Nachfolgend finden Sie eine Zusammenfassung der Ergebnisse der Arbeit an diesem Projekt

Qwen2.5-72B übertrifft Llama-405B in vielen maßgeblichen Tests.

Gleichzeitig wurde eine große Serie von Qwen2.5-Modellen als Open Source freigegeben, darunter das Sprachmodell Qwen2.5, das visuelle Sprachmodell Qwen2-VL-72B, das Programmiermodell Qwen2.5-Coder und das Mathematikmodell Qwen2.5-Math usw., mit einer Gesamtsumme von über 100 in den Regalen, und einige von ihnen holten mit der Leistung des GPT-4o auf und stellten einen neuen Weltrekord auf.

„Es ist verrückter Donnerstag“, „Epic Product“ …… In den wenigen Stunden seit seiner Veröffentlichung hat Qwen2.5 in den sozialen Medien im In- und Ausland eine Flut von Diskussionen ausgelöst, und Entwickler aus der ganzen Welt haben sich dem Testteam angeschlossen.

▲Qwen2.5 ist ein heißes Thema in den sozialen Medien im In- und Ausland.

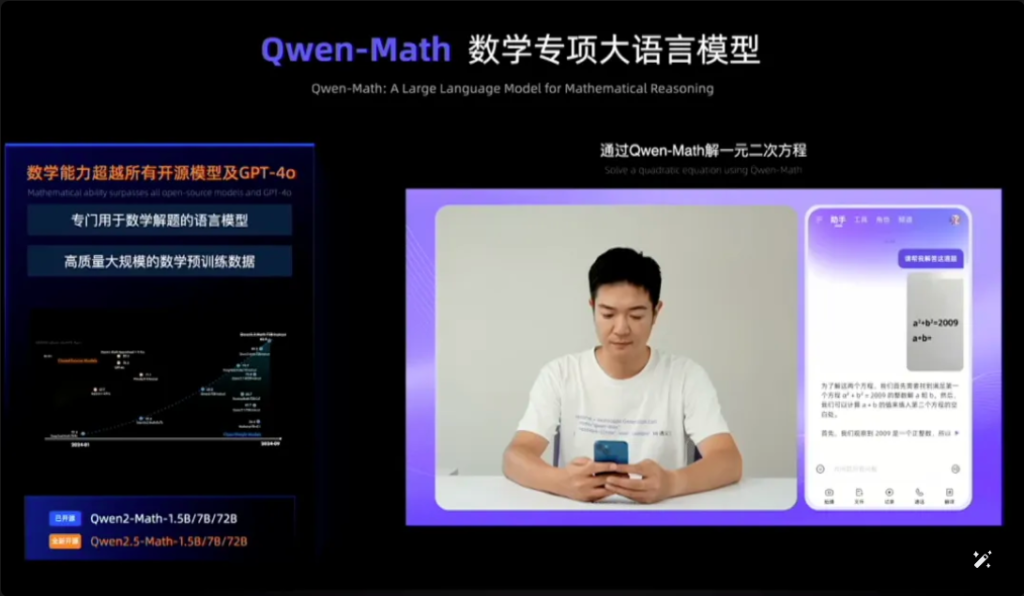

Qwen2.5-Math beispielsweise kombiniert visuelle Erkennung mit Qwen2.5-Math. Beim Eingeben eines Screenshots einer geometrisch ähnlichen Multiple-Choice-Frage erkennt Qwen2.5-Math schnell die Bedeutung der Frage und gibt die richtige Lösung und Antwort „B“ aus, was sowohl genau als auch schnell ist. Die Genauigkeit und Geschwindigkeit sind erstaunlich.

Dies ist das erste Mal, dass ich Qwen2.5-Math im Internet gesehen habe.

▲Qwen2.5-Math-Testversion

In nur eineinhalb Jahren seit April 2023 hat sich Qwen zu einer Modelgruppe von Weltklasse entwickelt, die nur von Llama übertroffen wird.

Laut den neuesten von Zhou Jingren, CTO von AliCloud, veröffentlichten Daten hat die kumulierte Zahl der Downloads der Open-Source-Modelle von Tongyi Qwen bis Mitte September 2024 40 Millionen überschritten und es wurden mehr als 50.000 große Modelle abgeleitet.

▲Qwen serie abgeleitet große modelle über 50,000

Was sind die spezifischen Leistungsverbesserungen von Qwen 2.5? Was sind die Highlights der 100 neuen Open-Source-Modelle? Qwen2.5 ist das erste seiner Art weltweit und das erste seiner Art in China.

Blog-Adresse: https://qwenlm.github.io/blog/qwen2.5/

Projektadresse: https://huggingface.co/spaces/Qwen/Qwen2.5

▲Offizielle Blog-Veröffentlichungen Aliyun Qwen 2.5 Modellcluster

01.Erneut an der Spitze der globalen Liste: Qwen2.5 Cross-Volume holt mit Llama3.1-405B gleich

Schauen wir uns insbesondere die Leistung von Qwen2.5 an.

Das Modell Qwen2.5 unterstützt eine Kontextlänge von bis zu 128 K, kann bis zu 8 K Inhalt generieren und unterstützt mehr als 29 Sprachen, was bedeutet, dass es Benutzern helfen kann, Artikel mit 10.000 Wörtern zu schreiben.

Darüber hinaus weist Qwen2.5 basierend auf dem Vortraining von 18T-Token-Daten eine Gesamtleistungsverbesserung von mehr als 18% im Vergleich zu Qwen2 auf und verfügt über mehr Wissen sowie stärkere Programmier- und Mathematikkenntnisse.

▲Zhou Jingren, CTO von AliCloud, erklärt Qwen2.5

Es wird berichtet, dass das Flaggschiffmodell, das Modell Qwen2.5-72B, beim MMLU-Rudex-Benchmark (der das Allgemeinwissen prüft), beim MBPP-Benchmark (der die Programmierfähigkeiten prüft) und beim MATH-Benchmark (der die mathematischen Fähigkeiten prüft) Werte von 86,8, 88,2 und 83,1 erreichte.

Qwen2.5 mit seinen 72 Milliarden Parametern übertrifft Llama3.1-405B mit seinen 405 Milliarden Parametern sogar „um Größenordnungen“.

Llama3.1-405B wurde im Juli 2024 von Meta veröffentlicht und erreichte in mehr als 150 Benchmark-Test-Sets das damalige SOTA-Modell (bestes der Branche) GPT-4o oder übertraf es sogar, was zu der Behauptung führte, dass „das stärkste Open-Source-Modell das stärkste Modell ist“.

Qwen2.5-72B-Instruct, die Nachfolgeversion von Qwen2.5, hat Llama3.1-405B in MMLU-Redux, MATH, MBPP, LiveCodeBench, Arena-Hard, AlignBench, MT-Bench, MultiPL-E und anderen maßgeblichen Bewertungen übertroffen. 405B.

Bilder

▲ Bewertungssituation des Modells Qwen2.5-72B

Qwen2.5 ist erneut das weltweit stärkste Open-Source-Modell und trägt zum Branchentrend „Open Source statt Closed Source“ bei.

Damit folgte AliCloud im Juni dieses Jahres der Open-Source-Serie Tongyi Qianqian Qwen2, holte zum seinerzeit stärksten Open-Source-Modell Llama3-70B auf und brachte anschließend eine Reihe von Open-Source-Versionen auf den Markt.

In der Community der KI-Entwickler ist es zu einem vertrauten Rhythmus geworden, dass jeder neue König, der erscheint, bald von einer neuen Version von Tongyi überholt wird.

Nachdem Qwen2.5 am Abend des 18. September eröffnet wurde, waren viele Entwickler so aufgeregt, dass sie nicht schliefen und es zuerst ausprobierten.

Ich bin nicht sicher, ob ich das schaffen werde.

▲Entwickler im In- und Ausland diskutieren heiß über Qwen2.5

02.Die größte Model-Community der Weltgeschichte

Das Wichtigste ist, ein gutes Verständnis davon zu haben, was in der Welt vor sich geht und wie sie funktioniert.

Die Open-Source-Modellierungs-Community von Qwen2.5 ist so groß wie nie zuvor.

Zhou Jingren, CTO von AliCloud, gab auf der Yunqi-Konferenz bekannt, dass die Qwen2.5-Serie insgesamt mehr als 100 Open-Source-Modelle auf Lager habe und sich vollständig an die Bedürfnisse von Entwicklern und KMU in verschiedenen Szenarien anpasse.

Damit wird den Forderungen vieler Entwickler Rechnung getragen, die bereits seit längerem in den großen sozialen Medien „drängen“.

▲Entwickler im In- und Ausland fordern mehr Qwen2.5

1. Sprachmodell: Sieben Größen von 0,5 B bis 72 B, vollständige Abdeckung von End- bis Industrieszenarien

Qwen2.5 stellt sieben Sprachmodelle in Open Source-Größen bereit, darunter 0,5B, 1,5B, 3B, 7B, 14B, 32B und 72B, die alle in den entsprechenden Tracks SOTA-Ergebnisse erzielt haben.

Bilder

▲ Qwen2.5 in verschiedenen Größen erfüllt die Anforderungen unterschiedlicher Szenarien

Aufgrund seiner fortgeschrittenen Fähigkeiten in der Verarbeitung natürlicher Sprache (NLP) und im Codierungsverständnis ist Qwen2.5 von Alibaba Cloud für eine breite Palette von Anwendungen ausgelegt. Hier sind einige spezifische Szenarien, in denen Qwen2.5 eingesetzt werden kann:

- Verbesserter Kundenservice: Qwen2.5 kann in Chatbots für menschlichere Interaktionen eingesetzt werden, um Kundenanfragen effektiv zu beantworten und Lösungen bereitzustellen.

- Inhaltserstellung: Das Modell kann bei der Erstellung von Artikeln, Social-Media-Posts und anderen schriftlichen Inhalten helfen und so den Erstellern von Inhalten Zeit sparen.

- Programmierhilfe: Mit seiner spezialisierten Qwen2.5-Coder-Reihe kann es Entwickler unterstützen, indem es Codeausschnitte vorschlägt, Hilfe beim Debuggen bietet und bestimmte Codierungsaufgaben automatisiert.

- Bildung und Lernen: Mit Qwen2.5 können pädagogische Tools wie interaktive Lernplattformen entwickelt werden, die Erklärungen bereitstellen, Fragen der Schüler beantworten und sogar Aufgaben benoten.

- Übersetzungsdienste: Aufgrund seiner Kompetenz in mehreren Sprachen kann es Echtzeit-Übersetzungsdienste bereitstellen, um die Sprachbarriere in der internationalen Kommunikation zu überbrücken.

- Forschung und Entwicklung: In der Forschung kann Qwen2.5 große Mengen an Textdaten verarbeiten, um bei der Erkennung von Mustern, der Zusammenfassung von Ergebnissen und der Erstellung von Berichten zu helfen.

- Rechtsberatung: Das Modell kann juristische Dokumente lesen, relevante Informationen extrahieren und sogar grundlegende juristische Dokumente entwerfen, wodurch Rechtsexperten Zeit sparen.

- Gesundheitsunterstützung: Mit Qwen2.5 können allgemeine Gesundheitsfragen beantwortet, medizinische Informationen bereitgestellt und bei der Verwaltung von Patientendaten geholfen werden.

- Marketing und Werbung: Es kann bei der Erstellung personalisierter Marketinginhalte, Anzeigentexte und Social-Media-Kampagnen helfen, die auf bestimmte Zielgruppen ausgerichtet sind.

- Datenanalyse: Qwen2.5 kann große Datensätze verarbeiten und analysieren, um Erkenntnisse zu liefern und bei der datengesteuerten Entscheidungsfindung zu helfen.

- Automatisiertes Reporting: Das Modell kann durch die Verarbeitung von Daten und Informationen aus verschiedenen Bereichen Berichte erstellen, was insbesondere bei Finanz- und Geschäftsanalysen nützlich ist.

- Spieleentwicklung: Qwen2.5 kann bei der Erstellung interaktiver Dialoge und Erzählungen für Videospielfiguren helfen, um die Beteiligung der Spieler zu erhöhen.

- Virtueller Assistent: Es steuert virtuelle Assistenten, die Zeitpläne verwalten, Erinnerungen festlegen und personalisierte Ratschläge geben können.

- Elektronischer Handel: Qwen2.5 kann bei der Erstellung von Produktbeschreibungen, der Bearbeitung von Kundenanfragen und der Schaffung personalisierter Einkaufserlebnisse helfen.

- Mehrsprachige Unterstützung: Es kann in globalen Anwendungen verwendet werden, die eine mehrsprachige Interaktion erfordern, wie etwa internationaler Kundendienst oder Inhaltslokalisierung.

Diese Versionen helfen Entwicklern, die Modellfähigkeit und die Kosten auszugleichen und sich an eine Vielzahl von Szenarien anzupassen. Beispielsweise ist 3B die goldene Größe für die Anpassung an Mobiltelefone und andere Endgeräte, 32B wird von den Entwicklern als „König der Kosteneffizienz“ angesehen und 72B ist der König der Leistung in Szenarien für Industrie- und wissenschaftliche Forschung.

Blog-Adresse: https://qwenlm.github.io/zh/blog/qwen2.5-llm/

2. Multimodales Modell: Das visuelle Modell versteht 20 Minuten Video, das audiolinguale Modell unterstützt 8 Sprachen

Qwen2-VL-72B, das mit Spannung erwartete visuelle Sprachmodell im großen Maßstab, ist heute offiziell Open Source.

Qwen2-VL kann Bilder mit unterschiedlichen Auflösungen und Seitenverhältnissen erkennen, lange Videos von über 20 Minuten verstehen, die visuelle Intelligenz von Mobiltelefonen und Geräten regulieren und das visuelle Verständnisniveau von GPT-4o übertreffen.

▲Groß angelegtes visuelles Sprachmodell Qwen2-VL-72B Open Source

Qwen2-VL-72B wurde in der weltweit maßgeblichen Bewertung LMSYS Chatbot Arena Leaderboard zum Open-Source-Modell für visuelles Verständnis mit der höchsten Punktzahl.

Qwen2-VL-72B ist das Open-Source-Modell für visuelles Verständnis mit der höchsten Punktzahl.

Das groß angelegte Audiosprachenmodell Qwen2-Audio ist ein Open-Source-Modell, das die menschliche Stimme, Musik und natürliche Geräusche verstehen kann, Voice-Chat und Audionachrichtenanalyse unterstützt und mehr als 8 Sprachen und Dialekte unterstützt. Es ist ein weltweit führender Anbieter im Mainstream-Bewertungsindex.

Blog-Adresse: http://qwenlm.github.io/blog/qwen2-vl/

3. Spezialmodell: Das fortschrittlichste Open-Source-Mathematikmodell debütiert und holt GPT-4o ein

Qwen2.5-Coder für die Programmierung und Qwen2.5-Math für Mathematik wurden auf dieser Cloud Habitat-Konferenz ebenfalls als Open Source angekündigt.

Unter ihnen ist Qwen2.5-Math die bislang fortschrittlichste Open-Source-Reihe mathematischer Modelle, diesmal in den drei Open-Source-Größen 1,5B, 7B und 72B sowie das mathematische Belohnungsmodell Qwen2.5-Math-RM.

▲Qwen2.5-Mathematik Open Source

Das Flaggschiffmodell Qwen2-Math-72B-Instruct übertrifft proprietäre Modelle wie GPT-4o und Claude 3.5 bei mathematikbezogenen Downstream-Aufgaben.

Qwen2.5-Coder, das mit bis zu 5,5 T Token programmierbezogener Daten trainiert wurde, wurde am selben Tag in den Versionen 1.5B und 7B als Open Source veröffentlicht und wird zukünftig in der Version 32B als Open Source veröffentlicht.

▲Qwen2.5-Coder Open Source

Blogadresse:

https://qwenlm.github.io/zh/blog/qwen2.5-math/

https://qwenlm.github.io/zh/blog/qwen2.5-coder/

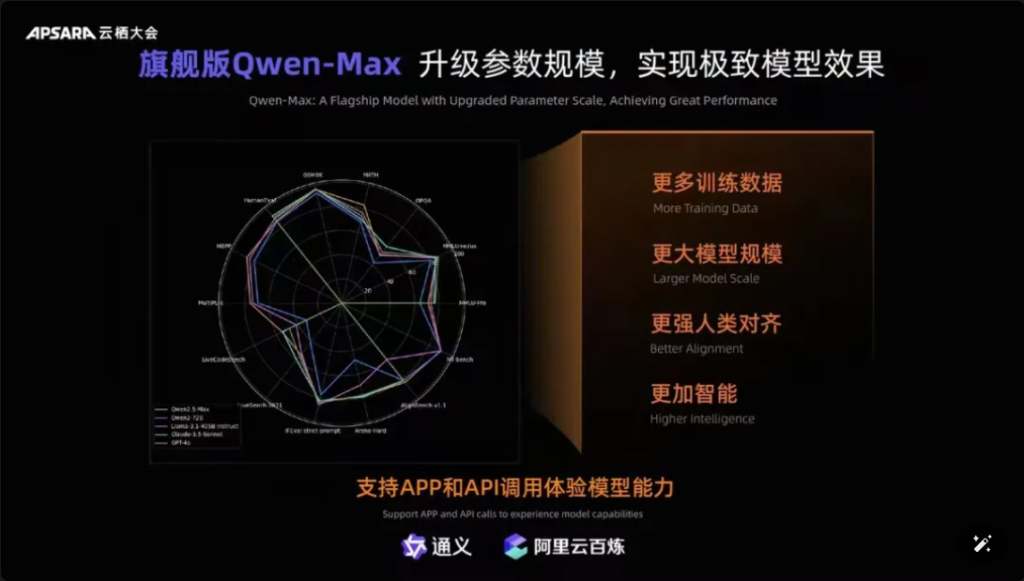

Darüber hinaus ist es erwähnenswert, dass Qwen-Max, das Flaggschiffmodell von Tongyiqianqian, vollständig aktualisiert wurde und sich GPT-4o bei mehr als zehn maßgeblichen Benchmarks wie MMLU-Pro, MATH usw. nähert oder es sogar übertrifft. Es ist auf der offiziellen Website von Tongyiqianqian und Tongyi APP online verfügbar. Benutzer können die APIs von Qwen-Max auch über die AliCloud Hundred Refinement Platform aufrufen.

Bilder

▲Qwen-Max realisiert umfassendes Upgrade

Seit der Veröffentlichung der ersten Generation des großen Modells von Tongyi Qianqian im April 2023 hat AliCloud chinesischen Unternehmen ermöglicht, das große Modell kostengünstig zu nutzen, was wiederum dazu geführt hat, dass die heutige Qwen2.5-Serie „immer nützlicher“ wird.

Die Modelle der Qwen2.5-Reihe decken die Basisversion, die Befehlsfolgeversion und die quantitative Version ab, die in realen Szenarien iteriert werden.

03. Die Downloads von Qwen haben 40 Millionen überschritten! Mehr als 50.000 „Babys“ wurden geboren.

Nach anderthalb Jahren rasanter Entwicklung ist Tongyi Qwen zu einer Weltklasse-Modelgruppe geworden, die nur von Llama übertroffen wird.

Zur Bestätigung dieser Aussage gab Zhou Jingren zwei Sätze neuester Daten bekannt:

Erstens die Anzahl der Modell-Downloads: Bis Anfang September 2024 hat die Gesamtzahl der Downloads der Open-Source-Modelle von Tongyi Qianwen 40 Millionen überschritten, was das Ergebnis der Abstimmung von Entwicklern und KMU ist.

Der zweite Aspekt ist die Anzahl der abgeleiteten Modelle: Anfang September überstieg die Gesamtzahl der nativen und abgeleiteten Modelle von Tongyi 50.000 und lag damit nur noch knapp hinter Llama.

▲ Die kumulierten Downloads des Open-Source-Modells „Tongyi Thousand Questions“ haben 40 Millionen überschritten

Bisher hat sich die Idee „10.000 Modelle mit derselben Quelle“ zu einem wichtigen Trend in der Entwicklung der chinesischen Großmodellindustrie entwickelt.

Was ist das Konzept? Chinesische Open Source steht nicht nur in Bezug auf Leistung, sondern auch in Bezug auf ökologische Expansion weltweit an erster Stelle. Open-Source-Communitys, ökologische Partner und Entwickler im In- und Ausland sind zum „Leitungswasser“ von Tongyi Chienqin geworden, das zum ersten großen Modell wurde, das von vielen Unternehmen übernommen wurde, und auch zum am längsten verwendeten großen Modell.

Bereits im August 2023 hat Aliyun das 7-Milliarden-Parameter-Modell von Tongyi Qwen als Open Source zur kostenlosen Kommerzialisierung freigegeben und in diesem Jahr nacheinander Qwen1.5, Qwen2 und Qwen2.5 veröffentlicht, sodass Entwickler schnell die fortschrittlichsten Modelle gleichzeitig nutzen und so mehr Kontroll- und Abstimmungsspielraum erhalten können, wodurch es zur bevorzugten Wahl von mehr Unternehmen wird.

Anfang Juli hatten Ingenieure von Hugging Face, der weltweit größten Open-Source-Community, in einem Tweet bestätigt, dass Tongyi das am weitesten verbreitete Big Model in China sei. Und über AliCloud hat Tongyi Big Model mehr als 300.000 Kunden in verschiedenen Branchen bedient. Im gerade abgelaufenen zweiten Quartal 2024 (entspricht dem ersten Quartal von Alibabas Geschäftsjahr 2025) verzeichneten Aliyuns Umsätze mit KI-bezogenen Produkten ein dreistelliges Wachstum.

▲Tongyi Big Model bedient mehr als 300.000 Kunden

Was hat Aliyun richtig gemacht?

Meiner Meinung nach integriert Aliyun die Vorteile der beiden, indem es sich von Anfang an für KI-Infrastrukturdienste und die Zwei-Parteien-Modelle für die eigene Forschung entscheidet. Dies ist anders als bei den großen ausländischen Herstellern Microsoft und ChatGPT, bei denen Amazon und AWS stark an einem Drei-Parteien-Modell zur Basisinfrastruktur arbeiten.

Ali Cloud konzentriert sich auf die Selbstforschung von Modellen und ist der einzige Cloud-Gigant in China, der sich voll und ganz auf Open Source und Offenheit bei Modellen konzentriert und keine Mühen gescheut hat, um enorme Investitionen in Modelldurchbrüche, ökologische Verträglichkeit, Entwicklerdienste usw. zu tätigen, um die großen Modelle von Tongyi Schritt für Schritt in den Kernkreis der weltweiten KI-Konkurrenz zu bringen.

04.Fazit: Alle Modelle haben den gleichen Ursprung Industrie Wendepunkt

Open-Source-Modelle holen auf oder holen sogar Closed-Source-Modelle ein. Von Metas Llama-405B im Juli bis zu AliClouds Qwen2.5-72B heute nimmt die Landschaft „alle Modelle aus derselben Quelle“ Gestalt an. Der anderthalbjährige Aufschwung des großen Tongyi-Qianqi-Modells hat es vielen Branchen und Unternehmen ermöglicht, kostengünstigere KI-Skalen zu realisieren, und die Branche tritt in einen neuen Wendepunkt ein.

FAQS

- F: Welche verschiedenen Modellgrößen sind für Qwen2.5 verfügbar? A: Qwen2.5 bietet eine Reihe von Modellen mit Parametern von 0,5 B bis 72 B und bietet Optionen für verschiedene Anwendungen und Anforderungen.

- F: Wie unterstützt Qwen2.5 Programmieraufgaben? A: Qwen2.5 umfasst eine spezialisierte Serie namens Qwen2.5-Coder, die die Codegenerierung, Inferenz und das Debuggen verbessern soll und bis zu 128.000 Token unterstützt.

- F: Wie sehen die Trainingsdaten für Qwen2.5 aus? A: Qwen2.5 ist auf einem riesigen Datensatz mit bis zu 18 Billionen Token vortrainiert und gewährleistet so ein umfassendes Sprachverständnis.

- F: Ist Qwen2.5 für den Einsatz im Bildungsbereich geeignet? A: Ja, die Fähigkeiten von Qwen2.5 zur Verarbeitung natürlicher Sprache machen es für Bildungstools, einschließlich interaktiver Lernplattformen, geeignet.

- F: Wie schneidet Qwen2.5 in Benchmarks im Vergleich zu anderen Modellen ab? A: Qwen2.5 belegt derzeit in multimodalen Benchmarks den dritten Platz und übertrifft Modelle wie Llama3.1 in mehreren Bereichen.

- F: Welche Sprachen unterstützt Qwen2.5? A: Qwen2.5 unterstützt mehrere Sprachen, einschließlich, aber nicht beschränkt auf Python, Java und C++.

- F: Kann Qwen2.5 Code in mehreren Programmiersprachen generieren? A: Ja, Qwen2.5-Coder kann Code in verschiedenen Programmiersprachen generieren und so den Anforderungen verschiedener Entwickler gerecht werden.

- F: Wie verarbeitet Qwen2.5 lange Kontexte? A: Qwen2.5 unterstützt Kontextlängen von bis zu 32 K, was sich positiv auf die Genauigkeit der Codevervollständigung und -inferenz auswirkt.

- F: Ist Qwen2.5 Open Source? A: Die Open-Source-Version von Qwen2.5 wurde noch nicht veröffentlicht, ausführliche Dokumentationen und Beispiele sind jedoch auf Plattformen wie GitHub verfügbar.

- F: Was sind einige reale Anwendungsszenarien für Qwen2.5? A: Qwen2.5 kann in Kundenservice-Chatbots, bei der Inhaltserstellung, in der Programmierunterstützung, im Bildungswesen, in Übersetzungsdiensten, in der Rechtshilfe, in der Gesundheitsunterstützung, im Marketing, in der Datenanalyse, in der automatisierten Berichterstattung, in der Spieleentwicklung, bei virtuellen Assistenten, im E-Commerce und in der mehrsprachigen Unterstützung in verschiedenen Branchen eingesetzt werden.