Descărcări Tongyi Qianqian Qwen au depășit 40 de milioane, „producând” mai mult de 50.000 de copii Modele.

Fără BS, să testăm mai întâi Qwen aici:

Cloud computing „Gala Festivalului de primăvară” a fost deschisă Conferința Yunqi, modelul mare Tongyi Qwen a explodat din nou întreaga scenă!

Lucruri înțelepte raportate pe 19 septembrie, Hangzhou, astăzi, Ali Cloud a lansat cel mai puternic model open source mare Qwen2.5-72B, performanță „măsură încrucișată” dincolo de Llama3.1-405B, iar apoi pe tronul modelului global open source mare.

Mai jos este un rezumat al rezultatelor lucrării la acest proiect

Qwen2.5-72B depășește Llama-405B în multe teste de autoritate.

În același timp, o serie mare de modele Qwen2.5 au fost apoi cu sursă deschisă, inclusiv: modelul de limbaj Qwen2.5, modelul de limbaj vizual Qwen2-VL-72B, modelul de programare Qwen2.5-Coder și modelul matematic Qwen2.5-Math etc., cu un total cumulat de peste 100 pe rafturile de performanță GPT, cu o performanță nouă în lumea GPT. înregistrare.

„Este o joia nebună”, „Produs epic” …… În cele câteva ore de la lansare, Qwen2.5 a declanșat o frenezie de discuții pe rețelele sociale din țară și din străinătate, iar dezvoltatorii din întreaga lume s-au alăturat echipei de testare.

▲Qwen2.5 este un subiect fierbinte pe rețelele sociale din țară și din străinătate.

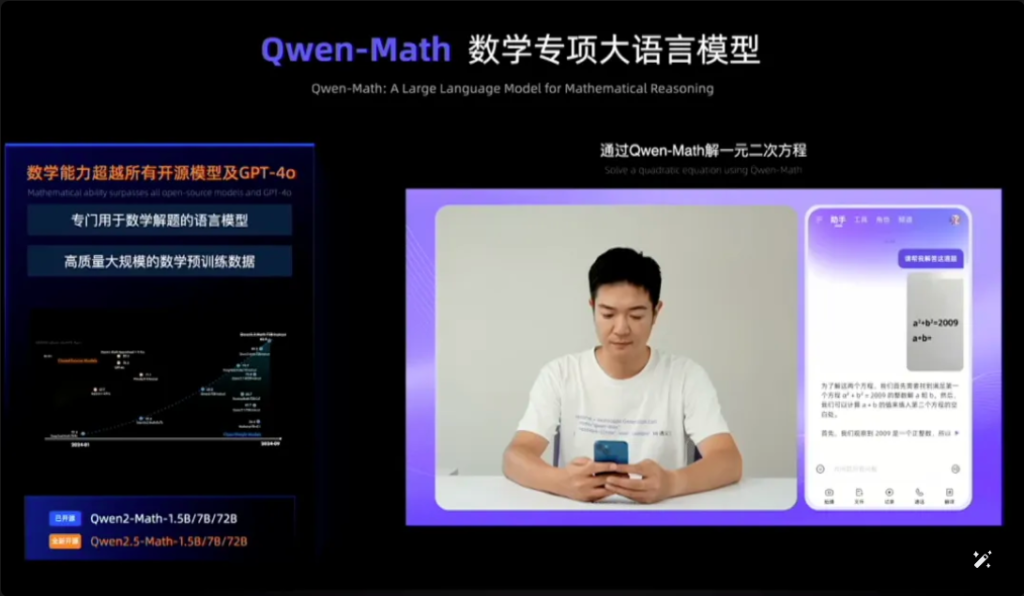

Qwen2.5-Math, de exemplu, combină recunoașterea vizuală cu Qwen2.5-Math. Când introduceți o captură de ecran a unei întrebări cu variante multiple similare din punct de vedere geometric, Qwen2.5-Math recunoaște rapid sensul întrebării și oferă soluția corectă și răspunsul „B”, care este atât precis, cât și rapid. Precizia și viteza sunt uimitoare.

Este prima dată când văd Qwen2.5-Math pe web.

▲Qwen2.5-Proba de matematică

În doar un an și jumătate din aprilie 2023, Qwen a devenit un grup de modeling de clasă mondială, al doilea după Llama.

Conform celor mai recente date publicate de Zhou Jingren, CTO al AliCloud, la jumătatea lunii septembrie 2024, numărul cumulat de descărcări ale modelelor open source ale Tongyi Qwen a depășit 40 de milioane și au fost derivate peste 50.000 de modele mari.

▲ Seria Qwen a derivat modele mari de peste 50.000

Care sunt îmbunătățirile specifice ale performanței Qwen 2.5? Care sunt punctele importante ale celor 100 de noi modele open source? Qwen2.5 este primul de acest gen din lume și este primul de acest fel din China.

Adresa blogului: https://qwenlm.github.io/blog/qwen2.5/

Adresa proiectului: https://huggingface.co/spaces/Qwen/Qwen2.5

▲ Blogul oficial lansează clustere de modele Aliyun Qwen 2.5

01. În fruntea listei globale din nou, Qwen2.5 încrucișat Catching up with Llama3.1-405B

Să aruncăm o privire la performanța Qwen2.5 în mod specific.

Modelul Qwen2.5 acceptă până la 128K lungime de context, poate genera până la 8K conținut și acceptă mai mult de 29 de limbi, ceea ce înseamnă că poate ajuta utilizatorii să scrie articole de 10.000 de cuvinte.

Nu numai că, pe baza pregătirii preliminare a datelor cu simboluri 18T, Qwen2.5 are o îmbunătățire generală a performanței cu peste 18% în comparație cu Qwen2, cu mai multe cunoștințe și abilități mai puternice de programare și matematică.

▲ CTO AliCloud Zhou Jingren explică Qwen2.5

Se raportează că modelul emblematic, modelul Qwen2.5-72B, a obținut un punctaj până la 86,8, 88,2 și 83,1 la benchmark-ul MMLU-rudex (care examinează cunoștințele generale), MBPP (care examinează capacitatea de codificare) și MATH (care examinează capacitatea de matematică).

Qwen2.5, cu cei 72 de miliarde de parametri ai săi, depășește chiar și Llama3.1-405B, cu cei 405 de miliarde de parametri, „în ordine de mărime”.

Llama3.1-405B a fost lansat de Meta în iulie 2024 și, în peste 150 de seturi de teste de referință, a egalat sau chiar depășit modelul SOTA de atunci (cel mai bun din industrie) GPT-4o, declanșând afirmația că „cel mai puternic model open-source este cel mai puternic model”.

Qwen2.5-72B-Instruct, versiunea ulterioară a Qwen2.5, a depășit Llama3.1-405B în MMLU-redux, MATH, MBPP, LiveCodeBench, Arena-Hard, AlignBench, MT-Bench, MultiPL-E și alte evaluări autorizate. 405B.

Poze

▲ Situația de evaluare a modelului Qwen2.5-72B

Qwen2.5 este din nou cel mai puternic model open source din lume, contribuind la tendința industriei de „open source în detrimentul închis”.

Acesta este AliCloud care urmează seria open source Tongyi Qianqian Qwen2 în iunie anul acesta, ajungând din urmă cu cel mai puternic model open source Llama3-70B și apoi lansând o serie de versiuni open source.

A devenit un ritm familiar în comunitatea de dezvoltatori AI că fiecare nou rege care apare este în curând depășit de o nouă versiune de Tongyi.

După ce Qwen2.5 a fost deschis în seara zilei de 18 septembrie, mulți dezvoltatori au fost atât de entuziasmați încât nu au dormit și au încercat mai întâi.

Nu sunt sigur dacă voi reuși să fac asta.

▲ Dezvoltatorii din țară și din străinătate discută cu căldură Qwen2.5

02.Cea mai mare comunitate de modeling din istoria lumii

Cel mai important lucru este să înțelegeți bine ce se întâmplă în lume și cum funcționează.

Comunitatea de modelare cu sursă deschisă Qwen2.5 este cea mai mare care a fost vreodată.

Zhou Jingren, CTO al AliCloud, a anunțat la conferința Yunqi că seria Qwen2.5 a însumat peste 100 de modele open source pe rafturi, adaptându-se pe deplin la nevoile dezvoltatorilor și IMM-urilor în diferite scenarii.

Acest lucru răspunde apelurilor multor dezvoltatori, care au „îndemnat” de mult timp în rețelele sociale importante.

▲ Dezvoltatorii din țară și din străinătate îndeamnă mai mult Qwen2.5

1, model de limbă: de la 0.5B la 72B șapte dimensiuni, de la final la scenarii de calitate industrială acoperire completă

Qwen2.5 deschide modele de șapte limbi de dimensiuni, inclusiv 0.5B, 1.5B, 3B, 7B, 14B, 32B și 72B, toate acestea au obținut rezultate SOTA în pistele corespunzătoare.

Poze

▲ Multi-size Qwen2.5 satisface nevoile diverselor scenarii

Având în vedere capabilitățile sale avansate de procesare a limbajului natural (NLP) și înțelegerea codării, Qwen2.5 de la Alibaba Cloud este proiectat pentru a gestiona o gamă largă de aplicații. Iată câteva scenarii specifice în care Qwen2.5 poate fi utilizat:

- Serviciu îmbunătățit pentru clienți: Qwen2.5 poate fi folosit în chatbot-uri pentru interacțiuni mai asemănătoare omului, răspunzând eficient la întrebările clienților și oferind soluții.

- Crearea continutului: Modelul poate ajuta la generarea de articole, postări pe rețelele sociale și alt conținut scris, economisind timp pentru creatorii de conținut.

- Asistență pentru programare: Cu seria sa specializată Qwen2.5-Coder, poate ajuta dezvoltatorii sugerând fragmente de cod, ajutor pentru depanare și automatizarea anumitor sarcini de codare.

- Educație și învățare: Qwen2.5 poate fi folosit pentru a dezvolta instrumente educaționale, cum ar fi platforme interactive de învățare, care oferă explicații, răspund la întrebările elevilor și chiar teme.

- Servicii de traducere: Având în vedere competența sa în mai multe limbi, poate oferi servicii de traducere în timp real pentru a reduce decalajul lingvistic în comunicarea internațională.

- Cercetare și dezvoltare: În cercetare, Qwen2.5 poate procesa cantități mari de date text pentru a ajuta la descoperirea modelelor, rezumarea constatărilor și generarea de rapoarte.

- Asistență juridică: Modelul poate citi documente juridice, extrage informații relevante și chiar elaborează documente juridice de bază, economisind timp profesioniștilor din domeniul juridic.

- Asistență medicală: Qwen2.5 poate fi folosit pentru a răspunde la întrebările comune de sănătate, pentru a furniza informații medicale și pentru a ajuta la gestionarea datelor despre pacient.

- Marketing și publicitate: Poate ajuta la crearea de conținut de marketing personalizat, de reclame și de campanii pe rețelele sociale care vizează un anumit public.

- Analiza datelor: Qwen2.5 poate procesa și analiza seturi mari de date pentru a oferi informații și a ajuta la luarea deciziilor bazate pe date.

- Raportare automată: Modelul poate genera rapoarte prin prelucrarea datelor și informațiilor într-o varietate de domenii, ceea ce este deosebit de util în analiza financiară și de afaceri.

- Dezvoltarea jocului: Qwen2.5 poate ajuta la crearea de dialoguri interactive și narațiuni pentru personajele din jocurile video pentru a spori implicarea jucătorilor.

- Asistent virtual: Acesta conduce asistenți virtuali care pot gestiona programe, pot stabili mementouri și pot oferi sfaturi personalizate.

- Comerț electronic: Qwen2.5 poate ajuta la generarea descrierilor produselor, la gestionarea întrebărilor clienților și la crearea unor experiențe de cumpărături personalizate.

- Asistență în mai multe limbi: Poate fi folosit în aplicații globale care necesită interacțiune multilingvă, cum ar fi serviciul internațional pentru clienți sau localizarea conținutului.

Aceste versiuni ajută dezvoltatorii să echilibreze capacitatea și costul modelului și să se adapteze la o varietate de scenarii. De exemplu, 3B este dimensiunea de aur pentru a se adapta la telefoanele mobile și alte dispozitive terminale, 32B este cel mai așteptat de dezvoltatori să fie „regele rentabilității”, iar 72B este regele performanței scenariilor de nivel industrial și de cercetare științifică.

Adresa blogului: https://qwenlm.github.io/zh/blog/qwen2.5-llm/

2、Model multimodal: modelul vizual înțelege 20 de minute de videoclip, modelul audio-lingv acceptă 8 limbi

Qwen2-VL-72B, foarte anticipat model de limbaj vizual la scară largă, este oficial open-source astăzi.

Qwen2-VL poate recunoaște imagini cu diferite rezoluții și rapoarte de aspect, poate înțelege videoclipuri lungi de mai mult de 20 de minute, are capacitatea de a regla inteligența vizuală a telefoanelor mobile și dispozitivelor și depășește nivelul GPT-4o de înțelegere vizuală.

▲ Model de limbaj vizual la scară largă Qwen2-VL-72B open source

Qwen2-VL-72B a devenit modelul open source de înțelegere vizuală cu cel mai mare scor în evaluarea globală autorizată LMSYS Chatbot Arena Leaderboard.

Qwen2-VL-72B este modelul de înțelegere vizuală open source cu cel mai mare scor.

Modelul de limbă audio la scară largă Qwen2-Audio este un model open source care poate înțelege vocea umană, muzica și sunetul natural, acceptă chatul vocal, analiza mesajelor audio și acceptă mai mult de 8 limbi și dialecte și este lider global în indexul de evaluare mainstream.

Adresa blogului: http://qwenlm.github.io/blog/qwen2-vl/

3, model special: cel mai avansat model matematic open source de debut, ajungând din urmă cu GPT-4o

Qwen2.5-Coder pentru programare și Qwen2.5-Math pentru matematică au fost, de asemenea, anunțate ca sursă deschisă la această conferință Cloud Habitat.

Printre acestea, Qwen2.5-Math este cea mai avansată serie de modele matematice open source până în prezent, de data aceasta open source 1.5B, 7B, 72B trei dimensiuni și modelul de recompensă matematică Qwen2.5-Math-RM.

▲Qwen2.5-Math open source

Modelul emblematic Qwen2-Math-72B-Instruct depășește modelele proprietare, cum ar fi GPT-4o și Claude 3.5, în sarcinile din aval legate de matematică.

Qwen2.5-Coder, care a fost antrenat pe până la 5.5T token-uri de date legate de programare, a fost open-source în aceeași zi în versiunile 1.5B și 7B și va fi open-source în viitor în versiunea 32B.

▲ Qwen2.5-Coder open source

Adresa blogului:

https://qwenlm.github.io/zh/blog/qwen2.5-math/

https://qwenlm.github.io/zh/blog/qwen2.5-coder/

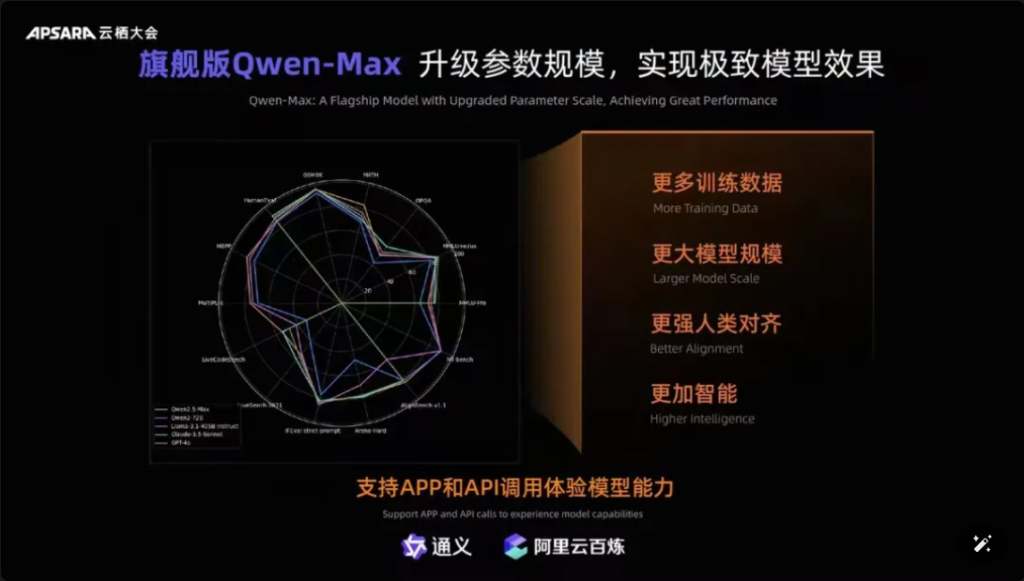

În plus, merită menționat faptul că Qwen-Max, modelul emblematic al Tongyiqianqian, a fost complet modernizat, apropiindu-se sau chiar depășind GPT-4o pe mai mult de zece benchmark-uri autorizate, precum MMLU-Pro, MATH etc., și este online pe site-ul oficial al Tongyiqianqian și Tongyi APP. Utilizatorii pot apela și API-urile Qwen-Max prin platforma AliCloud Hundred Refinement.

Poze

▲Qwen-Max realizează o actualizare completă

De la lansarea primei generații a modelului mare Tongyi Qianqian în aprilie 2023, AliCloud a permis întreprinderilor chineze să folosească modelul mare la costuri reduse, ceea ce, la rândul său, a făcut ca seria Qwen2.5 de astăzi să fie „din ce în ce mai utilă”.

Modelele din seria Qwen2.5 acoperă versiunea de bază, versiunea de urmărire a comenzii, versiunea cantitativă, care este repetată în scenariile din lumea reală.

03.Descărcările Qwen au depășit 40 de milioane! S-au născut peste 50.000 de „bebeluși”.

După un an și jumătate de dezvoltare rapidă, Tongyi Qwen a devenit un grup de modele de clasă mondială, al doilea după Llama.

Zhou Jingren a anunțat două seturi de cele mai recente date pentru a confirma acest lucru:

În primul rând, numărul de descărcări de modele, de la începutul lunii septembrie 2024, descărcările cumulate ale modelelor open source ale Tongyi Qianwen au depășit 40 de milioane, ceea ce este rezultatul votului de către dezvoltatori și IMM-uri cu picioarele;

Al doilea este numărul de modele derivate, la începutul lunii septembrie, numărul total de modele native și derivate ale lui Tongyi a depășit 50.000, al doilea după Llama.

▲Descărcările cumulate de modele open source Tongyi Thousand Questions au depășit 40 de milioane

Până acum, „10.000 de modele cu aceeași sursă” a devenit o tendință semnificativă în dezvoltarea industriei mari de modele din China.

Care este conceptul? Sursa deschisă chinezească nu se află doar pe primul loc în lume în ceea ce privește performanța, ci și în ceea ce privește expansiunea ecologică. Comunitățile open source, partenerii ecologici și dezvoltatorii din țară și din străinătate au devenit „apa de la robinet” a Tongyi Chienqin, care a devenit primul model mare adoptat de multe întreprinderi și, de asemenea, cel mai lung model mare utilizat.

Încă din august 2023, Aliyun a deschis modelul de 7 miliarde de parametri al Tongyi Qwen pentru comercializare gratuită, iar apoi Qwen1.5, Qwen2, Qwen2.5 din acest an au fost lansate unul după altul, astfel încât dezvoltatorii să poată folosi rapid cel mai avansat model în același timp, pentru a obține un control mai mare și spațiu de reglare, devenind astfel alegerea preferată a mai multor întreprinderi.

La începutul lunii iulie, inginerii de la Hugging Face, cea mai mare comunitate open source din lume, au scris pe Twitter pentru a certifica că Tongyi este cel mai mare model din China. Și prin AliCloud, Tongyi Big Model a deservit peste 300.000 de clienți din diverse industrii. În ultimul trimestru al doilea din 2024 (corespunzător trimestrului I al anului fiscal Alibaba 2025), veniturile din produse legate de IA ale Aliyun au înregistrat o creștere de trei cifre.

▲ Tongyi Big Model deservește peste 300.000 de clienți

Ce a făcut Aliyun corect?

În opinia mea, spre deosebire de marii producători străini Microsoft și ChatGPT legarea puternică, Amazon AWS convergență a modelului de trei părți pentru a face infrastructura de bază, Aliyun integrat avantajele celor două, la început, a ales să servicii de infrastructură AI și auto-cercetare model mare cu două mâini.

Concentrându-se pe modele de auto-cercetare, Ali Cloud este singurul gigant cloud din China care are o claritate clară în ceea ce privește modelul open source și deschidere și nu a prevenit nici un efort pentru a face o investiție uriașă în descoperiri de model, compatibilitate ecologică, servicii pentru dezvoltatori etc., astfel încât să facă modelele Tongyi mari pas cu pas în cercul de bază al competiției AI din lume.

04.Concluzie: Toate modelele au aceeași origine Industry Watershed Moment

Modelele open source ajung din urmă sau chiar ajung din urmă cu modelele cu sursă închisă. De la Llama-405B de la Meta în iulie până la Qwen2.5-72B de la AliCloud astăzi, peisajul „toate modelele din aceeași sursă” prinde contur. Creșterea de un an și jumătate a modelului mare Tongyi Qianqi a permis multor industrii și întreprinderi să realizeze o aterizare la scară AI cu costuri mai mici, iar industria intră într-un nou moment de cotitură.

Întrebări frecvente

- Î: Care sunt diferitele dimensiuni de model disponibile pentru Qwen2.5? R: Qwen2.5 oferă o gamă de modele de la 0,5B la 72B parametri, oferind opțiuni pentru diverse aplicații și cerințe.

- Î: Cum acceptă Qwen2.5 sarcinile de programare? R: Qwen2.5 include o serie specializată numită Qwen2.5-Coder, concepută pentru a îmbunătăți generarea de cod, inferența și depanarea, cu suport pentru până la 128.000 de jetoane.

- Î: Cum sunt datele de antrenament pentru Qwen2.5? R: Qwen2.5 este pre-antrenat pe un set vast de date care acoperă până la 18 trilioane de jetoane, asigurând o înțelegere largă a limbajului.

- Î: Qwen2.5 este potrivit pentru utilizare în educație? R: Da, capabilitățile Qwen2.5 în procesarea limbajului natural îl fac potrivit pentru instrumente educaționale, inclusiv platforme de învățare interactivă.

- Î: Cum funcționează Qwen2.5 în benchmark-uri în comparație cu alte modele? R: Qwen2.5 se află în prezent pe locul trei în benchmark-urile multimodale, depășind modele precum Llama3.1 în mai multe domenii.

- Î: Ce limbi acceptă Qwen2.5? R: Qwen2.5 acceptă mai multe limbi, inclusiv, dar fără a se limita la, Python, Java și C++.

- Î: Qwen2.5 poate genera cod în mai multe limbaje de programare? R: Da, Qwen2.5-Coder este capabil să genereze cod în diferite limbaje de programare, răspunzând nevoilor diferiților dezvoltatori.

- Î: Cum gestionează Qwen2.5 contextele lungi? R: Qwen2.5 acceptă lungimi de context de până la 32K, ceea ce este benefic pentru îmbunătățirea acurateței completării codului și a inferenței.

- Î: Qwen2.5 este open source? R: Deși versiunea open source a Qwen2.5 nu a fost încă lansată, documentația detaliată și exemple sunt disponibile pe platforme precum GitHub.

- Î: Care sunt câteva scenarii de aplicații din lumea reală pentru Qwen2.5? R: Qwen2.5 poate fi utilizat în chatbot-uri de servicii pentru clienți, crearea de conținut, asistență pentru programare, educație, servicii de traducere, asistență juridică, asistență medicală, marketing, analiză de date, raportare automată, dezvoltare de jocuri, asistenți virtuali, comerț electronic și suport multilingv în diverse industrii.