Tongyi Qianqian Qwen-nedlastinger oversteg 40 millioner, og "skapte" mer enn 50 000 barnemodeller.

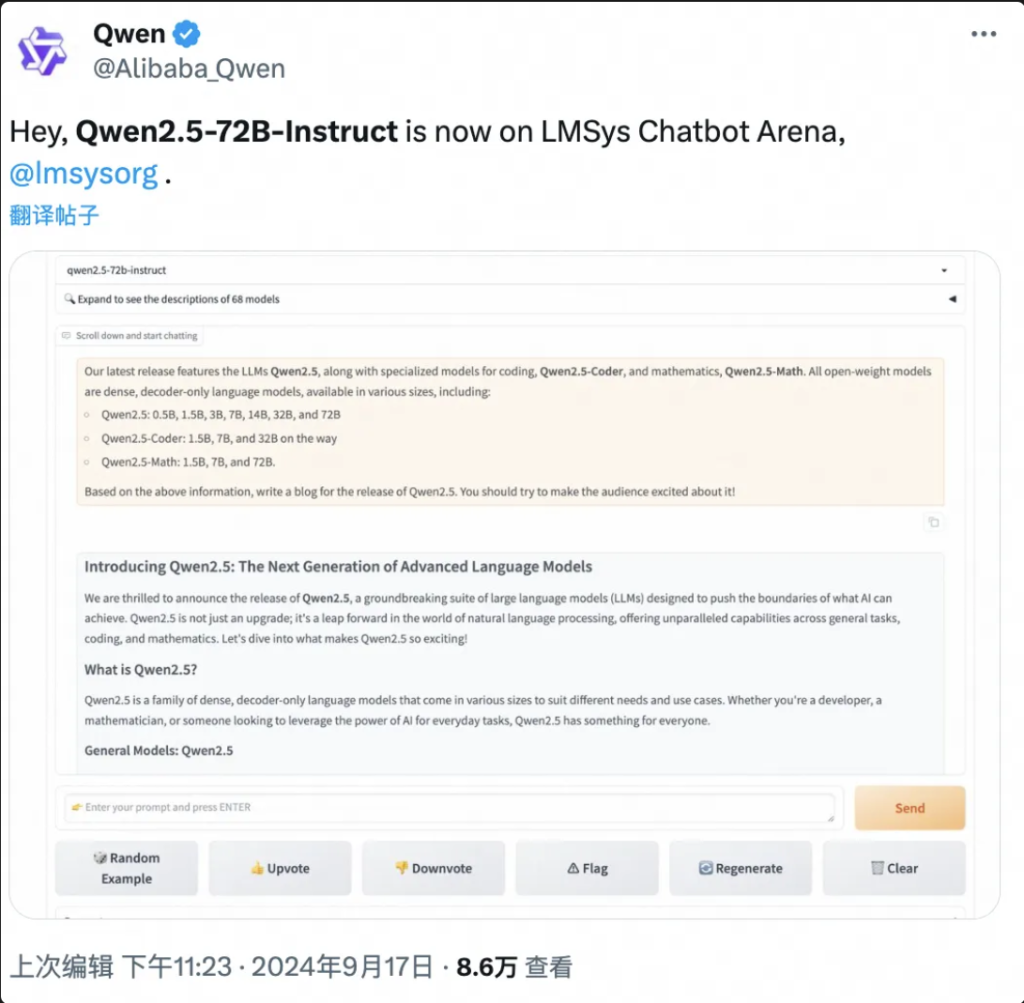

Ingen BS la først teste Qwen her:

Cloud computing "Spring Festival Gala" Yunqi-konferansen åpnet, Tongyi Qwen store modell eksploderte igjen hele scenen!

Kloke ting rapportert 19. september, Hangzhou, i dag lanserte Ali Cloud verdens sterkeste åpen kildekodemodell Qwen2.5-72B, ytelse "kryssmåling" utover Llama3.1-405B, og deretter på tronen til den globale åpen kildekodemodellen.

Følgende er en oppsummering av resultatene av arbeidet med dette prosjektet

Qwen2.5-72B overgår Llama-405B i mange autoritative tester.

Samtidig ble en stor serie av Qwen2.5-modeller deretter åpnet, inkludert: språkmodell Qwen2.5, visuell språkmodell Qwen2-VL-72B, programmeringsmodell Qwen2.5-Coder, og matematisk modell Qwen2.5-Math, etc., med en kumulativ total på mer enn 100 på hyllene til G-PT og noen av dem som fanger opp a-PT. ny verdensrekord.

«It's Crazy Thursday», 'Epic Product' …… I løpet av de få timene siden lanseringen har Qwen2.5 satt i gang en vanvidd av diskusjoner på sosiale medier i inn- og utland, og utviklere over hele verden har blitt med i testteamet.

▲Qwen2.5 er et hett tema på sosiale medier i inn- og utland.

Qwen2.5-Math, for eksempel, kombinerer visuell gjenkjenning med Qwen2.5-Math. Når du legger inn et skjermbilde av et geometrisk lignende flervalgsspørsmål, gjenkjenner Qwen2.5-Math raskt betydningen av spørsmålet og gir den riktige løsningen og svaret "B", som er både nøyaktig og raskt. Nøyaktigheten og hastigheten er utrolig.

Dette er første gang jeg har sett Qwen2.5-Math på nettet.

▲Qwen2.5-Math prøveversjon

På bare ett og et halvt år siden april 2023 har Qwen vokst til en modellgruppe i verdensklasse, nest etter Llama.

I følge de siste dataene utgitt av Zhou Jingren, CTO for AliCloud, i midten av september 2024, har det kumulative antallet nedlastinger av åpen kildekode-modeller av Tongyi Qwen overskredet 40 millioner, og mer enn 50 000 store modeller har blitt utledet.

▲Qwen-serien avledet store modeller over 50 000

Hva er de spesifikke ytelsesforbedringene til Qwen 2.5? Hva er høydepunktene til de 100 nye modellene med åpen kildekode? Qwen2.5 er den første i sitt slag i verden, og den er den første i sitt slag i Kina.

Bloggadresse: https://qwenlm.github.io/blog/qwen2.5/

Prosjektadresse: https://huggingface.co/spaces/Qwen/Qwen2.5

▲ Offisiell blogg lanserer Aliyun Qwen 2.5 Model Clusters

01. Topper den globale listen igjen, Qwen2.5 på tvers av volum. Henter opp med Llama3.1-405B

La oss ta en titt på ytelsen til Qwen2.5 spesifikt.

Qwen2.5-modellen støtter opptil 128K kontekstlengde, kan generere opptil 8K innhold og støtter mer enn 29 språk, noe som betyr at den kan hjelpe brukere med å skrive artikler på 10 000 ord.

Ikke nok med det, basert på 18T token data før-trening, har Qwen2.5 mer enn 18% generell ytelsesforbedring sammenlignet med Qwen2, med mer kunnskap og sterkere programmerings- og matematikkferdigheter.

▲AliCloud CTO Zhou Jingren forklarer Qwen2.5

Det er rapportert at flaggskipmodellen, Qwen2.5-72B-modellen, scoret så høyt som 86,8, 88,2 og 83,1 på MMLU-rudex-benchmark (som undersøker generell kunnskap), MBPP-benchmark (som undersøker kodingsevne) og MATH-benchmark (som undersøker matematikkevne).

Qwen2.5, med sine 72 milliarder parametere, overgår til og med Llama3.1-405B, med sine 405 milliarder parametere, «etter størrelsesordener».

Llama3.1-405B ble utgitt av Meta i juli 2024, og i mer enn 150 referansetestsett utlignet eller til og med overgått den daværende SOTA-modellen (best i bransjen) GPT-4o, og utløste påstanden om at "den sterkeste åpen kildekode-modellen er den sterkeste modellen".

Qwen2.5-72B-Instruct, oppfølgingsversjonen av Qwen2.5, overgikk Llama3.1-405B i MMLU-redux, MATH, MBPP, LiveCodeBench, Arena-Hard, AlignBench, MT-Bench, MultiPL-E og andre autoritative evalueringer. 405B.

Bilder

▲Qwen2.5-72B modellevalueringssituasjon

Qwen2.5 er igjen verdens sterkeste åpen kildekode-modell, og bidrar til bransjetrenden med "åpen kildekode over lukket kildekode".

Dette er AliCloud som følger åpen kildekode Tongyi Qianqian Qwen2-serien i juni i år, og fanger opp med den da sterkeste åpen kildekode-modellen Llama3-70B, og lanserer deretter en serie med åpen kildekode-versjoner.

Det har blitt en kjent rytme i AI-utviklerfellesskapet at hver ny konge som dukker opp snart blir overgått av en ny versjon av Tongyi.

Etter at Qwen2.5 ble åpnet om kvelden 18. september, var mange utviklere så begeistret at de ikke sov, og prøvde det først.

Jeg er ikke sikker på om jeg kommer til å klare det.

▲Utviklere i inn- og utland diskuterer Qwen2.5 heftig

02. Det største modellsamfunnet i verdenshistorien

Det viktigste er å ha en god forståelse av hva som skjer i verden og hvordan det fungerer.

Qwen2.5 open source-modelleringsfellesskapet er det største det noen gang har vært.

Zhou Jingren, CTO for AliCloud, kunngjorde på Yunqi-konferansen at Qwen2.5-serien hadde mer enn 100 åpen kildekode-modeller på hyllene, og tilpasset seg fullt ut behovene til utviklere og SMBer i ulike scenarier.

Dette svarer på oppfordringene fra mange utviklere, som har "manget" lenge i store sosiale medier.

▲Utviklere i inn- og utland oppfordrer til mer Qwen2.5

1, språkmodell: fra 0,5B til 72B syv størrelser, fra endeside til industrielle scenarier full dekning

Qwen2.5 åpner kildekode med syv språkmodeller, inkludert 0,5B, 1,5B, 3B, 7B, 14B, 32B og 72B, som alle har oppnådd SOTA-resultater i de tilsvarende sporene.

Bilder

▲Multi-size Qwen2.5 oppfyller behovene til ulike scenarier

Gitt sine avanserte evner innen Natural Language Processing (NLP) og kodingsforståelse, er Alibaba Clouds Qwen2.5 designet for å håndtere et bredt spekter av applikasjoner. Her er noen spesifikke scenarier der Qwen2.5 kan brukes:

- Forbedret kundeservice: Qwen2.5 kan brukes i chatbots for mer menneskelignende interaksjoner, effektivt svare på kundespørsmål og tilby løsninger.

- Oppretting av innhold: Modellen kan hjelpe til med å generere artikler, innlegg i sosiale medier og annet skriftlig innhold, og spare tid for innholdsskapere.

- Programmeringshjelp: Med sin spesialiserte Qwen2.5-Coder-serie kan den hjelpe utviklere ved å foreslå kodebiter, feilsøkingshjelp og automatisere visse kodeoppgaver.

- Utdanning og læring: Qwen2.5 kan brukes til å utvikle pedagogiske verktøy som interaktive læringsplattformer som gir forklaringer, svarer på elevspørsmål og til og med karakterer oppgaver.

- Oversettelsestjenester: Gitt sin kompetanse i flere språk, kan den tilby sanntidsoversettelsestjenester for å bygge bro over språkgapet i internasjonal kommunikasjon.

- Forskning og utvikling: I forskning kan Qwen2.5 behandle store mengder tekstdata for å hjelpe til med å oppdage mønstre, oppsummere funn og generere rapporter.

- Juridisk bistand: Modellen kan lese juridiske dokumenter, trekke ut relevant informasjon og til og med utarbeide grunnleggende juridiske dokumenter, noe som sparer tid for jurister.

- Helsestøtte: Qwen2.5 kan brukes til å svare på vanlige helsespørsmål, gi medisinsk informasjon og hjelpe til med å administrere pasientdata.

- Markedsføring og reklame: Det kan bidra til å lage personlig tilpasset markedsføringsinnhold, annonsetekst og sosiale mediekampanjer som retter seg mot bestemte målgrupper.

- Dataanalyse: Qwen2.5 kan behandle og analysere store datasett for å gi innsikt og hjelpe til med å ta datadrevne beslutninger.

- Automatisert rapportering: Modellen kan generere rapporter ved å behandle data og informasjon på en rekke områder, noe som er spesielt nyttig i finans- og forretningsanalyse.

- Spillutvikling: Qwen2.5 kan hjelpe til med å lage interaktiv dialog og fortellinger for videospillkarakterer for å øke spillerengasjementet.

- Virtuell assistent: Den driver virtuelle assistenter som kan administrere tidsplaner, sette påminnelser og gi personlig råd.

- E-handel: Qwen2.5 kan hjelpe med å generere produktbeskrivelser, håndtere kundehenvendelser og skape personlige handleopplevelser.

- Flerspråklig støtte: Den kan brukes i globale applikasjoner som krever flerspråklig interaksjon, for eksempel internasjonal kundeservice eller innholdslokalisering.

Disse versjonene hjelper utviklere med å balansere modellkapasiteten og kostnadene, og tilpasse seg en rekke scenarier. For eksempel er 3B den gyldne størrelsen for å tilpasse seg mobiltelefoner og andre enheter på endesiden, 32B er den mest forventede av utviklere å være "kongen av kostnadseffektive", og 72B er kongen av ytelsen til scenariene i industriell klasse og vitenskapelig forskning.

Bloggadresse: https://qwenlm.github.io/zh/blog/qwen2.5-llm/

2、Multimodal modell: visuell modell forstår 20 minutter med video, lydspråklig modell støtter 8 språk

Qwen2-VL-72B, den etterlengtede storskala visuelle språkmodellen, er offisielt åpen kildekode i dag.

Qwen2-VL kan gjenkjenne bilder med forskjellige oppløsninger og sideforhold, forstå lange videoer på mer enn 20 minutter, ha muligheten til å regulere den visuelle intelligensen til mobiltelefoner og enheter, og overgå GPT-4o-nivået for visuell forståelse.

▲Storskala visuell språkmodell Qwen2-VL-72B åpen kildekode

Qwen2-VL-72B ble den mest scorende åpen kildekode visuell forståelsesmodell i den globale autoritative evalueringen LMSYS Chatbot Arena Leaderboard.

Qwen2-VL-72B er den mest scorende visuelle forståelsesmodellen for åpen kildekode.

Qwen2-Audio storskala lydspråkmodell er en åpen kildekodemodell som kan forstå menneskelig stemme, musikk og naturlig lyd, støtte stemmechat, lydmeldingsanalyse og støtte mer enn 8 språk og dialekter, og den er en global leder innen mainstream-evalueringsindeks.

Bloggadresse: http://qwenlm.github.io/blog/qwen2-vl/

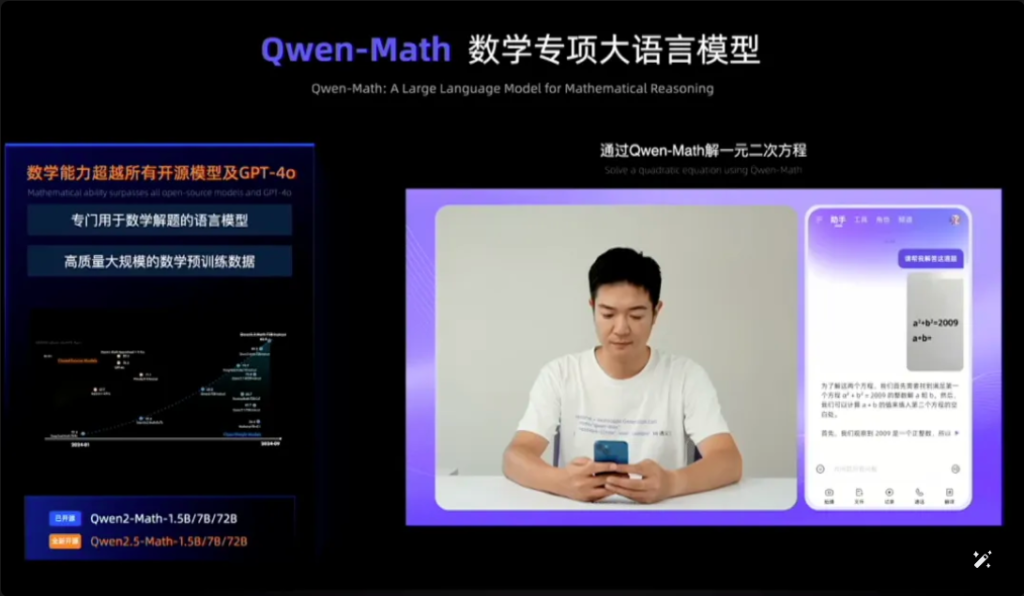

3, spesialmodell: den mest avanserte matematiske modellen med åpen kildekode, som fanger opp med GPT-4o

Qwen2.5-Coder for programmering og Qwen2.5-Math for matte ble også annonsert som åpen kildekode på denne Cloud Habitat-konferansen.

Blant dem er Qwen2.5-Math den mest avanserte matematiske modellserien med åpen kildekode til dags dato, denne gangen åpen kildekode 1.5B, 7B, 72B tre størrelser og matematisk belønningsmodell Qwen2.5-Math-RM.

▲Qwen2.5-Math åpen kildekode

Flaggskipsmodellen Qwen2-Math-72B-Instruct utkonkurrerer proprietære modeller som GPT-4o og Claude 3.5 i matematikkrelaterte nedstrømsoppgaver.

Qwen2.5-Coder, som ble trent på opptil 5.5T tokens med programmeringsrelaterte data, ble åpnet samme dag i versjon 1.5B og 7B, og vil være åpen kildekode i fremtiden i versjon 32B.

▲Qwen2.5-Coder åpen kildekode

Bloggadresse:

https://qwenlm.github.io/zh/blog/qwen2.5-math/

https://qwenlm.github.io/zh/blog/qwen2.5-coder/

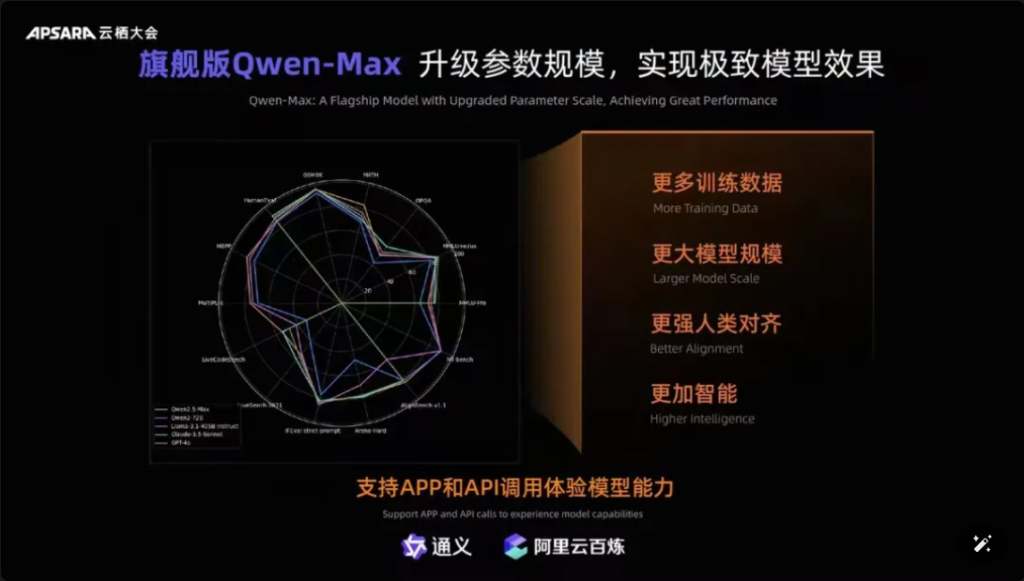

I tillegg er det verdt å nevne at Qwen-Max, flaggskipmodellen til Tongyiqianqian, har blitt fullstendig oppgradert, nærmer seg eller til og med overgått GPT-4o på mer enn ti autoritative benchmarks, som MMLU-Pro, MATH, etc., og er online på den offisielle nettsiden til Tongyiqianqian og Tongyi APP. Brukere kan også ringe Qwen-Max sine APIer gjennom AliCloud Hundred Refinement Platform.

Bilder

▲Qwen-Max realiserer omfattende oppgradering

Siden lanseringen av den første generasjonen av Tongyi Qianqian store modell i april 2023, har AliCloud gjort det mulig for kinesiske bedrifter å bruke den store modellen til lave kostnader, noe som igjen har drevet dagens Qwen2.5-serie til å bli "mer og mer nyttig".

Modeller i Qwen2.5-serien dekker grunnversjonen, kommandofølgende versjon, kvantitativ versjon, som gjentas i virkelige scenarier.

03.Qwen-nedlastinger oversteg 40 millioner! Mer enn 50 000 "babyer" er født.

Etter halvannet år med rask utvikling har Tongyi Qwen blitt en modellgruppe i verdensklasse som er nest etter Llama.

Zhou Jingren kunngjorde to sett med de siste dataene for å bekrefte dette:

For det første, antallet modellnedlastinger, fra begynnelsen av september 2024 har de kumulative nedlastingene av Tongyi Qianwens åpen kildekode-modeller oversteget 40 millioner, noe som er et resultat av at utviklere og SMB-er har stemt med føttene;

Den andre er antallet avledede modeller, fra begynnelsen av september oversteg det totale antallet av Tongyis opprinnelige og avledede modeller 50 000, bare nest etter Llama.

▲ Tongyi Thousand Questions open source-modell kumulative nedlastinger oversteg 40 millioner

Så langt har "10 000 modeller med samme kilde" blitt en betydelig trend i utviklingen av Kinas store modellindustri.

Hva er konseptet? Den kinesiske open source rangerer ikke bare først i verden når det gjelder ytelse, men også når det gjelder økologisk ekspansjon. Åpen kildekodesamfunn, økologiske partnere og utviklere i inn- og utland har blitt "kranvannet" til Tongyi Chienqin, som har blitt den første store modellen tatt i bruk av mange bedrifter, og også den mest brukte store modellen.

Allerede i august 2023 ga Aliyun åpen kildekode for 7 milliarder parametermodellen til Tongyi Qwen for å frigjøre kommersialisering, og deretter ble årets Qwen1.5, Qwen2, Qwen2.5 utgitt etter hverandre, slik at utviklere raskt kan bruke den mest avanserte modellen samtidig, for å få større kontroll og tuning plass, og dermed bli det foretrukne valget for flere bedrifter.

I begynnelsen av juli hadde ingeniører fra Hugging Face, verdens største åpen kildekode-samfunn, tweetet for å bekrefte at Tongyi er den mest sammenrullede store modellen i Kina. Og gjennom AliCloud har Tongyi Big Model betjent mer enn 300 000 kunder i ulike bransjer. I løpet av det siste andre kvartalet av 2024 (tilsvarende Q1 av Alibabas regnskapsår 2025), realiserte Aliyuns AI-relaterte produktinntekter tresifret vekst.

▲Tongyi Big Model betjener mer enn 300 000 kunder

Hva gjorde Aliyun riktig?

Etter min mening, i motsetning til de utenlandske store produsentene Microsoft og ChatGPT sterk binding, Amazon AWS konvergens av tre-parts modell for å gjøre den underliggende infrastrukturen, Aliyun integrerte fordelene med de to, i begynnelsen, valgte å AI infrastruktur tjenester og selv-forskning store modellen to-hånds.

Med fokus på selvforskningsmodeller, er Ali Cloud den eneste skygiganten i Kina som er tydelig på modell åpen kildekode og åpenhet, og har ikke spart på noen innsats for å gjøre en enorm investering i modellgjennombrudd, økologisk kompatibilitet, utviklertjenester osv., for å gjøre Tongyi store modeller steg for steg inn i kjernesirkelen av verdens AI-konkurranse.

04.Konklusjon: Alle modellene har samme opprinnelse Industry Watershed Moment

Åpen kildekode-modeller tar igjen eller tar igjen lukket kildekode-modeller. Fra Metas Llama-405B i juli til AliClouds Qwen2.5-72B i dag, tar landskapet med «alle modeller fra samme kilde» form. Den halvannet år lange økningen av den store Tongyi Qianqi-modellen har gjort det mulig for mange bransjer og bedrifter å realisere landing i AI-skala med lavere kostnader, og industrien går inn i et nytt vannskille.

Vanlige spørsmål

- Spørsmål: Hva er de forskjellige modellstørrelsene tilgjengelig for Qwen2.5? A: Qwen2.5 tilbyr en rekke modeller fra 0,5B til 72B parametere, og gir alternativer for ulike bruksområder og krav.

- Spørsmål: Hvordan støtter Qwen2.5 programmeringsoppgaver? A: Qwen2.5 inkluderer en spesialisert serie kalt Qwen2.5-Coder, designet for å forbedre kodegenerering, inferens og feilsøking, med støtte for opptil 128K tokens.

- Spørsmål: Hvordan er treningsdataene for Qwen2.5? A: Qwen2.5 er forhåndstrent på et stort datasett som dekker opptil 18 billioner tokens, noe som sikrer en bred forståelse av språk.

- Spørsmål: Er Qwen2.5 egnet for bruk i utdanning? A: Ja, Qwen2.5s evner innen naturlig språkbehandling gjør den egnet for pedagogiske verktøy, inkludert interaktive læringsplattformer.

- Spørsmål: Hvordan presterer Qwen2.5 i benchmarks sammenlignet med andre modeller? A: Qwen2.5 rangerer for tiden på tredjeplass i multimodale benchmarks, og overgår modeller som Llama3.1 på flere områder.

- Spørsmål: Hvilke språk støtter Qwen2.5? A: Qwen2.5 støtter flere språk, inkludert men ikke begrenset til Python, Java og C++.

- Spørsmål: Kan Qwen2.5 generere kode på flere programmeringsspråk? A: Ja, Qwen2.5-Coder er i stand til å generere kode på forskjellige programmeringsspråk, og imøtekomme behovene til forskjellige utviklere.

- Spørsmål: Hvordan håndterer Qwen2.5 lange sammenhenger? A: Qwen2.5 støtter kontekstlengder opp til 32K, noe som er fordelaktig for å forbedre nøyaktigheten av kodefullføring og inferens.

- Spørsmål: Er Qwen2.5 åpen kildekode? A: Mens åpen kildekode-versjonen av Qwen2.5 ennå ikke er utgitt, er detaljert dokumentasjon og eksempler tilgjengelig på plattformer som GitHub.

- Spørsmål: Hva er noen virkelige applikasjonsscenarier for Qwen2.5? A: Qwen2.5 kan brukes i kundeservice chatbots, innholdsskaping, programmeringshjelp, utdanning, oversettelsestjenester, juridisk bistand, helsetjenester, markedsføring, dataanalyse, automatisert rapportering, spillutvikling, virtuelle assistenter, e-handel og flerspråklig støtte på tvers av ulike bransjer.